1.本说明书一个或多个实施例涉及图像处理技术领域,尤其涉及一种用于证件图像的检测识别方法。

背景技术:

2.随着人工智能和信息技术的发展,目前已经研发出一种专门用于证件类照片的自助拍照设备,借助该设备,群众可以自己完成身份证、驾驶证和出入境证件照片的拍摄、自动裁剪、质量评估、付费以及上传公安网等流程,既方便了群众,节省时间,也减轻了公安部门的工作量。该设备涉及人像自动抠图、人脸特征点估计、人脸姿态估计和图像质量评估等技术;在群众使用自助拍摄设备时,需要采用人工智能技术自动估算人脸姿态,实时地提醒用户调整坐姿、头部姿势,以便拍摄出合格的证件照片;人脸特征点估计可以有效地辅助完成符合公安部标准的照片裁剪;此外,证件类照片一般不允许用户配戴眼镜,因此还需要自动识别是否佩戴眼镜。

3.目前现有技术中有很多基于深度的人脸特征点估计算法;其中采用深度学习算法,提出多任务学习的人脸特征点检测(zhanpeng zhang,ping luo,chenchange loy,xiaoou tang.facial landmark detection by deep multi-task learning, in proceedings of european conference on computer vision(eccv),2014),但该算法只提取五个关键点,即左右眼中心、左右嘴角点和鼻尖点;提出一种渐进表征学习的网络结构,用于提取5点人脸特征(lingbo liu,guanbin li,yuan xie, yizhou yu,qing wang and liang lin,“facial landmark machines:abackbone-branches architecture with progressive representation learning.”,ieeetransactions on mulitmedia,2019);人脸68个特征点是目前比较流行的人脸特征点标注方式,也是研究和应用比较多的模式,因为68个特征点可以提供比较丰富的信息;目前,传统方法已经实现了68特征点检测,如dlib库 (http://dlib.net/face_landmark_detection_ex.cpp.html)。

4.人脸姿态估计即给定一张人脸图像确定其脸部朝向的角度信息,人脸的姿态可以通过相对于x、y、z坐标轴的旋转角度进行确定,这三个坐标轴的偏转分别称为pitch(上下翻转),yaw(左右旋转),roll(左右倾斜);目前,人脸姿态估计的主要方法有:(1)基于随机森林模式识别的方法;(2)基于卷积神经网络的方法;(3)基于几何计算的方法;(4)基于粒子群滤波及优化的方法; (5)基于目标跟踪的方法。四川大学提出了基于深度学习的人脸姿态估计 (computer technology and development,10oct,2016,chengdu,china),该工作是在cas-peal数据集上进行的,提取检测到的人的面部区域,并将面部区域输入到网络中,当使用不同的人脸姿态时,脸部角度也不同,并且神经网络可以将样本映射到不同的空间,从而实现人脸姿态估计算法。长春工业大学提出了一种多视角人脸姿态估计算法(journal of changchun university, january,2004,changchun,china),基于内核主元分析(kernel principlecomponent analysis,kpca)的人脸特征提取算法,结合有独立子空间分析 (independent subspace analysis,isa)观察子空间学习,最后提出isa人脸姿

态估计算法,该算法采用kpca分析方法实现,该方法主要通过分析人脸特征,人脸图像来形成特征向量集。最后通过isa分析形成特征子空间,无需增加复杂度即可实现人脸姿态估计,同时获得相对较高的精度。lex fridman等人(ietcomputer vision,2016,vol.10,no.4,pp.308-313)提出利用几何方法即人脸特征的特征点坐标的空间位置来估计人脸姿态,利用cdf方法检测瞳孔角度。最后将头部姿态与瞳孔结合,采用随机森林训练预估模型,实现了人脸姿态估计算法。dornaika等人(ieee transactions on circuits and systems for videotechnology,2006,vol.6,no.9,pp.1107-1124)通过粒子滤波使用自适应外观模型来跟踪三维面部姿态和面部内部特征的局部运动的内在联系进行人脸姿态估计。posit是一种点对点匹配的算法,它利用二维图像特征点和三维图像关键特征点来估计人脸姿态。使用这种方法时,需要找出三维人脸模型的特征点位置对应的二维平面特征点,计算两者之间的旋转、投影、和平移矩阵,通过二维图像特征点位置估计出三维人脸朝向。

5.可见,现有的传统估计算法只是分别采用多种不同的算法估计人脸特征点和人脸姿态,既不准确,且速度比较慢,影响用户交互体验,也没有眼镜佩戴识别功能;因此提供一种用于证件图像的检测识别方法是本领域技术人员亟待解决的技术问题。

技术实现要素:

6.有鉴于此,本说明书一个或多个实施例的目的在于提出一种用于证件图像的检测识别方法,以解决在对于证件图像进行处理时无法同时实现68个人脸特征点、3个人脸姿态角和1个眼镜佩戴状态检测识别的问题。

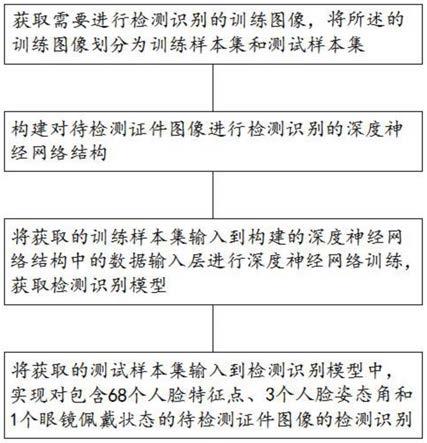

7.基于上述目的,本说明书一个或多个实施例提供了一种用于证件图像的检测识别方法,包括:

8.步骤1、获取需要进行检测识别的训练图像,将所述的训练图像划分为训练样本集和测试样本集;所述的训练图像为已标注人脸特征点、人脸姿态角和眼镜佩戴状态的证件图像;

9.步骤2、构建对待检测证件图像进行检测识别的深度神经网络结构;

10.所述的深度神经网络结构包括数据输入层、第一次残差下采样层、第二次残差下采样层、第三次残差下采样层、第四次残差下采样和全局池化层、第五次残差下采样和全局池化层、第六次残差下采样和全局池化层、全连接层和输出层,将输出层与混合损失函数相连接;

11.步骤3、将步骤1中获取的训练样本集输入到步骤2构建的深度神经网络结构中的数据输入层进行深度神经网络训练,获取检测识别模型;

12.训练时的损失函数采用步骤2中的混合损失函数,将混合损失函数的输出反馈给网络,对网络进行循环迭代训练使得混合损失函数最小;

13.步骤4、将步骤1中获取的测试样本集输入到检测识别模型中,实现对包含68个人脸特征点、3个人脸姿态角和1个眼镜佩戴状态的待检测证件图像的检测识别。

14.优选的,所述的步骤3中将步骤1中获取的训练样本集输入到步骤2构建的深度神经网络结构中的数据输入层进行深度神经网络训练,获取检测识别模型,包括:

15.步骤3.1、对输入到深度神经网络的训练样本集依次进行三次残差下采样处理,获取第一特征图;

16.步骤3.2、将经过步骤3.1处理后获取的第一特征图分为2路,第1路继续进行残差下采样处理,获取第二特征图;第2路进行全局池化处理,获取第三特征图;

17.步骤3.3、将经过步骤3.2处理后获取的第二特征图分为2路,第1路继续进行残差下采样处理,获取第四特征图;第2路进行全局池化处理,获取第五特征图;

18.步骤3.4、将经过步骤3.3处理后获取的第四特征图分为2路,第1路继续进行残差下采样处理,获取第六特征图;第2路进行全局池化处理,获取第七特征图;

19.步骤3.5、将三次全局池化处理所获取的第三特征图、第五特征图和第七特征图中的池化特征进行复制连接,以全连接的方式获取多尺度的输出特征向量。

20.优选的,所述的残差下采样处理包括利用平均池化、最大池化和卷积3 种下采样方式,将3种下采样方式的结果进行相加,获得残差下采样结构。

21.优选的,所述的混合损失函数包括:

[0022][0023]

其中,为68个人脸特征点的均方误差损失函数,为3个人脸姿态角的均方误差损失函数,为单通道眼镜佩戴状态交叉熵损失函数,λ1、λ2和λ3分别为和的加权系数;

[0024]

68个人脸特征点的均方误差损失函数定义如下:

[0025][0026]

其中,和为预测得到第k幅人脸图像的第i个人脸特征点坐标,和为人工标注的第k幅人脸图像的第i个人脸特征点坐标,n为训练样本集中人脸图像总数量;

[0027]

3个人脸姿态角的均方误差损失函数定义如下:

[0028][0029]

其中,和分别为第k幅人脸图像的姿态角pitch的预测值和标注值,和分别为第k幅人脸图像的姿态角yaw的预测值和标注值,和分别为第k幅人脸图像的姿态角roll的预测值和标注值;

[0030]

单通道眼镜佩戴状态交叉熵损失函数定义如下:

[0031]

当预测的眼镜佩戴概率大于等于50%时,即损失函数定义如下:

[0032][0033]

其中,和分别为第k幅人脸图像的眼镜佩戴的预测概率和标注概率,标注概率只能取0和1;

[0034]

当预测的眼镜佩戴概率低于50%时,即损失函数定义如下:

[0035]

[0036]

引入示性函数将公式(4)和(5)进行合并,示性函数定义如下:

[0037][0038]

因此,最终的单通道眼镜佩戴状态交叉熵损失函数定义为:

[0039][0040]

优选的,所述训练图像的大小为512x512x3,经过第一次残差下采样处理后大小变为256x256x16,经过第二次残差下采样处理后大小变为128x128x32,经过第三次残差下采样处理后变为大小64x64x48的第一特征图;第二特征图的大小为32x32x64,第三特征图的大小为1x1x64,第四特征图的大小为 16x16x64,第五特征图的大小为1x1x64,第六特征图的大小为8x8x96,第七特征图的大小为1x1x96,复制连接后的特征向量为224x1维,输出特征向量的维度为140x1维。

[0041]

从上面所述可以看出,本说明书一个或多个实施例提供的一种用于证件图像的检测识别方法,首先获取需要进行检测识别的训练图像,将所述的训练图像划分为训练样本集和测试样本集;再构建对待检测证件图像进行检测识别的深度神经网络结构;再将获取的训练样本集输入到构建的深度神经网络结构中的数据输入层进行深度神经网络训练,获取检测识别模型;最后将获取的测试样本集输入到检测识别模型中,实现对包含68个人脸特征点、3 个人脸姿态角和1个眼镜佩戴状态的待检测证件图像的检测识别。本发明采用深度神经网络实现了混合估计,速度快,精度高,同时对用户的人脸特征点、人脸姿态角和眼镜佩戴情况进行识别,能够对用户进行提醒,从而在用户拍照时获得符合要求的证件照片。

附图说明

[0042]

为了更清楚地说明本说明书一个或多个实施例或现有技术中的技术方案,下面将对实施例或现有技术描述中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本说明书一个或多个实施例,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据这些附图获得其他的附图。

[0043]

图1为本说明书一个或多个实施例一种用于证件图像的检测识别方法的步骤流程图;

[0044]

图2为本说明书一个或多个实施例一种用于证件图像的检测识别方法中 68个人脸特征点分布示意图;

[0045]

图3为本说明书一个或多个实施例一种用于证件图像的检测识别方法中深度神经网络结构示意图;

[0046]

图4为本说明书一个或多个实施例一种用于证件图像的检测识别方法中多尺度特征图全局池化示意图;

[0047]

图5为本说明书一个或多个实施例一种用于证件图像的检测识别方法中残差下采样结构示意图。

具体实施方式

[0048]

为使本公开的目的、技术方案和优点更加清楚明白,以下结合具体实施例,并参照附图,对本公开进一步详细说明。

[0049]

需要说明的是,除非另外定义,本说明书一个或多个实施例使用的技术术语或者科学术语应当为本公开所属领域内具有一般技能的人士所理解的通常意义。本说明书一个或多个实施例中使用的“第一”、“第二”以及类似的词语并不表示任何顺序、数量或者重要性,而只是用来区分不同的组成部分。“包括”或者“包含”等类似的词语意指出现该词前面的元件或者物件涵盖出现在该词后面列举的元件或者物件及其等同,而不排除其他元件或者物件。“连接”或者“相连”等类似的词语并非限定于物理的或者机械的连接,而是可以包括电性的连接,不管是直接的还是间接的。“上”、“下”、“左”、“右”等仅用于表示相对位置关系,当被描述对象的绝对位置改变后,则该相对位置关系也可能相应地改变。

[0050]

如图1为本说明书一个或多个实施例一种用于证件图像的检测识别方法的步骤流程图;图2为本说明书一个或多个实施例一种用于证件图像的检测识别方法中68个人脸特征点分布示意图;图3为本说明书一个或多个实施例一种用于证件图像的检测识别方法中深度神经网络结构示意图;图4为本说明书一个或多个实施例一种用于证件图像的检测识别方法中多尺度特征图全局池化示意图;图5为本说明书一个或多个实施例一种用于证件图像的检测识别方法中残差下采样结构示意图。

[0051]

人脸特征点检测在人脸比对、变形、美颜等方面具有重要的应用。当前,很多的人脸库常常会提供人脸框位置和68个人脸特征点坐标的标注,如图2 所示。68个人脸点特征在第二代居民身份证证件照、驾驶证证件照、出入境证件照的去背、裁剪等方面,可以提供人脸轮廓到照片边缘、头顶距关键信息,以便裁剪出符合公安部标准的证件照片。

[0052]

在拍摄证件照片时,要求坐姿端正,头部不能左右倾斜,也不能左右旋转、前后俯仰,否则符合公安部标准。这些要求可以通过人脸姿态来进行判断。人脸姿态可以采用相对于水平轴x、垂直轴y、深度轴z的旋转角度进行度量,这三个坐标轴的偏转角度分别称为pitch(上下翻转),yaw(左右旋转), roll(左右倾斜)。

[0053]

此外,在公安部的证件类照片标准中一般不允许佩戴眼镜,因此需要检测眼镜的佩戴状态。

[0054]

因此,需要估计68个人脸特征点的坐标、人脸姿态角和眼镜佩戴状态。 68个人脸特征点的坐标估计和人脸姿态角估计本质上是回归问题,而眼镜佩戴状态可以视为图像的分类问题,可见,该问题属于回归和分类的混合识别问题。为此,本发明提供一种基于端对端深度神经网络的用于证件图像的检测识别方法,用于同时检测待检测证件图像中68个人脸特征点、3个人脸姿态角和1个眼镜佩戴状态。

[0055]

如图1所示,本说明书实施例提供一种用于证件图像的检测识别方法,包括:

[0056]

步骤1、获取需要进行检测识别的训练图像,将所述的训练图像划分为训练样本集和测试样本集;所述的训练图像为包括人脸特征点、人脸姿态角和眼镜佩戴状态的待检测证件图像。

[0057]

步骤2、构建对待检测证件图像进行检测识别的深度神经网络结构。

[0058]

所述的深度神经网络结构包括数据输入层、第一次残差下采样层、第二次残差下采样层、第三次残差下采样层、第四次残差下采样和全局池化层、第五次残差下采样和全局

池化层、第六次残差下采样和全局池化层、全连接层和输出层,将输出层与混合损失函数相连接。

[0059]

步骤3、将步骤1中获取的训练样本集输入到步骤2构建的深度神经网络结构中的数据输入层进行深度神经网络训练,获取检测识别模型。

[0060]

训练时的损失函数采用步骤2中的混合损失函数,将混合损失函数的输出反馈给网络,对网络进行循环迭代训练使得混合损失函数最小。

[0061]

步骤4、将步骤1中获取的测试样本集输入到检测识别模型中,实现对包含68个人脸特征点、3个人脸姿态角和1个眼镜佩戴状态的待检测证件图像的检测识别。

[0062]

本说明书实施例提供的一种用于证件图像的检测识别方法,首先获取需要进行检测识别的训练图像,将所述的训练图像划分为训练样本集和测试样本集;再构建对待检测证件图像进行检测识别的深度神经网络结构;再将获取的训练样本集输入到构建的深度神经网络结构中的数据输入层进行深度神经网络训练,获取检测识别模型;最后将获取的测试样本集输入到检测识别模型中,实现对包含68个人脸特征点、3个人脸姿态角和1个眼镜佩戴状态的待检测证件图像的检测识别。本发明采用深度神经网络实现了混合估计,速度快,精度高,同时对用户的人脸特征点、人脸姿态角和眼镜佩戴情况进行识别,能够对用户进行提醒,从而在用户拍照时获得符合要求的证件照片。

[0063]

本说明书实施例还提供一种用于证件图像的检测识别方法,包括:

[0064]

步骤1、获取需要进行检测识别的训练图像,将所述的训练图像划分为训练样本集和测试样本集;所述的训练图像为包括人脸特征点、人脸姿态角和眼镜佩戴状态的待检测证件图像。

[0065]

步骤2、构建对待检测证件图像进行检测识别的深度神经网络结构。

[0066]

所述的深度神经网络结构包括数据输入层、第一次残差下采样层、第二次残差下采样层、第三次残差下采样层、第四次残差下采样和全局池化层、第五次残差下采样和全局池化层、第六次残差下采样和全局池化层、全连接层和输出层,将输出层与混合损失函数相连接。

[0067]

步骤3、将步骤1中获取的训练样本集输入到步骤2构建的深度神经网络结构中的数据输入层进行深度神经网络训练,获取检测识别模型。

[0068]

其中,所述的步骤3中将步骤1中获取的训练样本集输入到步骤2构建的深度神经网络结构中的数据输入层进行深度神经网络训练,获取检测识别模型,包括:

[0069]

步骤3.1、对输入到深度神经网络的训练样本集依次进行三次残差下采样处理,获取第一特征图;

[0070]

步骤3.2、将经过步骤3.1处理后获取的第一特征图分为2路,第1路继续进行残差下采样处理,获取第二特征图;第2路进行全局池化处理,获取第三特征图;

[0071]

步骤3.3、将经过步骤3.2处理后获取的第二特征图分为2路,第1路继续进行残差下采样处理,获取第四特征图;第2路进行全局池化处理,获取第五特征图;

[0072]

步骤3.4、将经过步骤3.3处理后获取的第四特征图分为2路,第1路继续进行残差下采样处理,获取第六特征图;第2路进行全局池化处理,获取第七特征图;

[0073]

步骤3.5、将三次全局池化处理所获取的第三特征图、第五特征图和第七特征图中的池化特征进行复制连接,以全连接的方式获取多尺度的输出特征向量。

[0074]

其中,所述的残差下采样处理包括利用平均池化、最大池化和卷积3种下采样方式,将3种下采样方式的结果进行相加,获得残差下采样结构。

[0075]

训练时的损失函数采用步骤2中的混合损失函数,将混合损失函数的输出反馈给网络,对网络进行循环迭代训练使得混合损失函数最小。

[0076]

其中,所述的混合损失函数包括:

[0077][0078]

其中,为68个人脸特征点的均方误差损失函数,为3个人脸姿态角的均方误差损失函数,为单通道眼镜佩戴状态交叉熵损失函数,λ1、λ2和λ3分别为和的加权系数;

[0079]

68个人脸特征点的均方误差损失函数定义如下:

[0080][0081]

其中,和为预测得到第k幅人脸图像的第i个人脸特征点坐标,即预测得到第k幅人脸图像的第i个人脸特征点坐标为第k幅人脸图像的第i个人脸特征点坐标为和为人工标注的第k幅人脸图像的第i个人脸特征点坐标,即人工标注的第k幅人脸图像的第i个人脸特征点坐标n为训练样本集中人脸图像总数量;

[0082]

3个人脸姿态角的均方误差损失函数定义如下:

[0083][0084]

其中,和分别为第k幅人脸图像的姿态角pitch的预测值和标注值,和分别为第k幅人脸图像的姿态角yaw的预测值和标注值,和分别为第k幅人脸图像的姿态角roll的预测值和标注值;

[0085]

单通道眼镜佩戴状态交叉熵损失函数定义如下:

[0086]

当预测的眼镜佩戴概率大于等于50%时,即损失函数定义如下:

[0087][0088]

其中,和分别为第k幅人脸图像的眼镜佩戴的预测概率和标注概率,标注概率只能取0和1;

[0089]

当预测的眼镜佩戴概率低于50%时,即损失函数定义如下:

[0090][0091]

引入示性函数将公式(4)和(5)进行合并,示性函数定义如下:

[0092][0093]

因此,最终的单通道眼镜佩戴状态交叉熵损失函数定义为:

[0094][0095]

步骤4、将步骤1中获取的测试样本集输入到检测识别模型中,实现对包含68个人脸特征点、3个人脸姿态角和1个眼镜佩戴状态的待检测证件图像的检测识别。

[0096]

其中,所述训练图像的大小为512x512x3,经过第一次残差下采样处理后大小变为256x256x16,经过第二次残差下采样处理后大小变为128x128x32,经过第三次残差下采样处理后变为大小64x64x48的第一特征图;第二特征图的大小为32x32x64,第三特征图的大小为1x1x64,第四特征图的大小为 16x16x64,第五特征图的大小为1x1x64,第六特征图的大小为8x8x96,第七特征图的大小为1x1x96,复制连接后的特征向量为224x1维,输出特征向量的维度为140x1维。

[0097]

本说明书实施例提供的一种用于证件图像的检测识别方法,首先获取需要进行检测识别的训练图像,将所述的训练图像划分为训练样本集和测试样本集;再构建对待检测证件图像进行检测识别的深度神经网络结构;再将获取的训练样本集输入到构建的深度神经网络结构中的数据输入层进行深度神经网络训练,获取检测识别模型;最后将获取的测试样本集输入到检测识别模型中,实现对包含68个人脸特征点、3个人脸姿态角和1个眼镜佩戴状态的待检测证件图像的检测识别。本发明采用深度神经网络实现了混合估计,速度快,精度高,同时对用户的人脸特征点、人脸姿态角和眼镜佩戴情况进行识别,能够对用户进行提醒,从而在用户拍照时获得符合要求的证件照片。

[0098]

如图3所示,深度神经网络结构的训练样本集输入图像大小为512

×

512

ꢀ×

3,所述的训练样本集输入图像可以包括通过相机获取;经过第1次残差下采样后变为256

×

256

×

16,经过第2次残差下采样后变为128

×

128

×

32,经过第3次残差下采样后变为64

×

64

×

48;从第4残差下采样开始,特征图分成2路,1路继续下采样,另1路进行全局池化,然后复制进行连接;第4残差下采样后,特征图变为32

×

32

×

64,全局池化后的特征图为1

×1×

64;第 5残差下采样后,特征图变为16

×

16

×

64,全局池化后的特征图为1

×1×

64;第6残差下采样后,特征图变为8

×8×

96,全局池化后的特征图为1

×1×

96; 3路池化特征的复制连接后得到(64 64 96)x1=224x1维的特征向量。

[0099]

采用3路不同尺度池化特征主要是为了增强特征的尺度不变性,从而提高估计和预测精度。由于需要估计68个人脸特征点、3个人脸姿态角和1个眼镜佩戴状态,因此全连接后的深度神经网络的输出特征向量维度应该为68

ꢀ×

2 3 1=140。为了降低网络参数和计算复杂度,该深度神经网络采用1个全连接层。

[0100]

本发明所提供的方法能够一次性估计预测多个不同的目标,如68个人脸特征点、3个人脸姿态角和1个眼镜佩戴概率值;同时采用残差下采样、全局池化等方式实现了一种专门的端对端的多目标估计网络。

[0101]

同时,为了获得鲁棒的估计深度神经网络,本发明设计了专门的残差结构、多尺度特征结构和跳层复制连接等特殊结构。如图5所示,本发明专利采用输入后进行平均池化

(avg_pool)、最大池化(max_pool)和卷积(con)这3种下采样方式,卷积下采样后进行批标准化,然后将这3种下采样方式的结果进行叠加,输出残差下采样结构;平均池化得到了特征均值信息,而最大池化得到特征值最大信号,这2种池化方法得到不同的非线性信息,对分类和回归非常有用;但是,池化操作是不可学习的下采样方法;而卷积下采样方式,可以得到学习的参数,从而实现一种可学习的下采样操作,实现比较灵活、数据依赖的下采样;这3种方式组成的残差下采样,极大地增强了特征的鲁棒性和区分鉴别能力。

[0102]

如图4所示,本发明的多尺度特性主要体现在不同尺度特征图上进行全局池化操作,然后将不同尺度下的池化特征进行连接(concatenation),这样就得到了多尺度的输出特征向量;不同尺度池化特征复制和连接,体现了特征的跳层、跨层思想,能够很好地增强特征的鲁棒性。

[0103]

本发明提供的方法极大了增强了网络的预测精度,加快了网络训练速度;同时多尺度池化特征及其跨层连接明显地增强深度神经网络的尺度不变性,能够估计不同大小的人脸特征点、人脸姿态角和眼镜佩戴状态。同时利用均方误差、交叉熵混合损失函数和单通道眼睛佩戴交叉熵损失的结合,统一了混合损失函数,加快训练速度,提高预测精度,能够实现68个特征点、3个姿态角和1个眼镜佩戴概率的端对端估计。本发明采用深度神经网络实现了混合估计,速度快,精度高,同时对用户的人脸特征点、人脸姿态角和眼镜佩戴情况进行识别,能够对用户进行提醒,从而在用户拍照时获得符合要求的证件照片。

[0104]

可以理解,本发明方法可以通过任何具有计算、处理能力的装置、设备、平台、设备集群来执行,且产生与系统相应的有益效果。

[0105]

所属领域的普通技术人员应当理解:以上任何实施例的讨论仅为示例性的,并非旨在暗示本公开的范围(包括权利要求)被限于这些例子;在本公开的思路下,以上实施例或者不同实施例中的技术特征之间也可以进行组合,步骤可以以任意顺序实现,并存在如上所述的本说明书一个或多个实施例的不同方面的许多其它变化,为了简明它们没有在细节中提供。

[0106]

另外,为简化说明和讨论,并且为了不会使本说明书一个或多个实施例难以理解,在所提供的附图中可以示出或可以不示出与集成电路(ic)芯片和其它部件的公知的电源/接地连接。此外,可以以框图的形式示出装置,以便避免使本说明书一个或多个实施例难以理解,并且这也考虑了以下事实,即关于这些框图装置的实施方式的细节是高度取决于将要实施本说明书一个或多个实施例的平台的(即,这些细节应当完全处于本领域技术人员的理解范围内)。在阐述了具体细节(例如,电路)以描述本公开的示例性实施例的情况下,对本领域技术人员来说显而易见的是,可以在没有这些具体细节的情况下或者这些具体细节有变化的情况下实施本说明书一个或多个实施例。因此,这些描述应被认为是说明性的而不是限制性的。

[0107]

尽管已经结合了本公开的具体实施例对本公开进行了描述,但是根据前面的描述,这些实施例的很多替换、修改和变型对本领域普通技术人员来说将是显而易见的。例如,其它存储器架构(例如,动态ram(dram))可以使用所讨论的实施例。

[0108]

本说明书一个或多个实施例旨在涵盖落入所附权利要求的宽泛范围之内的所有这样的替换、修改和变型。因此,凡在本说明书一个或多个实施例的精神和原则之内,所做的任何省略、修改、等同替换、改进等,均应包含在本公开的保护范围之内。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。