1.本发明属于语音信号处理领域,涉及语音增强算法。

背景技术:

2.真实环境中采集到的语音信号通常含有背景噪声。这些噪声的形式是多种多样的,其存在严重降低了语音的听觉感知质量和可懂度。语音增强的目的便是从被各种各样的噪声干扰、甚至淹没的信号中提取有用的语音信号,同时抑制、降低噪声的干扰。

3.现有的单通道语音增强方法可以分为两类,一类是传统方法,例如谱减法、维纳滤波法、基于隐马尔可夫模型的方法、基于非负矩阵的方法等。另一类是基于深度学习的方法。

4.基于深度学习的单通道语音增强方法主要分为时域和频域方法。时域方法通常利用深度神经网络来学习带噪语音和干净语音的一维波形之间的映射关系。由于一维语音信号缺乏明显的几何结构,从其中提取有用的信息较为困难。频域方法对带噪语音信号的二维频谱进行处理,通常有两种方式,一是直接通过深度神经网络重建出干净的语音频谱,二是预测一个时频掩膜以对带噪频谱进行滤波从而生成增强的频谱。虽然以上方法的出现均极大地提高了基于深度学习的单通道语音增强方法的效果,但恢复出的增强语音仍然有部分信息丢失。为了进一步提升语音增强算法的效果,许多借助外部参考的或语音自身固有的先验信息来帮助重建怎强语音的方法被提了出来,例如外部参考的说话人视频中的口部动作先验、表情先验,语音自身固有的或外部干净参考语音含有的说话人身份先验、情绪先验、音素发声特征先验等。其中,由于外部参考语音与目标语音具有相同的说话人(说话内容不同),且其帧级别的音素信息是部分共享的,所以通过引入外部参考语音来辅助进行带噪语音的增强(基于参考的语音增强)能够取得更好的效果。

技术实现要素:

5.为了进一步提升现有语音增强算法的效果,本发明旨在提供一套基于参考的语音增强算法,本发明所涉及到的语音均为单通道语音。技术方案如下

6.一种基于参考的语音增强方法,包括下列步骤:

7.1)分析真实环境中的带噪语音,建立加性噪声模型:

8.x=y n

9.其中,y为干净语音,n为环境噪声,x为带噪语音;

10.2)定义基于参考的语音增强模型:

[0011][0012]

其中g为基于参考的语音增强模型;r为带噪语音x所对应的参考语音,即与带噪语音x具有相同说话人但说话可能内容不同的干净语音;为模型输出的增强语音,即对干净语音y的估计;

[0013]

3)通过短时傅里叶变换将带噪语音x和参考语音r从时域转至频域,得到带噪语音

频谱与参考语音频谱其中t

x

和tr分别是x和r的帧数,f为频域点数;

[0014]

4)mfcc组匹配获取帧间对应关系,方法如下:

[0015]

从分别从带噪语音频谱x和参考语音频谱r提取mfcc,并将连续3帧的mfcc组合在一起构成一个带噪语音频谱x的mfcc组和一个参考语音频谱r的mfcc组;对于带噪语音的某个mfcc组,通过计算所有参考语音的mfcc组与其的余弦相似度,挑选出余弦相似度最高的5个mfcc组的中间帧与带噪语音的所述mfcc组的中间组构成一个帧间对应关系重复此过程便可以对带噪语音的每一帧得到一个帧间对应关系;

[0016]

5)编码器提取深度特征,方法如下

[0017]

编码器由3个级联的卷积层构成,每个卷积层都包含复数卷积、批标准化、leakyrelu激活3个部分,其中复数卷积通过控制步长来对输入进行频域下采样,使用同一个编码器对x和r分别进行处理,得到3 对不同深度的带噪特征和参考特征

[0018]

6)参考语音特征重组,方法如下:

[0019]

对于每一个基于相应的帧间对应关系对进行重组,构成5个与维度相同的重组参考特征

[0020]

7)二段式的特征融合,方法如下:

[0021]

第一阶段,通过softmax函数对与的幅度值的帧间余弦相似度进行归一化生成权重系数随后基于权重系数对5个进行卷积融合,得到

[0022]

第二阶段,使用通道注意力将与进行融合,得到

[0023]

8)深度特征解码,方法如下:

[0024]

解码器由4个残差块和3个级联的转置卷积层构成,每个残差块由复数卷积、relu激活、复数卷积、 relu激活构成,前两个转置卷积层包含复数转置卷积、批标准化、leakyrelu激活3个部分,最后一个转置卷积层只有复数转置卷积操作;解码器中的每一个转置卷积操作都可以通过控制步长来对输入进行频域上采样;解码器首先将送入4个残差块得到随后使用3个转置卷积层对其逐级进行上采样,并在每次进入转置卷积层之前与相应的合并在一起:

[0025][0026]

其中,decodei指第i个转置卷积层;

[0027]

最后使用tanh激活函数对解码器输出的的幅度谱进行处理,得到一个乘性复数掩膜m:

[0028][0029]

9)使用乘性复数掩膜m对带噪语音频谱x进行滤波,获得增强语音频谱

[0030]

10)通过短时傅里叶变换反变换将从频域转换至时域获得最后的增强语音

[0031]

本发明的技术特点及效果:针对基于参考的语音增强,本发明使用基于mfcc组匹配获得的帧间对应关系来进行参考特征重组。重组参考特征和噪声特征通过特征融合模块

融合在一起经过解码器,最终获得增强语音频谱。本发明具有以下特点:

[0032]

1.本发明利用了带噪语音和参考语音之间的局部相关性,进行了基于参考的语音增强。本发明首先使用mfcc组进行匹配,然后根据匹配所得的帧间对应关系重组参考特征。

[0033]

2.由于参考特征与带噪特征具有不同的相似性,并且它们对最终增强语音的贡献不同,本发明使用特征融合模块来将参考和带噪特征自适应融合在一起。

[0034]

3.本发明首个进行了基于参考的单通道语音增强,希望本发明能够启发更多基于参考的语音处理方法的研究。

附图说明

[0035]

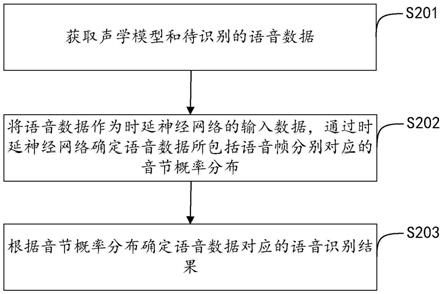

图1是算法流程框图。

[0036]

图2是模型结构图。

[0037]

图3是融合模块结构图。

[0038]

图4是不同时长的参考语音对增强结果的影响对比图。

具体实施方式

[0039]

本发明采用如下技术方案:

[0040]

1)分析真实环境中的带噪语音,建立加性噪声模型:

[0041]

x=y n

[0042]

其中,y为干净语音,n为环境噪声,x为带噪语音。

[0043]

2)定义基于参考的语音增强模型及其输入输出:

[0044][0045]

其中g为基于参考的语音增强模型;r为x所对应的参考语音,即与x具有相同说话人但说话内容不同的干净语音;为模型输出的增强语音,即对干净语音y的估计。

[0046]

3)针对加性噪声模型设计算法流程。

[0047]

本发明提供的基于参考的语音增强算法包含以下8个步骤:

[0048]

第1步:通过短时傅里叶变换将带噪语音x和参考语音r从时域转至频域,得到带噪语音频谱与参考语音频谱其中t

x

和tr分别是x和r的帧数,f为频域点数。

[0049]

第2步:mfcc组匹配获取帧间对应关系。

[0050]

为了获取帧间对应关系,本发明首先从频谱中提取mfcc(mel frequency cepstrum coefficient)并将连续3帧(前一帧、当前帧、后一帧)的mfcc组合在一起构成一个mfcc组。对于带噪语音的某一个 mfcc组,通过计算所有参考语音的mfcc组与其的余弦相似度(cosine similarity),挑选出余弦相似度最高的5个mfcc组的中间帧与带噪mfcc组的中间帧构成一个帧间对应关系重复这个过程便可以对带噪语音的每一帧得到一个帧间对应关系。

[0051]

第3步:编码器提取深度特征。

[0052]

编码器由3个级联的卷积层构成。每个卷积层都包含复数卷积、批标准化、leakyrelu激活3个部分,其中复数卷积通过控制步长来对输入进行频域下采样。使用同一

个编码器对x和r分别进行处理可以得到3 对不同深度的特征和称之为带噪特征和参考特征。编码过程如下:

[0053][0054][0055]

其中,encodei为第i个卷积层。

[0056]

第4步:参考语音特征重组。

[0057]

对于每一个基于相应的帧间对应关系对进行重组,构成5个与与维度相同的重组参考特征

[0058]

第5步:特征融合。

[0059]

为了将与融合在一起,本发明设计了二段式的特征融合模块:

[0060]

·

第一阶段,首先通过softmax函数对与的幅度值的帧间余弦相似度进行归一化生成权重系数

[0061][0062][0063][0064]

其中,和分别是和的第t帧,|

·

|是计算复数的幅度,α

t

是构成的向量。

[0065]

随后基于权重系数对5个进行卷积融合,得到

[0066][0067][0068]

其中,complexconv为复数卷积。

[0069]

·

第二阶段,使用通道注意力(channel attention)将与进行融合,通道注意力具有多种形式,本发明采用如下形式的通道注意力:

[0070][0071][0072][0073][0074][0075]

其中,[

·

]是将与在通道维度上合并起来,globalpooling是全局池化层。

[0076]

第6步:深度特征解码。

[0077]

解码器由4个残差块和3个级联的转置卷积层构成,每个残差块由复数卷积、relu激活、复数卷积、relu激活构成,前两个转置卷积层包含复数转置卷积、批标准化、

leakyrelu激活3个部分,最后一个转置卷积层只有复数转置卷积操作。解码器中的每一个转置卷积操作都可以通过控制步长来对输入进行频域上采样。解码器首先将送入4个残差块得到随后使用3个转置卷积层对其逐级进行上采样,并在每次进入转置卷积层之前与相应的合并在一起:

[0078][0079]

其中,decodei指第i个转置卷积层。

[0080]

最后使用tanh激活函数对解码器输出的的幅度谱进行处理,得到一个乘性复数掩膜m:

[0081][0082]

第7步:使用乘性复数掩膜m对带噪语音频谱x进行滤波,获得增强语音频谱

[0083]

第8步:通过短时傅里叶变换反变换将从频域转换至时域获得最后的增强语音

[0084]

4)数据集获取及其预处理。

[0085]

本发明使用voice bank demand开源数据集对模型进行训练与测试。voice bank demand开源数据集的训练集包含28个说话人的多条内容不同的带噪-干净语音数据对,共计11572对。测试集包含2个说话人的多条内容不同的带噪-干净语音数据对,共计824对。对于每一条带噪语音,从其说话人的其他内容不同的干净语音中随机挑选出15秒构成对应的参考语音。

[0086]

5)训练。

[0087]

本发明中,训练模型所使用的损失函数为l1-loss和感知损失的加权和,优化器使用adam优化器,初始学习率设置为0.0001。本发明利用深度学习框架pytorch平台训练模型,在整个数据集上迭代80次,随后减小学习率至0.00001,迭代20次,使得损失收敛,得到最终模型。

[0088]

6)测试。

[0089]

将测试集中的带噪语音与其相应的参考语音输入到模型中,得到相应的增强语音。

[0090][0091]

表1

[0092]

表1是本发明所提算法与其他语音增强算法在voice bank demand测试集上的结果对比表。表中各个方法的参考文献如下:

[0093]

[1]pascual s,bonafonte a,serra j.segan:speech enhancement generative adversarial network[j].arxiv preprint arxiv:1703.09452,2017.

[0094]

[2]germain f g,chen q,koltun v.speech denoising with deep feature losses[j].arxiv preprint arxiv:1806.10522,2018.

[0095]

[3]fu s w,liao c f,tsao y,et al.metricgan:generative adversarial networks based black-box metric scores optimization for speech enhancement[c]//international conference on machine learning.pmlr,2019: 2031-2041.

[0096]

[4]yin d,luo c,xiong z,et al.phasen:a phase-and-harmonics-aware speech enhancement network[c]//proceedings of the aaai conference on artificial intelligence.2020,34(05):9458-9465.

[0097]

[5]kim j,el-khamy m,lee j.t-gsa:transformer with gaussian-weighted self-attention for speech enhancement[c]//icassp 2020-2020ieee international conference on acoustics,speech and signal processing (icassp).ieee,2020:6649-6653.

[0098]

[6]defossez a,synnaeve g,adi y.real time speech enhancement in the waveform domain[j].arxiv preprint arxiv:2006.12847,2020.

[0099]

[7]fu s w,yu c,hsieh t a,et al.metricgan :an improved version of metricgan for speech enhancement[j].arxiv preprint arxiv:2104.03538,2021.

[0100]

[8]hsieh t a,yu c,fu s w,et al.improving perceptual quality by phone-fortified perceptual loss using wasserstein distance for speech enhancement[j].arxiv preprint arxiv:2010.15174,2020.

[0101]

凡在本发明的精神和原则之内,所作的任何修改、等同替换、改进等,均应包含在本发明的保护范围之内。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。