1.本发明属于计算机视觉领域中的场景理解(scene understanding)领域,具体实现结果为场景图的生成(sgg),特别涉及一种基于三维场景点云的场景图生成方法。

背景技术:

2.三维中的场景理解任务是从三维数据中感知、理解并解释场景中内容的过程,重点关注于几何和语义信息两部分,包括识别和定位场景中所有物体,以及物体的上下文信息和物体间的关系。场景图可以将场景理解过程中认知到的无组织、无结构的信息,以图的形式组织起来,其中场景中的物体为图的节点,物体间的关系为图上的边。目前场景图生成方法在二维图像领域得到了充分的探索和发展,但是在三维数据上的实现效果仍存在很多的不足。

3.由于三维点云相对于二维图像而言,数据的质量和完整性存在很大的不同,直接将二维场景图生成方法迁移到三维上存在着很大的问题。现有的三维场景图生成方法直接借鉴了二维方法中常用的视觉模式和上下文信息融合方式,导致了方法所抽取的特征中具有大量的噪音,并且在后续的上下文信息融合的过程中逐渐失去了辨别性。这大大降低了机器人在三维场景中的理解能力,并且会限制后续高级任务的实现效果,例如,机器人导航、任务规划和场景修改任务等。

4.传统的二维和三维sgg方法可以大体上分为两类,具有先验知识的环境理解过程,以及基于环境上下文信息组织场景知识的过程。第一类sgg方法因为缺乏探索环境的能力,因而具有较差的容错能力。第二类sgg方法大多利用消息传递机制(mp)来探索场景知识,传统sgg方法设计的mp会对上下文信息和噪声不加区分的进行传播,导致了特征混淆,大大降低了方法对于物体和物体间关系的识别准确率。由于三维数据相对于二维图像具有更大的噪音,因而无法直接将二维方法迁移到三维数据上。

5.sgg方法在实现过程中首先需要定义物体和关系的视觉模式。传统方法中会将物体候选框内的像素或点云数据作为物体的视觉模式,而关系的视觉模式却存在着多种多样的空间定义,例如,联合框(两个物体框的并集)、交集框和向量空间(两个物体框中心点构成的有向向量空间)。但是这三者都不适用于三维场景点云的数据形式,联合框由于反复对物体空间进行建模,构成了大量的信息冗余,而交集框和向量空间由于涵盖了过少的数据点,造成了环境信息不足。并且由于三维数据具有很多的噪音,因而,三维sgg方法直接使用二维sgg方法所定义的视觉模式会造成过高或过低的信息冗余,导致无法从环境中充分地抽取有效信息。

6.利用定义的视觉模式进行初始特征的抽取,使用环境上下文融合的方法为特征增加辨别力。将较为相似的初始特征,通过融入不同区域的环境上下文信息,从而变得具有可辨别性,实现对于物体和关系的精准预测。传统的sgg方法大多利用消息传递机制(mp)来实现这一过程,传统方法中mp机制往往是构建在全连接图上,对所有初始特征进行无差别的相互传递。这种传递方式造成了特征中所包含的噪音信息被重复叠加,造成了特征混淆,降

低了实体识别的准确率。

7.因此本发明基于对现有的场景图生成方法的调查与分析,通过设计新的适用于三维点云数据的视觉模式,即交互空间,抽取具有适度冗余度的初始特征,在保障具有充足的环境信息的同时,降低由于反复建模所造成的噪音叠加问题。同时本发明参考人的环境理解过程,设计了具有结构化组织和层次化处理过程的环境上下文融合过程,通过将无差别的信息传递过程改变为有结构的信息组织过程,实现了具有更高辨别力的特征的构建,实现了更精确的三维场景图生成任务。

技术实现要素:

8.本发明针对具有实例分割标签的三维场景点云数据,利用不包含节点标签的场景图骨架,不同细粒度的物体节点标签以及关系标签三部分作为监督数据实现三维场景图生成方法。该方法包括图特征提取阶段和环境上下文融合阶段,其中图特征提取阶段包含交互空间计算和位置特征计算两部分;环境上下文融合阶段包括图骨架学习、消息传递机制(mp)和层次化物体学习三部分。本发明所述方法适用于多种类型和大小的三维室内场景的场景理解过程。

9.本发明的技术方案为:

10.一种基于三维场景点云的场景图生成方法,利用环境上下文实现对物体和关系标签的精确识别,该方法包括以下步骤:

11.步骤1、三维场景点云数据预处理

12.通过将场景分割为若干个小型场景,使每个小型场景中包含4-9个实体,进而将一张全场景的场景图划分为小型图;将场景中的每一个物体所包含的点云根据实例分割标签划分出来,通过计算点云的最小值和最大值得出该物体的物体框;

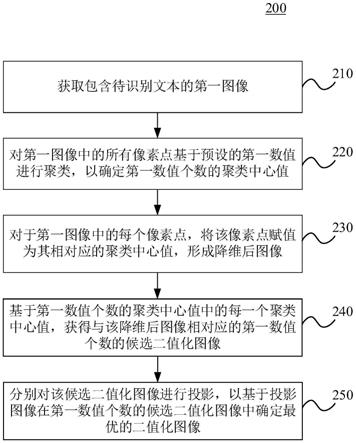

13.步骤2、图特征提取模块

14.首先需要根据两物体的物体框判断两物体之间是相交还是相离;若两物体相交,则相交区域为交互空间;若两物体相离,则选择两物体框的中心点分别作为交互空间的左下角和右上角点,交互空间的长宽高为两点坐标的差值;物体框内的场景点云为物体的视觉模式,交互空间内的场景点云即为关系的视觉模式;将物体和关系的场景点云输入到pointnet特征抽取模型中,获取物体和关系初始特征;对物体的位置特征进行计算,根据任意两物体的物体框计算并集空间,根据主语物体框和宾语物体框各自的最小值点和最大值点分别与并集空间的最小值和最大值相减,得到物体的位置特征;将位置特征与关系初始特征融合,实现对关系初始特征的位置信息补充;

15.步骤3、图骨架学习模块

16.图骨架学习模块由三层全连接层构成,将步骤2求得的关系初始特征作为输入,利用不包含节点和关系标签的骨架作为监督数据,对任意两节点间的关联度进行二分类预测;图骨架学习模块为每两个节点的连接状态预测一个概率值,经过softmax进行归一化处理,生成后续消息传递机制的组织权重;

17.步骤4、环境上下文融合模块

18.环境上下文融合模块主要利用消息传递机制mp来实现,mp的输入包含步骤3中图骨架学习模块计算的组织权重、步骤2中物体和关系的初始特征;mp主要是利用bgnn多阶段

双子图神经网络实现的,bgnn包含两个部分,实体到关系的消息传递以及关系到实体的消息传递;通过将图骨架学习模块学习到的组织权重与两部分的消息相乘,实现了消息传递过程与结构信息的结合,进而利用权重实现了有差别的信息传递;通过多次循环实现在物体和关系初始特征中融合环境上下文信息的过程,输出物体和关系的精细特征;

19.步骤5、层次化物体学习模块

20.层次化物体学习模块利用粗细两种粒度的物体标签,对步骤2中物体的初始特征和步骤4中mp融合后的精细物体特征进行监督学习;经过粗粒度标签约束的物体初始特征在融合环境上下文信息后,利用细粒度标签进行二次约束;层次化物体学习模块由两个三层全连接层构成,根据输入的物体的初始特征和精细特征直接输出物体标签;

21.步骤6、场景图结果生成

22.利用步骤4中mp融合后的关系精细特征用于预测关系标签;关系预测器由三层全连接层组成,接受融合后的关系特征,输出关系标签;步骤5输出的实体标签和关系标签在图骨架上构成了最后的场景图;当关系标签预测为

‘

无’关系时,表示两物体间不存在关系,即删除两点间的连接;最终输入的三维点云场景被表示为多张不同大小的场景图。

23.步骤7、验证场景图生成方法的有效性

24.为了验证本发明的有效性,同时对比了二维和三维sgg方法。将二维sgg方法msdn、kern和bgnn从二维图像数据集迁移到三维数据集3rscan上,其中kern使用训练集的物体和关系之间的共现概率作为先验知识。三维sgg方法包含3dssg和sggpoint两种方法。为了进行公平的比较,所有的方法均使用其公开的代码或带有原始建议参数的设置,并且均使用pointnet特征抽取模型用于提取初始特征,在3rscan的训练集中进行训练、在测试集上进行测试。

25.本发明的有益效果:

26.(1)场景图生成精确度

27.本发明解决了三维场景图生成任务中,由于不恰当的视觉特征和无差别的环境上下文融合过程造成的信息高冗余度和特征混淆,所造成的物体和关系预测困难的问题。通过定义新的视觉特征,交互空间,在信息抽取阶段提取具有合适冗余度的初始特征,并且通过融入结构化的骨架信息和层次化物体粒度信息构建具有高辨别力的特征。场景图生成任务的精确度由三个子任务验证,包含物体预测任务、谓词预测任务和关系预测任务三部分。本发明提出的三维场景图生成方法在三个子任务上,都优于其他的二维和三维sgg方法。

28.(2)具有多粒度标签的场景图

29.本发明根据pointnet提供的初始特征和mp融合后的精细特征,会预测出两种不同粒度的物体标签。不同的物体标签粒度代表着对于场景不同的理解程度,生成的多张场景图允许下游任务根据任务需求自行调整所需的物体粒度。

附图说明

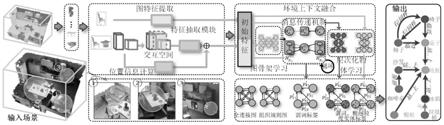

30.图1为本发明中定义的视觉模式交互空间,(i)为包含情况,(ii)为相交情况,(iii)为x方向相离情况,(iv)为y方向相离情况,(v)为z方向分离情况、(vi)为xy方向分离情况、(vii)为yz方向分离情况、(viii)为xz方向分离情况,(ix)为xyz方向分离情况。

31.图2为本发明的网络结构。

32.图3为本发明中的监督数据。

具体实施方式

33.下面结合附图和技术方案,进一步说明本发明的具体实施方式。

34.本发明在3rscan数据集上进行训练,具有1482个场景图,其中选取了场景中频繁出现的160个物体类别和26个谓词标签作为学习对象。通过将160个物体类映射到nyu40,获得了40个粗粒度的对象类别。

35.本发明在pytorch框架上实现三维场景图生成方法的构建。为了进行训练,将输入场景和地面真值场景图都进行了切割处理,并对场景点云根据场景中心点进行了居中操作。pointnet特征抽取模型和后续的所有网络参数进行随机初始化。

36.物体和关系由两个不同的pointnet进行特征抽取,物体和关系点云都会随机采样256个点云数据,pointnet得到的初始特征维度为256。所有物体预测器和关系预测器都由三层全连接层组成,每两层间有批量归一化和relu激活操作。mp模块中bgnn会循环3次,循环后得到的融合后特征,会输入到对应的预测器中进行最后的标签预测。

37.训练过程配备了1

×

10-4

的学习率的自适应矩估计优化器(adam)用于优化整个网络。由于场景切割后,各场景中物体和关系的数量不定,因此批处理大小设置为1。网络在nvidia gtx 1080ti显卡上收敛大约需要14个小时。

38.图1为本发明所提出的视觉模式交互空间,分为相交情况和相离情况。其中,相交情况包含两种情况,完全包含和相交;相离情况包含七种情况,x方向分离、y方向分离、z方向分离、xy方向分离、yz方向分离、xz方向分离和xyz方向分离。

39.图2是三维场景图生成方法的网络结构。首先将场景点云根据实例标签分割为不同的物体点云,计算各物体的物体框。所有的物体点云和物体框输入到图特征提取模块,进行交互空间计算并抽取空间内的点云作为关系的视觉模式。物体和关系点云被送入到两个不同的pointnet中进行特征抽取,关系的特征和位置特征计算模块计算的位置信息合并为关系的初始特征,进而实现了图特征的提取。抽取后的特征送入环境上下文融合阶段,利用图骨架学习模块为mp阶段提供信息组织规则,利用层次化物体学习模块约束初始特征和融合后特征,实现物体标签从粗到细的渐进化预测过程。最终得到的实体和关系特征通过预测器生成最终的场景图。

40.图3是本发明中的监督数据的生成过程。传统sgg方法中将场景图转换为主语实体-谓词-宾语实体,这种三元组形式在本发明中仍被使用为监督信息,用于监督mp阶段融合后预测出的结果。除此之外,图骨架学习模块和层次化物体学习模块都额外需要监督信号,图骨架学习模块使用不包含实体和谓词标签的图骨架作为监督信息;层次化物体学习模型使用3rscan自带的nyu40粗粒度标签作为监督信息。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。