1.本发明属于识别技术领域,具体涉及一种基于表征批归一化的自然场景文本识别方法。

背景技术:

2.场景文本识别在智慧城市建设中有着广泛应用,同时吸引了广大研究者的兴趣。尽管已经提出了许多基于深度学习的识别方法,但是大部分基于深度学习的自然场景文字检测识别的方法虽然在定位准确度,识别精确度方面远远超过基于特征提取的等等传统方法,但是在定位准确度和识别精确度方面还是有很大的改进空间。近年来,已经有多个研究团队提出通过使用文本校正模型来把原始文本图像矫正为具有规则文本的图像。但是经过校正的图像容易引入新的噪声,会干扰文本识别的准确性。除此之外,还有研究团队提出在识别模型中引入了一个可插拔的超分辨率模块来处理低分辨率的图像,但加入一个超分辨率模块会导致模型训练的时间过长。

技术实现要素:

3.发明目的:针对以上问题,本发明提出一种基于表征批归一化的自然场景文本识别方法。

4.技术方案:为实现本发明的目的,本发明所采用的技术方案是:一种基于表征批归一化的自然场景文本识别方法,所述方法具体包括如下步骤:

5.步骤1,利用空间转换网络将待识别的自然场景文本图像规则化为水平文本图像;

6.步骤2,对现有网络resnet-50中引入表征归一化,构建得到特征提取网络;利用所述特征提取网络对所述水平文本图像进行提取,得到若干个不同分辨率大小的视觉特征图;所述若干个不同分辨率大小的视觉特征图组成特征金字塔fr;

7.步骤3,通过特征增强网络对所述特征金字塔fr进行上尺度增强和下尺度增强,并与步骤2所述特征金字塔fr的元素进行连接,获得最终的特征金字塔fe,对特征金字塔fe中各特征图进行上采样,得到相同尺寸大小的特征图ff;

8.步骤4,利用视觉-语义联合网络提取步骤3所述特征图ff的语义信息,把提取出的语义信息和特征图相融合,得到一个新的特征空间;

9.步骤5,利用解码器对步骤4所述特征空间进行预测,得到最终识别结果。

10.进一步地,步骤1所述空间转换网络包括定位网络、网格生成器和采样器;所述步骤1的方法,具体如下:

11.步骤1.1,将待识别的自然场景文本图像调整大小至100像素

×

32像素;

12.步骤1.2,通过定位网络在调整大小后的待识别的自然场景文本图像上预测一组控制点;

13.步骤1.3,所述网格生成器利用所述控制点计算薄板样条变化参数,并在调整大小后的待识别的自然场景文本图像上生成采样网格;

14.步骤1.4,将所述采样网格和所述调整大小后的待识别的自然场景文本图像同时输入至所述采样器,通过在所述采样网格上进行采样,得到规则化后的水平文本图像。

15.进一步地,所述步骤2的方法,具体如下:

16.步骤2.1,在现有网络resnet-50的每一层卷积层后均添加表征归一化,得到所述特征提取网络;

17.步骤2.2,将所述水平文本图像作为所述特征提取网络的输入,分别输出四种不同分辨率大小的视觉特征图,所述视觉特征图的分辨率分别为输入的水平文本图像分辨率的1/4、1/8、1/16和1/32;

18.步骤2.3,利用1

×

1的卷积层将步骤2.2所述视觉特征图的通道数均变成128后,构成特征金字塔fr。

19.进一步地,步骤2所述表征归一化,具体表示如下:

20.给定特征图x∈ra×b×h×w,其中,a、b、h和w分别表示批量大小、通道数、特征图的高度值和宽度值;

21.首先,对特征图x执行校准操作,得到校准后的特征图x

cm

,表示如下:

22.x

cm

=x ωm.km23.式中,ωm表示权重值,km表示特征图x的统计数据;

24.然后,对特征图x

cm

执行中心化操作,得到中心化后的特征图xm,表示如下:

25.xm=x

cm-e(x

cm

)

26.式中,e(x

cm

)表示特征图x

cm

的均值,表示如下:

27.e(x

cm

)

←

me(x

cm

) (1-m)μc28.式中,m表示累计相加量,

←

表示函数映射,μc代表训练时每个批量的均值,表示如下;

[0029][0030]

式中,h表示特征图x的高度值,w表示特征图x的宽度值;

[0031]

接着,对特征图xm执行缩放操作,得到缩放后的特征图xs,表示如下:

[0032][0033]

式中,∈用于避免零方差,var()表示方差函数,表达式如下;

[0034][0035]

式中,表示训练时每个批量的方差,表示如下:

[0036][0037]

其次,对特征图xs进行缩放校正特征强度,得到校正后的特征图x

cs

,表示如下:

[0038]

x

cs

=xs·

r(ωv·ks

ωb)

[0039]

式中,ωv和ωb表示可训练参数,ks表示特征图xs的统计数据;r()表示校正函数;

[0040]

最后,将校正后的特征图x

cs

进行仿射变换,得到放射变换后的特征y,表达式如下:

[0041]

y=x

cs

γ β

[0042]

式中,γ为缩放参数,β为平移参数。

[0043]

进一步地,所述步骤3的方法,具体如下:

[0044]

步骤3.1,将步骤2所述特征金字塔fr输入至级联上尺度卷积,依次以32、16、8和4的步长进行上尺度增强,输出上尺度增强后的特征金字塔;

[0045]

步骤3.2,将步骤3.1所述上尺度增强后的特征金字塔通过级联下尺度卷积,依次以4、8、16和32的步长进行下尺度增强,输出下尺度增强后的特征金字塔;

[0046]

步骤3.3,将所述下尺度增强后的特征金字塔与步骤2所述特征金字塔fr的元素进行连接,获得最终的特征金字塔fe;

[0047]

步骤3.4,将步骤3.3所述特征金字塔fe中全部特征图进行上采样至原图的1/4,得到特征图ff,所述特征图ff的大小为h/4

×

w/4

×

512;其中,h为特征图的高度值,w为特征图的宽度值。

[0048]

进一步地,所述视觉-语义联合网络是由两层bilstm网络构成的;所述步骤4的方法,具体如下:

[0049]

首先,利用视觉-语义联合网络将步骤3所述特征图ff提取为上下文特征序列v;

[0050]

其次,将特征图ff和上下文特征序列v相融合,组成一个新的特征空间c=(ff,v)。

[0051]

进一步地,所述步骤5的方法,具体如下:

[0052]

解码器t时刻预测的输出y

t

,表示如下:

[0053]yt

=softmax(wys

t

by)

[0054]

式中,softmax是激活函数,wy和by是可训练参数,s

t

是lstm在t时刻的隐藏状态,其表达式如下:

[0055]st

=lstm(y

t-1

,g

t

,s

t-1

)

[0056]

其中,y

t-1

是解码器t-1时刻预测的输出,s

t-1

是lstm在t-1时刻的隐藏状态,g

t

是glimpse向量,是由特征空间c=(c1,c2,

…

,cj,

…

,cn)的每列元素的加权和组成的,即

[0057][0058]

其中,cj表示特征空间c的第j列元素值,n表示特征空间c的总列数,α

t,j

是注意力权重,表示如下:

[0059][0060]

其中,e

t,j

=v

t tanh(fs

t-1

gcj b),v、f、g和b均为可训练参数,上标t为转置,tanh()为双曲正切函数。

[0061]

有益效果:与现有技术相比,本发明技术方案具有以下有益技术效果:

[0062]

本发明所述一种基于表征批归一化的自然场景文本识别方法,通过特征表示和特征增强两个方面来改善识别器的性能;在特征表示方面,利用表征归一化来减少模型对训练数据的依赖性,解决不同实例间特征表示的差异性;同时为了进一步提高特征质量,利用

特征增强模块结合多种分辨率的特征图,来包含细化的特征信息。本发明所述方法可以提高场景文本识别的准确率,并且提升了模型的泛化力。

附图说明

[0063]

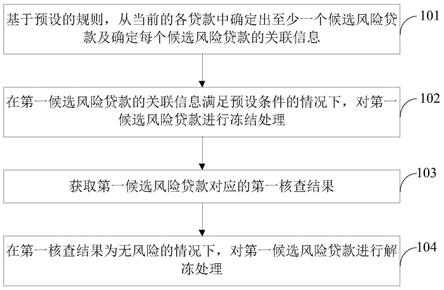

图1是一种实施例下一种基于表征批归一化的自然场景文本识别方法的流程示意图;

[0064]

图2是一种实施例下所述特征提取网络的卷积块模型示意图;

[0065]

图3是一种实施例下所述特征增强网络的结构示意图。

具体实施方式

[0066]

下面结合附图和实施例对本发明的技术方案作进一步的说明。以下通过特定的具体实例说明本发明的实施方式,本领域技术人员可由本说明书所揭露的内容轻易地了解本发明的其他优点与功效。本发明还可以通过另外不同的具体实施方式加以实施或应用,本说明书中的各项细节也可以基于不同观点与应用,在没有背离本发明的精神下进行各种修饰或改变。需要说明的是,以下实施例中所提供的图示仅以示意方式说明本发明的基本构想,在不冲突的情况下,以下实施例及实施例中的特征可以相互组合。

[0067]

其中,附图仅用于示例性说明,表示的仅是示意图,而非实物图,不能理解为对本发明的限制;为了更好地说明本发明的实施例,附图某些部件会有省略、放大或缩小,并不代表实际产品的尺寸;对本领域技术人员来说,附图中某些公知结构及其说明可能省略是可以理解的。

[0068]

本发明所述的一种基于表征批归一化的自然场景文本识别方法,所述自然场景文本识别网络结构包括:空间转换网络、特征提取网络、特征增强网络、视觉-语义联合序列建模、解码器;参考图1,具体包括如下步骤:

[0069]

(1)使用空间转换网络校正文本区域形状,把不规则的自然场景文本图像规则化为水平文本图像;

[0070]

(2)在骨干网络resnet-50中引入表征归一化构建具有泛化能力的特征提取网络,能够在不同的数据集中提取出稳定的特征分布;使用特征提取网络提取出不同分辨率大小的视觉特征图,组成特征金字塔;

[0071]

(3)特征增强模块利用特征图提取更深层次、更具表现力的特征图,并且把不同尺寸的特征图融合成同尺寸大小(h/4

×

w/4

×

512)的特征图;

[0072]

(4)视觉-语义联合建模提取图像的语义信息,把提取出的语义信息和视觉特征相融合,得到一个新的特征融合体;

[0073]

(5)解码器通过对特征融合体进行预测得到最终的识别结果。

[0074]

进一步地,步骤(1)的具体过程如下:

[0075]

(11)空间转换网络输入图像x的大小为100

×

32。首先,通过定位网络在图像x上预测一组控制点;

[0076]

(12)然后,在网格生成器中利用控制点计算薄板样条(thin-plate-spline,tps)变化参数,并在图像x生成采样网格p;

[0077]

(13)采样器同时输入采样网格p和图像x,通过在网格上采样得到校正图像x’。

[0078]

进一步地,步骤(2)的具体过程如下:

[0079]

(21)在resnet50的网络结构的卷积层之后引入表征批归一化组成我们所使用的特征提取器;

[0080]

(22)经空间转换网络出的规则文本图像作为特征提取器的输入,特征提取网络的conv_2、conv_3、conv_4和conv_5四个阶段分别输出四种不同分辨大小的特征图,其特征图的分辨率分别为输入图像的1/4、1/8、1/16和1/32;所述征提取网络的卷积块参考图2;

[0081]

(23)使用1

×

1的卷积层把每个特征图的通道数变成128,得到一个包含所有特征图的特征金字塔fr。

[0082]

进一步地,所述特征增强网络的结构参考图3,步骤(3)的具体过程如下:

[0083]

(31)将特征金字塔fr输入级联上尺度卷积,连续以32、16、8和4的步长进行上尺度增强;

[0084]

(32)再经过级联下尺度卷积阶段连续以4、8、16和32的步长进行下尺度增强,其输出的特征金字塔和级联上尺度卷积的输入特征金字塔元素相连接,获得最终的特征金字塔fe。

[0085]

(33)将特征金字塔fe的所有特征图上采样到原图的1/4,得到最后的视觉特征图ff,其大小为h/4

×

w/4

×

512。

[0086]

进一步地,步骤(4)的具体过程如下:

[0087]

视觉特征图ff经由两层bilstm被提取为上下文特征序列v;

[0088]

视觉特征图ff和上下文特征序列v连接起来组成一个新的特征空间c=(ff,v)。

[0089]

进一步地,步骤(5)的具体过程如下:

[0090]

在t时刻,解码器预测的输出结果为yt:

[0091]yt

=softmax(wys

t

by)

[0092]

其中,softmax是激活函数,wy和by是可训练参数,s

t

是lstm在t时刻的隐藏状态,其表达式如下:

[0093]st

=lstm(y

t-1

,g

t

,s

t-1

)

[0094]

其中,g

t

是glimpse向量,是由特征空间c=(c1,c2,

…

,cn)每列的加权和组成,即

[0095][0096]

其中,α

t,j

是注意力权重,计算如下:

[0097][0098]

其中,e

t,j

=v

t tanh(fs

t-1

gcj b),v、f、g和b均为可训练参数,上标t为转置,tanh()为双曲正切函数。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。