1.本发明涉及信息处理装置和计算机可读介质。

背景技术:

2.提出了在给出了问题和相关文本时从相关文本中提取适当的回答的技术。

3.在日本特开2019-16025号公报中公开了由装置自动地生成用于机器学习的示教数据的信息处理系统。存储部存储所预先设定的验证规则,该验证规则表示将学习模型部的相对于输入值的输出值判定为真的条件。训练部向学习模型部输入多个输入值,取得学习模型部的相对于多个输入值的多个输出值,参考验证规则针对多个输入值来判定多个输出值是否分别为真,将在多个输出值中判定为真的输出值与对应的输入值的对作为用于有示教学习的新训练数据存储到存储部中。

4.在日本特开2019-215841号公报中公开了实现针对问题的高回答精度的问题生成装置。问题生成装置具有生成单元,该生成单元输入疑问句和包含针对该疑问句的回答的相关文档,使用预先学习完毕的机器学习模型来生成用预定的词汇集合所包含的单词修改疑问句的潜在缺失的部分而得到的修改疑问句。生成单元具有:对照单元,其生成表示疑问句所包含的各单词与相关文档所包含的各单词的一致关系的匹配信息;以及问题复原单元,其使用由对照单元生成的匹配信息来从词汇集合中生成构成修改疑问句的各单词,由此生成所述修改疑问句。

5.在日本特开2019-191827号公报中公开了实现精度较高的问题应答的问题应答装置。问题应答装置具有回答生成单元,该回答生成单元将文档和问题作为输入,使用预定的第1词汇与由文档和问题所包含的单词构成的第2词汇的并集所包含的单词,通过学习完毕模型执行生成针对问题的回答句的处理。学习完毕模型包含关于回答句所包含的单词是否包含在第2词汇中进行预先学习而得到的学习完毕神经网络,使通过学习完毕神经网络在生成回答句时选择第2词汇所包含的单词作为回答句所包含的单词的概率增减。

6.在使用机器阅读理解模型从分析对象数据中提取针对如需要多个回答的问题的回答时,需要预先准备由疑问句和多个回答的组构成的数据集而学习多回答模型,以从分析对象数据中提取多个回答。但是,多个回答的数据集比单一回答的数据集复杂,因此,无法比单一回答的数据集更容易地准备多个回答的数据集。

技术实现要素:

7.本发明的目的在于使用由疑问句和单一回答的组构成的单一回答数据集来生成由疑问句和多个回答的组构成的数据集。

8.根据本发明的第1方案,提供一种信息处理装置,其中,所述信息处理装置具有处理器,所述处理器执行以下处理:通过向生成与回答对应的疑问句的问题生成器输入任意的文章和从该文章中提取出的多个回答候选,来使该问题生成器生成与所述文章和所述多个回答候选对应的疑问句,并使该问题生成器输出包含所述多个回答候选和所述疑问句的

组的生成数据。

9.根据本发明的第2方案,所述处理器将所述生成数据作为多回答阅读理解模型的示教数据,该多回答阅读理解模型从问题和分析对象数据中提取多个回答并输出所提取的所述多个回答。

10.根据本发明的第3方案,所述处理器执行将所述生成数据作为所述示教数据来学习所述多回答阅读理解模型的处理。

11.根据本发明的第4方案,所述处理器还执行将单一回答数据集作为示教数据来学习所述多回答阅读理解模型的处理。

12.根据本发明的第5方案,所述处理器执行判断所述生成数据的妥当性并仅输出判断为妥当的所述生成数据的处理。

13.根据本发明的第6方案,所述处理器使用验证所述生成数据的验证模型来判断所述生成数据的妥当性。

14.根据本发明的第7方案,所述处理器使用从单一回答数据集中提取出的妥当的问题回答数据和根据所述单一回答数据集生成的不妥当的问题回答数据,来学习所述验证模型。

15.根据本发明的第8方案,所述处理器通过所述验证模型对所述生成数据的多个所述回答候选分别判断妥当性。

16.根据本发明的第9方案,所述处理器使所述问题生成器使用事先准备的单一回答数据集来学习。

17.根据本发明的第10方案,提供一种信息处理装置,其中,该信息处理装置具有处理器,所述处理器执行以下处理:通过向生成与回答对应的疑问句的问题生成器输入任意的文章和从该文章中提取出的至少1个回答候选,来使所述问题生成器生成与所述文章和所述回答候选对应的疑问句,并使所述问题生成器输出包含所述文章和所述疑问句的组的生成数据;以及向从文章中提取与疑问句对应的多个回答并输出所提取的所述回答的机器阅读理解模型输入所述生成数据,使该机器阅读理解模型生成针对所输入的所述生成数据中的所述疑问句的多个回答,使该机器阅读理解模型将所述多个回答添加到所述生成数据中并输出。

18.根据本发明的第11方案,所述处理器执行以下处理:在所述机器阅读理解模型所输出的所述多个回答包含不同的回答的情况下,将所述机器阅读理解模型所输出的所述生成数据作为多回答阅读理解模型的示教数据,该多回答阅读理解模型从问题和分析对象数据中提取多个回答并输出所提取的所述多个回答。

19.根据本发明的第12方案,所述处理器执行将所述机器阅读理解模型所输出的所述生成数据作为示教数据来学习所述多回答阅读理解模型的处理。

20.根据本发明的第13方案,所述处理器还执行将事先准备的单一回答数据集作为示教数据来学习所述多回答阅读理解模型的处理。

21.根据本发明的第14方案,所述处理器将学习出的所述多回答阅读理解模型置换为所述机器阅读理解模型,将来自所述问题生成器的输出输入到所述机器阅读理解模型中。

22.根据本发明的第15方案,所述处理器执行以下处理:判断所述生成数据的妥当性,并仅将判断为妥当的所述生成数据作为所述多回答阅读理解模型的示教数据。

23.根据本发明的第16方案,所述处理器使用验证所述生成数据的验证模型来判断所述生成数据的妥当性。

24.根据本发明的第17方案,所述处理器使用从单一回答数据集中提取出的妥当的问题回答数据和根据所述单一回答数据集生成的不妥当的问题回答数据,来学习所述验证模型。

25.根据本发明的第18方案,所述处理器通过所述验证模型对所述生成数据的多个所述回答候选分别判断妥当性。

26.根据本发明的第19方案,所述机器阅读理解模型使用事先准备的多个单一回答模型从所输入的所述疑问句中提取回答。

27.根据本发明的第20方案,所述机器阅读理解模型使用事先准备的1个单一回答模型从所输入的所述疑问句中提取上层n个回答,其中,n为1以上的整数。

28.根据本发明的第21方案,所述处理器使所述问题生成器使用事先准备的单一回答数据集来学习。

29.根据本发明的第22方案,提供一种计算机可读介质,其存储有使计算机执行处理的程序,其中,在所述处理中,通过向生成与回答对应的疑问句的问题生成器输入任意的文章和从该文章中提取出的多个回答候选,来使该问题生成器生成与所述文章和所述多个回答候选对应的疑问句,并使该问题生成器输出包含所述多个回答候选和所述疑问句的组的生成数据。

30.根据本发明的第23方案,提供一种计算机可读介质,其存储有使计算机执行处理的程序,其中,在所述处理中,通过向生成与回答对应的疑问句的问题生成器输入任意的文章和从该文章中提取出的至少1个回答候选,来使所述问题生成器生成与所述文章和所述回答候选对应的疑问句,并使所述问题生成器输出包含所述文章和所述疑问句的组的生成数据;以及向从文章中提取与疑问句对应的多个回答并输出所提取的所述回答的机器阅读理解模型输入所述生成数据,输出包含针对所输入的所述生成数据中的所述疑问句的多个回答和所述疑问句的组的数据。

31.(效果)

32.根据所述第1方案,能够使用包含疑问句和单一回答的组的单一回答数据集来生成由疑问句和多个回答的组构成的多回答数据集。

33.根据所述第2方案,能够将使用单一回答数据集而生成的多回答数据集作为多回答阅读理解模型的示教数据,该单一回答数据集包含疑问句和单一回答的组。

34.根据所述第3方案,能够通过使用单一回答数据集而生成的多回答数据集来学习多回答阅读理解模型。

35.根据所述第4方案,除了使用单一回答数据集而生成的多回答数据集以外,还能够通过单一回答数据集来学习多回答阅读理解模型。

36.根据所述第5方案,与不判断生成数据的妥当性的情况相比,能够提高多个回答的数据集的精度。

37.根据所述第6方案,与不学习判断生成数据的妥当性的模型的情况相比,能够提高妥当性的判断精度。

38.根据所述第7方案,与不判断生成数据的妥当性的情况相比,能够提高多回答阅读

理解模型的学习精度。

39.根据所述第8方案,与不判断生成数据的妥当性的情况相比,能够提高多个回答的数据集的精度。

40.根据所述第9方案,与不使问题生成器使用单一回答数据集来学习的情况相比,能够提高由问题生成器生成回答候选的生成精度。

41.根据所述第10方案,能够使用包含疑问句和单一回答的组的单一回答数据集,来生成由疑问句和多个回答的组构成的多回答数据集。

42.根据所述第11方案,能够将使用单一回答数据集而生成的针对疑问句具有不同的回答的多回答数据集,作为多回答阅读理解模型的示教数据,该单一回答数据集包含疑问句和单一回答的组。

43.根据所述第12方案,能够通过使用单一回答数据集而生成的多回答数据集来学习多回答阅读理解模型。

44.根据所述第13方案,除了使用单一回答数据集而生成的多回答数据集以外,还能够通过单一回答数据集来学习多回答阅读理解模型。

45.根据所述第14方案,能够使用通过多回答数据集学习出的多回答模型来生成多回答数据集。

46.根据所述第15方案,与不判断生成数据的妥当性的情况相比,能够提高多个回答的数据集的精度。

47.根据所述第16方案,与不学习判断生成数据的妥当性的模型的情况相比,能够提高妥当性的判断精度。

48.根据所述第17方案,与不判断生成数据的妥当性的情况相比,能够提高多回答阅读理解模型的学习精度。

49.根据所述第18方案,与不判断生成数据的妥当性的情况相比,能够提高多个回答的数据集的精度。

50.根据所述第19方案,与不使问题生成器使用单一回答数据集来学习的情况相比,能够提高由问题生成器生成回答候选的生成精度。

51.根据所述第20方案,能够使用多个单一回答模型分别输出的回答来生成具有多个回答的多回答数据集。

52.根据所述第21方案,能够使用一个单一回答模型所输出的多个回答来生成具有多个回答的多回答数据集。

53.根据所述第22方案,能够使用包含疑问句和单一回答的组的单一回答数据集,来生成由疑问句和多个回答的组构成的多回答数据集。

54.根据所述第23方案,能够使用包含疑问句和单一回答的组的单一回答数据集,来生成由疑问句和多个回答的组构成的多回答数据集。

55.在给出了问题和与该问题相关的文本等分析对象数据的情况下,与使用多个单一回答模型来提取多个回答的情况相比,能够从分析对象数据中高精度地提取针对问题的多个回答。

附图说明

56.图1是示出提取型机器阅读理解的例子的图。

57.图2是示出回答模型所输出的概率分布的例子的图。

58.图3是示出信息处理装置的硬件结构的框图。

59.图4是示出信息处理装置的功能结构的例子的框图。

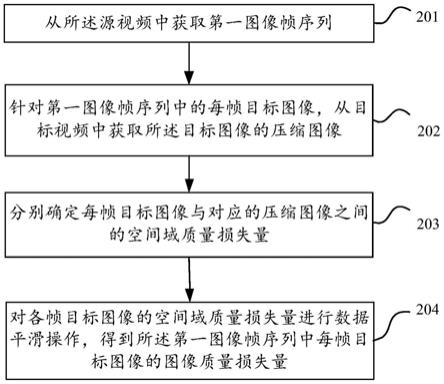

60.图5是示出信息处理装置的学习处理的流程的流程图。

61.图6是说明信息处理装置的学习处理的概要的图。

62.图7是示出信息处理装置的学习处理的流程的流程图。

63.图8是说明信息处理装置的学习处理的概要的图。

64.图9是说明信息处理装置的学习处理的概要的图。

65.图10是示出验证模型的学习处理的概要的图。

66.图11是示出验证模型的验证处理的概要的图。

67.图12是说明信息处理装置的学习处理的概要的图。

68.图13是说明问题重新构建部对问题的重新构建的概要的图。

69.图14是示出基于多回答模型的多回答qa的得分的图。

70.图15是示出基于多回答模型的多回答qa的得分的图。

具体实施方式

71.以下,参照附图说明本发明实施方式的一例。另外,在各附图中,对相同或者等效的结构要素和部分附上了相同的参考标号。此外,为了便于说明,附图的尺寸比率有时被夸大了,与实际比率不同。

72.在详细地说明本发明实施方式以前,对实施方式的基本原理进行说明。

73.机器阅读理解任务是以阅读理解所给出的文本并回答问题为目的的任务。机器阅读理解任务也是在对提取回答的模型的阅读理解能力进行基准测试的方面较重要的任务。例如,在如squad(pranav rajpurkar,jian zhang,konstantin lopyrev,and percy liang.squad:100,000 questions for machine comprehension of text.in emnlp,2016.)这样的提取型机器阅读理解中,在给出了问题和相关文本(上下文)的情况下,从上下文中提取最适当的回答。

74.在提取型机器阅读理解中,正在研究关于单一回答模型的技术,该单一回答模型是针对问题的正解与基于一个回答范围的问题应答(以下,“单一回答qa”)相对应的模型。但是,提取型机器阅读理解要求针对问题的正解不仅与单一回答qa、还与基于多个回答范围的问题应答(以下,“多回答qa”)相对应。

75.图1是示出提取型机器阅读理解的例子的图,并且是示出问题(question)和相关文本(context)的一例的图。在图1所示的提取型机器阅读理解中,提取单一回答或多个回答。在图1中示出了在提取单一回答的情况下,作为相关文本中的针对问题的适当回答提取“47-yard td run”。此外,在图1中示出了在提取多个回答的情况下,作为相关文本中的针对问题的适当回答提取“brown”和“gould”。

76.进行提取型机器阅读理解的回答模型针对被认为与问题对应的回答的范围,根据相关文本输出概率分布并根据概率分布提取回答。图2是示出回答模型所输出的概率分布

的例子的图。图2所示的内容是回答的开始的单词和结束的单词的概率分布。在图2的例子中,在回答模型中,是回答的开始的单词的概率最高的单词计算为“josh”,是回答的结束的单词的概率最高的单词计算为“brown”。因此,回答模型将“josh brown”作为回答输出。

77.本技术发明人发现在多个回答包含在相关文本中的情况下,单一回答模型所输出的回答经常不一致。因此,通过使用多个单一回答模型,能够从问题和相关文本中提取多个回答。但是,本技术发明人也发现准备多个单一回答模型而根据问题提取多个回答时的回答精度存在提高的余地。因此,优选通过与多回答qa对应的多回答模型从问题和相关文本中提取多个回答。

78.为了提高基于多回答模型的回答精度,学习多回答模型。为了学习与多回答qa对应的多回答模型,相比学习与单一回答qa对应的单一回答模型的情况,需要如能够从一个问题中获得多个回答那样的复杂数据集(多回答数据集)。通过手动作业准备这样的复杂数据集非常花费工夫。因此,相比与多回答qa对应的回答模型,优选能够根据数据集的准备不花费工夫的单一回答模型的数据集自动地生成多回答数据集。

79.如以下所说明的那样,能够根据单一回答数据集生成多回答数据集。此外,本技术发明人通过使用所生成的多回答数据集来学习多回答模型并使多回答模型提取回答的技术,与准备多个单一回答模型而根据问题提取多个回答的情况相比,提高了多个回答的提取精度。

80.图3是示出信息处理装置10的硬件结构的框图。图3所示的信息处理装置10是通过与单一回答qa和多回答qa对应的多回答模型根据问题提取单一或多个回答的装置。

81.如图3所示,信息处理装置10具有cpu(central processing unit:中央处理单元)11、rom(read only memory:只读存储器)12、ram(random access memory:随机存取存储器)13、存储器14、输入部15、显示部16和通信接口(i/f)17。各结构经由总线19而连接成能够相互通信。

82.cpu 11为中央运算处理单元,执行各种程序或者控制各部。即,cpu 11从rom12或者存储器14中读出程序,将ram 13作为工作区执行程序。cpu 11根据rom12或者存储器14所记录的程序,进行上述各结构的控制和各种运算处理。在本实施方式中,在rom 12或存储器14中存储有根据单一回答数据集生成多回答数据集的生成程序、使用多回答数据集来学习多回答模型的学习程序和通过多回答模型根据问题提取多个回答的回答提取程序。

83.rom 12存储各种程序和各种数据。ram 13作为工作区暂时存储程序或者数据。存储器14由hdd(hard disk drive:硬盘驱动器)、ssd(solid state drive:固态硬盘)或者闪存等存储装置构成,存储包含操作系统的各种程序和各种数据。

84.输入部15包含鼠标等指示设备和键盘,用于进行各种输入。

85.显示部16例如为液晶显示器,显示各种信息。显示部16可以采用触摸面板方式,作为输入部15发挥功能。

86.通信接口17是用于与用户终端等其他设备进行通信的接口,例如,可使用以太网(注册商标)、fddi、wi-fi(注册商标)等标准。

87.信息处理装置10在执行上述的生成程序、学习程序和回答提取程序时,使用上述的硬件资源实现各种功能。对信息处理装置10所实现的功能结构进行说明。

88.图4是示出信息处理装置10的功能结构的例子的框图。

89.如图4所示,信息处理装置10作为功能结构具有输入部101、问题生成器学习部102、问题生成器存储部103、模型学习部104、模型存储部105和输出部106。通过由cpu 11读出rom 12或存储器14所存储的生成程序、学习程序和回答提取程序并执行,来实现各功能结构。

90.输入部101输入用于使模型学习部104学习多回答模型的信息和用于使多回答模型提取回答的信息。之后叙述输入部101所输入的信息的具体例。此外,输入部101输入用于使所学习的多回答模型提取多个回答的文章和疑问句。

91.问题生成器学习部102使问题生成器进行学习,该问题生成器输出包含用于学习多回答模型的文章(上下文)、问题、回答的组在内的生成数据。问题生成器被问题生成器存储部103所存储,并利用由人生成的单一回答数据集来进行学习。单一回答数据集的种类是任意的。问题生成器例如能够通过神经网络构建。单一回答数据集是具有多个组的数据集,该组包含文章、与该文章相关的问题和针对该问题的回答。问题生成器在输入有文章和该文章中的回答候选时,生成该回答候选成为回答的问题,输出包含所生成的文章和问题的组在内的输出数据。从问题生成器输出的生成数据成为用于学习多回答模型的学习数据的基础。即,从问题生成器输出的生成数据成为根据单一回答数据集生成的多回答数据集的基础。

92.模型学习部104使用生成数据来学习多回答模型,该生成数据包含问题生成器所输出的文章、问题和回答的组。多回答模型存储到模型存储部105中。模型学习部104除了从问题生成器输出的生成数据以外,还使用在问题生成器的学习中使用的单一回答数据集来学习多回答模型。

93.输出部106根据由输入部101输入的文章和疑问句,输出基于多回答模型的机器阅读理解的结果。

94.接着,对信息处理装置10的作用进行说明。

95.(第1生成处理和学习处理)

96.图5是示出信息处理装置10的生成处理和学习处理流程的流程图。此外,图6是说明信息处理装置10的学习处理的概要的图。cpu 11从rom 12或存储器14中读出生成程序和学习程序并在ram 13中展开来执行生成程序和学习程序,由此进行学习处理。

97.cpu 11使用预先所准备的单一回答数据集来使问题生成器进行学习,该问题生成器生成针对回答的疑问句(步骤s101)。在问题生成器的学习中使用的单一回答数据集可以使用任意的单一回答数据集。

98.使用图6对步骤s101的处理进行说明。cpu 11通过将预先所准备的单一回答数据集121输入到问题生成器122中,使问题生成器122学习。单一回答数据集121是如上述那样具有多个组的数据集,该组包含文章、与该文章相关的问题和针对该问题的回答。问题生成器122的学习方法不限于特定的方法。例如,cpu 11也可以以使正确的问题与问题生成器122所生成的问题的误差减少的方式对问题生成器122的参数进行更新,由此使问题生成器122进行学习。

99.在步骤s101之后,cpu 11向学习后的问题生成器122输入文章和该文章中的回答候选(步骤s102)。在步骤s102中,将针对1个文章存在多个回答候选的文章和回答候选输入到问题生成器122中。

100.使用图6对步骤s102的处理进行说明。cpu 11从存储有多个组的文章数据123中取出1个组x’,将组x’输入到问题生成器122中,该组包含文章和该文章中的回答候选。从文章数据123输入到问题生成器122中的x’包含文章c和文章c所包含的回答候选a*。针对1个文章c的回答候选a*至少为两个。回答候选a*可以通过预先对文章c进行分析来生成,也可以通过由人阅读文章c并从文章c中指定能成为回答候选的语句来生成。在文章数据123中,可预先存储有从各种各样的文档来源中提取出的文章。文档来源例如可以是互联网上的网页。此外,文章数据123可以存储到与信息处理装置10相同的装置中,也可以存储到与信息处理装置10不同的装置中。

101.在步骤s102之后,cpu 11根据输入到问题生成器122中的文章和回答候选,使问题生成器122生成基于文章和回答候选的问题,而使其输出由文章、问题和回答候选的组构成的生成数据(步骤s103)。

102.使用图6对步骤s103的处理进行说明。当从文章数据123向问题生成器122输入了由文章c与该文章所包含的回答候选a*构成的组x’时,问题生成器122根据文章c和回答候选a*生成如回答候选a*成为回答这样的问题q*。针对1个文章c的回答候选a*至少为两个,因此,问题生成器122生成的问题q*是多个回答候选a*成为回答的问题。然后,问题生成器122输出由文章c、所生成的问题q*和回答候选a*的组构成的生成数据x’。问题生成器122输出的生成数据x’成为多回答数据集。

103.在步骤s103之后,cpu 11使用问题生成器122所生成的生成数据来学习多回答模型(步骤s104)。

104.使用图6对步骤s104的处理进行说明。问题生成器122所生成的生成数据x’输入到多回答模型124中。cpu 11使用生成数据x’来学习多回答模型124。cpu 11在学习多回答模型124时,进一步将单一回答数据集121输入到多回答模型124中。多回答模型124的学习方法不限于特定的方法。例如,cpu 11也可以以在步骤s102的处理中提取出的回答候选a*与多回答模型124所预测的回答的误差减少的方式对多回答模型124的参数进行更新,由此学习多回答模型124。

105.cpu 11通过执行图5所示的一系列处理,能够使问题生成器生成包含多个回答的生成数据x’。此外,cpu 11通过执行图5所示的一系列处理,能够利用问题生成器所生成的生成数据x’学习多回答模型,该多回答模型输出多个回答。cpu 11根据利用单一回答数据集而学习的问题生成器所生成的生成数据x’学习多回答模型,由此与准备多个单一回答模型而根据问题提取多个回答的情况相比,能够提高多个回答的提取精度。

106.(第2生成处理和学习处理)

107.说明信息处理装置10的生成处理和学习处理的另一例子。图7是示出信息处理装置10的学习处理的流程的流程图。此外,图8是说明信息处理装置10的学习处理的概要的图。cpu 11从rom 12或存储器14中读出生成程序和学习程序并在ram 13中展开来执行生成程序和学习程序,由此进行学习处理。

108.cpu 11使问题生成器使用预先所准备的单一回答数据集来进行学习(步骤s111)。

109.在步骤s111之后,cpu 11向所学习的问题生成器122输入文章和该文章中的回答候选(步骤s112)。在步骤s112中,将针对1个文章存在一个回答候选的文章和回答候选输入到问题生成器122中。

110.在步骤s112之后,cpu 11根据输入到问题生成器122中的文章和回答候选,使问题生成器122生成基于文章和回答候选的问题,而使其输出由文章、问题和回答候选的组构成的生成数据(步骤s113)。

111.使用图8对步骤s113的处理进行说明。当从文章数据123向问题生成器122输入了由文章c与该文章所包含的回答候选a*构成的组x’时,问题生成器122根据文章c和回答候选a*生成如回答候选a*成为回答这样的问题q*。针对1个文章c的回答候选a*为1个,因此,问题生成器122生成的问题q*是1个回答候选a*成为回答的问题。然后,问题生成器122输出由文章c、所生成的问题q*和回答候选a*的组构成的生成数据x’。

112.在步骤s113之后,cpu 11将问题生成器122所生成的生成数据输入到无示教多回答模型125中(步骤s114)。

113.使用图8对步骤s114的处理进行说明。问题生成器122所生成的生成数据x’输入到无示教多回答模型125中。无示教多回答模型例如可以由事先所学习的多个单一回答模型构成,也可以由事先所学习的1个单一回答模型构成。

114.在无示教多回答模型125由事先所学习的多个单一回答模型构成的情况下,无示教多回答模型125根据生成数据x’的输入来使各个单一回答模型根据问题提取回答。而且,在各个单一回答模型提取出的回答不同的情况下,无示教多回答模型125根据生成数据x’输出多个回答。在各个单一回答模型提取出的回答全部相同的情况下,无示教多回答模型125根据生成数据x’输出单一回答。在各个单一回答模型都无法根据问题提取出回答的情况下,无示教多回答模型125输出如无法从生成数据x’中提取出回答的结果。

115.在无示教多回答模型125由事先学习出的一个单一回答模型构成的情况下,无示教多回答模型125根据生成数据x’的输入来使单一回答模型尝试根据问题提取上层n个回答。然后,在单一回答模型提取出的上层n个回答不同的情况下,无示教多回答模型125根据生成数据x’输出多个回答。在单一回答模型提取出的上层n个回答相同的情况下,无示教多回答模型125根据生成数据x’输出单一回答。在单一回答模型无法根据问题提取出回答的情况下,无示教多回答模型125输出如无法从生成数据x’中提取出回答的结果。

116.在已从生成数据x’中提取出多个回答的情况下,无示教多回答模型125将生成数据x’的回答候选置换为提取出的回答。如果使用图8来说明,则在从生成数据x’中提取出多个回答的情况下,无示教多回答模型125将所输入的回答候选a*置换为提取出的回答a^。

117.在步骤s114之后,cpu 11使用无示教多回答模型125所输出的生成数据来学习多回答模型(步骤s115)。

118.使用图8,对步骤s115的处理进行说明。无示教多回答模型125所输出的生成数据x’输入到多回答模型124中。cpu 11使用无示教多回答模型125所输出的生成数据x’来学习多回答模型124。cpu 11在学习多回答模型124时,进一步将单一回答数据集121输入到多回答模型124中。多回答模型124的学习方法不限于特定的方法。例如,cpu 11也可以以使由无示教多回答模型125置换后的回答与多回答模型124所预测的回答的误差减少的方式对多回答模型124的参数进行更新,由此学习多回答模型124。

119.另外,在无示教多回答模型125所输出的生成数据所包含的回答仅为1个的情况或无示教多回答模型125未提取出回答的情况下,在多回答模型124的学习中不使用无示教多回答模型125所输出的生成数据x’。

120.利用生成数据x’学习出的多回答模型124也可以置换为输入有问题生成器122所生成的生成数据的无示教多回答模型125。通过将利用生成数据x’学习出的多回答模型124置换为无示教多回答模型125,能够提高多回答模型124的学习精度。

121.在步骤s115之后,cpu 11判断是否进行了预定次数的多回答模型124的学习(步骤s116)。

122.如果步骤s116的判断结果是多回答模型124的学习次数未达到预定次数(步骤s116:否),则cpu 11返回步骤s112,向学习后的问题生成器122输入文章和该文章中的回答候选。另一方面,如果步骤s116的判断结果是多回答模型124的学习次数达到了预定次数(步骤s116:是),则cpu 11结束一系列处理。

123.cpu 11通过执行图7所示的一系列处理,能够根据文章、问题生成器所生成的问题和根据该问题提取出的回答来学习多回答模型,该多回答模型输出多个回答。cpu 11根据利用单一回答数据集而学习的问题生成器所生成的问题来学习多回答模型,由此与准备多个单一回答模型而根据问题提取多个回答的情况相比,能够提高多个回答的提取精度。

124.(生成数据的验证)

125.cpu 11也可以对问题生成器122所输出的生成数据所包含的问题和回答是否为妥当的问题和回答进行验证。然后,仅在验证出是妥当的问题和回答的情况下,cpu11也可以在多回答模型124的学习中使用问题生成器122所输出的生成数据。生成数据的验证能够应用于上述的第1生成处理和第2生成处理中的任意一个生成处理。

126.图9是说明信息处理装置10的学习处理的概要的图。验证模型126是对问题生成器122所输出的生成数据x’所包含的问题和回答是否是妥当的问题和回答进行验证的模型。在多回答模型124的学习中仅使用由验证模型126判断为是妥当的问题和回答的生成数据x’。

127.说明验证模型126的学习处理的具体例。验证模型126是使用单一回答数据集121所输出的妥当的问题和回答(gold qa)和单一回答数据集121所生成的不适当的问题和回答(疑似qa、pseudo qa)来学习而得的。图10是示出验证模型126的学习处理的概要的图。对于gold qa,作为示教标签赋予true(适当),对于pseudo qa,作为示教标签赋予false(不适当)。

128.接下来,说明基于验证模型126的验证处理的具体例。验证模型126逐一验证问题生成器122所输出的生成数据x’中包含的回答候选。图11是示出验证模型126的验证处理的概要的图。在图11中,验证模型126对问题生成器122所输出的生成数据x’中包含的n1个回答候选分别进行验证。

129.在验证模型126对n1个回答候选分别进行验证的结果是判断为所有回答候选妥当的情况下,也可以在多回答模型124的学习中使用问题生成器122所输出的生成数据x’。然后,在验证模型126判断为任意一个回答候选都不妥当的情况下,也可以不在多回答模型124的学习中使用问题生成器122所输出的生成数据x’。

130.此外,在验证模型126对n1个回答候选分别验证回答的结果是判断为预定的阈值m1个以上(m1《n1)的回答候选妥当的情况下,也可以在多回答模型124的学习中使用问题生成器122所输出的生成数据x’。然后,在验证模型126判断为仅小于m1个的回答候选妥当的情况下,也可以不在多回答模型124的学习中使用问题生成器122所输出的生成数据x’。

131.此外,验证模型126针对n1个回答候选分别验证回答后,也可以仅将判断为妥当的回答候选作为回答候选a^重新构建出的生成数据x^,设为多回答模型124的示教数据。在验证模型126判断为妥当的回答候选的数量为一个以下的情况下,不在多回答模型124的学习中使用问题生成器122所输出的生成数据x’。

132.(回答的重新构建)

133.cpu 11也可以尝试重新构建问题生成器122所输出的生成数据中包含的回答。cpu 11也可以通过输入到多个单一回答模型中,来进行回答的重新构建。回答的重新构建也能够应用于上述的第1生成处理和第2生成处理的任意一个生成处理。

134.图12是说明信息处理装置10的学习处理的概要的图。问题重新构建部127由多个单一回答模型构成,问题重新构建部127中输入问题生成器122所输出的生成数据x’。然后,问题重新构建部127对生成数据x’进行问题的重新构建,仅将已重新构建出的生成数据x’作为多回答模型124的示教数据输出。

135.图13是说明问题重新构建部127对问题的重新构建的概要的图。问题生成器122所输出的生成数据x’输入到m2个单一回答模型中。m2为生成数据x’所包含的回答候选的数量n2以上。m2个单一回答模型分别生成并输出预测回答a~m2。

136.然后,仅在全部预测回答与回答候选一致的情况下,问题重新构建部127将问题生成器122所输出的生成数据x’追加到多回答模型124的示教数据中。问题重新构建部127根据各回答的单词或字符串单位的完全一致(em)或部分一致(f1)来评价预测回答与回答候选是否一致。

137.在图13的例子中,回答候选a2与任何预测回答都不一致,因此,问题重新构建部127视作未能对该生成数据x’进行回答候选的重新构建。因此,问题重新构建部127不将该生成数据x’作为多回答模型124的示教数据追加而仅视作不适当的例子舍弃。

138.信息处理装置10将通过问题重新构建部127的重新构建而输出的生成数据x’作为多回答模型124的示教数据,由此与不由问题重新构建部127重新构建的情况相比,能够提高在多回答模型124的学习中使用的示教数据的精度。

139.(本实施方式的生成处理和学习处理的效果)

140.说明本实施方式的生成处理和学习处理的效果。

141.图14是示出基于通过学习处理而学习出的多回答模型的多回答qa的得分的图,该学习处理使用了通过本实施方式的生成处理而生成的生成数据。在图14中,使用了通过第2学习处理而学习出的多回答模型。作为比较例示出的内容是使用多个单一回答模型(无示教模型)而提取出多个回答的多回答模型。在单一回答数据集中,使用了quoref(pradeep dasigi,nelson f.liu,ana marasovic,noah a.smith,matt gardner.quoref:a reading comprehension dataset with questions requiring coreferential reasoning.in emnlp-ijcnlp,2019.)。如图14所示,关于基于通过本实施方式的学习处理而学习出的多回答模型的多回答qa的得分,示出完全一致(em)、部分一致(f1)均比使用多个单一回答模型而提取出多个回答的情况高的得分。

142.图15是示出基于通过学习处理而学习出的多回答模型的多回答qa的得分的图,该学习处理使用了通过本实施方式的生成处理而生成的生成数据。在图15中,使用了通过第2学习处理而学习出的多回答模型。作为比较例示出的内容是利用由人手动生成的数据集

(gold)而学习出的多回答模型和使用多个单一回答模型(无示教模型)而提取出多个回答的多回答模型。与图14的例子同样,在单一回答数据集中使用了quoref。

143.如图15所示,表示最高得分的模型是利用由人手动生成的数据集(gold)而学习出的多回答模型。但是,关于基于通过本实施方式的学习处理而学习出的多回答模型的多回答qa的得分,示出完全一致(em)、部分一致(f1)均比使用多个单一回答模型来提取出多个回答的情况高的得分。

144.这样,本实施方式的信息处理装置10能够使用通过多回答数据集而学习出的多回答模型来从文章中提取多个回答,该多回答数据集是根据单一回答数据集而生成的。本实施方式的信息处理装置10能够根据单一回答数据集来生成多回答数据集。而且,本实施方式的信息处理装置10使通过所生成的多回答数据集而学习出的多回答模型提取回答,由此与准备多个单一回答模型而根据问题提取多个回答的情况相比,能够提高多个回答的提取精度。

145.另外,也可以由除了cpu以外的各种处理器执行在上述各实施方式中由cpu读入软件(程序)并执行的生成处理、学习处理和回答提取处理。作为该情况下的处理器,可例示fpga(field-programmable

146.gate array:现场可编程门阵列)等在制造之后可变更电路结构的pld(programmable logic device:可编程逻辑器件)、和asic(application specific integrated circuit:专用集成电路)等为了执行特定的处理而具有专门设计的电路结构的处理器即专用电路等。此外,可以由这些各种处理器中的1个处理器执行生成处理、学习处理和回答提取处理,也可以由相同种类或不同种类的2个以上的处理器的组合(例如,多个fpga、以及cpu与fpga的组合等)执行生成处理、学习处理和回答提取处理。此外,更具体而言,这些各种处理器的硬件结构为对半导体元件等电路元件进行组合而得到的电路。

147.此外,在上述各实施方式中,说明了将生成处理、学习处理和回答提取处理的程序预先存储(安装)到rom或存储器中的方式,但是,不限定于此。程序也可以通过记录于cd-rom(compact disk read only memory:光盘只读存储器)、dvd-rom(digital versatile disk read only memory:数字通用光盘只读存储器)和usb(universal serial bus:通用串行总线)存储器等非易失(non-transitory)记录介质的方式提供。此外,程序也可以为经由网络从外部装置下载的方式。

148.在上述各实施方式中,处理器是指广义的处理器,包含通用的处理器(例如,cpu(central processing unit:中央处理单元)等)、专用的处理器(例如,gpu(graphics processing unit:图形处理单元)、asic(application specific integrated circuit:专用集成电路)、fpga(field programmable gate array:现场可编程门阵列)、可编程逻辑器件等)。

149.此外,上述各实施方式中的处理器的动作不仅通过一个处理器完成,可以由存在于物理上远离的位置的多个处理器协作完成。此外,处理器的各动作的顺序不仅限定于上述各实施方式所记载的顺序,也可以适当变更。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。