1.本公开涉及自然语言处理领域,具体而言,涉及一种情感预测模型的训练方法及装置。

背景技术:

2.近些年,预训练的语言模型在多领域情感分析中得到了广泛的应用,并取得了很好的效果。然而,由于不同领域上用户表达情感的差异性,在源领域对模型进行微调很容易过拟合,从而导致当将模型从源领域迁移到目标领域时,在目标领域表现很差。而且由于预训练模型的参数较大,微调在训练速度和空间上都消耗较大,对训练样本的数目也要求更高。

技术实现要素:

3.有鉴于此,本公开的目的是提供一种情感预测模型的训练方法及装置,使得得到的预训练模型从源领域迁移到目标领域时权重参数无需调整或者只需很少资源就可完成调整。

4.第一方面,本公开实施例提供一种情感预测模型的训练方法,包括:

5.获取多个无监督语料;

6.对所述无监督语料中的至少一个情感表述进行掩盖,将掩盖前的语料和掩盖后的语料作为训练样本输入给情感预测模型;

7.其中,所述情感预测模型用于:针对所述训练样本中的被掩盖的情感表述进行词预测任务及词情感预测任务,并根据词预测任务结果、词情感预测任务结果以及所述掩盖前的语料计算任务误差,并基于所述任务误差修正所述情感预测模型的权重系数。

8.可选地,所述情感表述包括:和领域无关的情感词、表情符中的至少一种;在所述无监督语料中,所述情感表述被掩盖的概率高于非情感表述。

9.可选地,所述掩盖操作包括:

10.将被掩盖内容替换为特殊字符;和/或,

11.将被掩盖内容替换为其他词。

12.可选地,所述情感预测模型还用于:

13.针对所述掩盖后的语料进行句子级情感预测任务;以及

14.根据句子级情感预测任务结果和所述掩盖前的语料计算任务误差,并基于所述任务误差修正所述情感预测模型的权重系数。

15.可选地,所述无监督语料包括评论打分,所述针对所述掩盖后的语料进行句子级情感预测任务包括:根据评论打分和所述掩盖后的语料的情感信息进行句子级情感预测任务。

16.可选地,所述情感预测模型还用于:根据句子级情感预测任务结果和词情感预测任务结果得到所述无监督语料的情感预测结果。

17.可选地,在所述掩盖操作中,利用通用的情感字典在所述无监督语料中确定所述情感词,和/或,利用正则表达式在所述无监督语料中确定所述表情符。

18.第二方面,本公开实施例提供一种情感预测模型的训练装置,包括:

19.数据获取模块,用于获取多个无监督语料;

20.样本准备模块,用于对所述无监督语料中的至少一个情感表述进行掩盖,将掩盖前的语料和掩盖后的语料作为训练样本输入给情感预测模型;

21.模型训练模块,用于利用所述训练样本训练所述情感预测模型,所述情感预测模型用于:针对所述训练样本中的被掩盖的情感表述进行词预测任务及词情感预测任务,并根据词预测任务结果、词情感预测任务结果以及所述掩盖前的语料计算任务误差,并基于所述任务误差修正所述情感预测模型的权重系数。

22.可选地,所述情感表述包括:和领域无关的情感词、表情符中的至少一种;在所述无监督语料中,所述情感表述被掩盖的概率高于非情感表述。

23.可选地,所述掩盖操作包括:

24.将被掩盖内容替换为特殊字符;和/或,

25.将被掩盖内容替换为其他词。

26.可选地,所述情感预测模型还用于:

27.针对所述掩盖后的语料进行句子级情感预测任务;以及

28.根据句子级情感预测任务结果和所述掩盖前的语料计算任务误差,并基于所述任务误差修正所述情感预测模型的权重系数。

29.可选地,所述无监督语料包括评论打分,所述针对所述掩盖后的语料进行句子级情感预测任务包括:根据评论打分和所述掩盖后的语料的情感信息进行句子级情感预测任务。

30.可选地,所述情感预测模型还用于:根据句子级情感预测任务结果和词情感预测任务结果得到所述无监督语料的情感预测结果。

31.可选地,在所述掩盖操作中,利用通用的情感字典在所述无监督语料中确定所述情感词,和/或,利用正则表达式在所述无监督语料中确定所述表情符。

32.第三方面,本公开实施例提供一种电子设备,包括存储器和处理器,所述存储器还存储有可由所述处理器执行的计算机指令,所述计算机指令被执行时,实现上述任一项所述的训练方法。

33.第四方面,本公开实施例提供计算机可读介质存储,该计算机可读介质存储有可由电子设备执行的计算机指令,所述计算机指令被执行时,实现上述任一项所述的训练方法。

34.本公开实施例提供的情感预测模型的训练方法及装置,通过对情感表述进行掩盖操作构建训练样本,利用这样的训练样本对待训练的情感预测模型进行训练,不但可以提高情感预测分析任务的准确率,也可以提高模型的稳定性,大大减少训练样本的数目。

35.进一步地,无监督语料中的被掩盖的至少一个情感表述是领域无关的情感词和/或表情符,因此当将训练好的情感预测模型从源领域迁移到目标领域时,权重系数无需调整或者调整很小,并且,由此使得训练好的情感预测模型能够应用于多个领域的情感预测任务。

附图说明

36.通过参考以下附图对本公开实施例的描述,本公开的上述以及其它目的、特征和优点将更为清楚,在附图中:

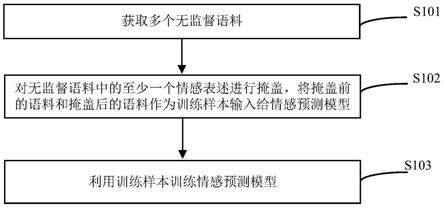

37.图1是本公开实施例的情感预测模型的训练方法的流程图;

38.图2是计算机领域和餐饮领域的两个无监督语料的对比示例;

39.图3是一个transformer编码器的网络结构示意图。;

40.图4是采用情感预测模型进行情感预测的示例图;

41.图5是本公开实施例的情感预测模型的训练装置的结构示意图;

42.图6示出了不同模型从源领域迁移到目标领域的得分值和平均分;

43.图7给出了本方案和其他模型在时间空间和收敛性的对比示例;

44.图8a-8c分别给出本方案和其他模型进行多个不同领域迁移时表征样本数目和模型准确性的关联性的线性对比图;

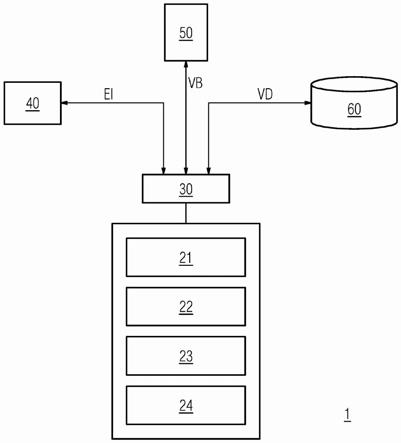

45.图9示出了用于实施本公开实施例的电子设备的结构图。

具体实施方式

46.以下基于实施例对本公开进行描述,但是本公开并不仅仅限于这些实施例。在下文对本公开的细节描述中,详尽描述了一些特定的细节部分。对本领域技术人员来说没有这些细节部分的描述也可以完全理解本公开。为了避免混淆本公开的实质,公知的方法、过程、流程没有详细叙述。另外附图不一定是按比例绘制的。

47.在本文中使用以下术语。

48.多领域情感分析系统(multi-domain sentiment analysis system): 给定用户的文本,理解用户的情感极性。该任务的特点是多领域,文本包含多个领域,包括源领域和目标领域,源领域往往包含大量的标签数据,而目标领域则只有少量甚至没有标签数据。为此,需要在源领域训练模型,将情感知识迁移到目标领域进行情感分析。

49.预训练模型(pre-trained models):众所周知,模型训练通常需要大量资源,包括但不局限于大量需要标注的样本数据以及执行训练的计算机资源,因此模型训练并不容易执行。而预训练模型则提供了一组较好的权重参数值。研发人员可以直接将其应用到实际场景中,或者在应用到实际场景之前,只需要简单的修改输入和输出层,再用自己的数据进行一个增量训练,对权重参数值进行微调即可。本文所指预训练模型是指专用于自然语言处理领域的预训练语言模型。

50.微调(fine-tune):将预训练模型用于特定任务,根据特定任务的有监督数据对模型的权重系数进行更新调整,从而更好的适应特定任务。

51.过拟合(overfitting):由于源领域和目标领域之间情感的表达存在很大的差异,为此,在源领域训练会因为学习过多的领域知识导致模型过拟合,从而在目标领域表现不好。

52.图1是本公开实施例的情感预测模型的训练方法的流程图。

53.如图1所示,该流程图包括以下步骤。

54.在步骤s101中,获取多个无监督语料。

55.在步骤s102中,对无监督语料中的至少一个情感表述进行掩盖,将掩盖前的语料

和掩盖后的语料作为训练样本输入给情感预测模型。

56.在步骤s103中,利用训练样本训练情感预测模型。

57.参考图1所示,该方法中的多个无监督语料可来自数量众多的不同领域,例如可以从多个领域的应用平台软件的数据库中采集得到,并且注意应该采集那些表达丰富情感的文本数据,例如在电商平台上经常有客户对商品进行评论,这些评论通常反映客户对商品的好恶程度以及对商品的打分,因此非常适于作为无监督语料。得到无监督语料之后,在无监督语料中定位情感表述,情感表述包括情感词和表情符,例如,可利用通用的情感字典作为情感知识库,基于情感知识库来定位无监督语料中的情感词,同时利用正则表达式定位无监督语料中的表情符。之后,采用掩盖操作,将至少一个情感表述掩盖掉。将掩盖操作之后的语料和掩盖操作之前的语料作为训练样本输入给待训练的情感预测模型进行训练,以得到训练好的情感预测模型。

58.图2是计算机领域和餐饮领域的两个无监督语料的对比示例。下面通过图2的示例对图1的实施例进行示例性说明。参考图上所示,标记 201表示计算机领域的无监督语料的一个示例,标记202表示餐饮领域的无监督语料的一个示例。这里为了方便演示,通过下划线将情感表述标记出来,从图上可以看出,语料201中包括的情感词和表情符有 (

‘

fast’,

‘

bad’,

‘

never’),语料202中包括的情感词和表情符有(

‘

beautiful’,

‘

fast’,

‘

delicious’)。则基于图1所示的训练方法,将语料201和202中的上述情感词和表情符掩盖后,将掩盖前的201和掩盖后的201作为一个训练样本,将掩盖前的202和掩盖后的202作为另一个训练训练,提供给待训练的情感预测模型进行训练。

59.在本实施例中,通过对情感表述进行掩盖操作构建训练样本,利用这样的训练样本对待训练的情感预测模型进行训练,不但可以提高情感预测分析任务的准确率,也可以提高模型的稳定性,大大减少训练样本的数目。

60.继续参考图2所示,语料201和202的情感词和表情符中,和领域相关的情感词只有

‘

fast’,例如形容一个人跑得快时,这时

‘

fast’表达的情感是积极的,但是形容耗电快就是消极的,因此

‘

fast’是和领域有关的情感词。对于无监督语料201,和领域无关的情感词和表情符有(

‘

bad’,

‘

never’),表情符通常总是和领域无关的。对于无监督语料202,和领域无关的情感词和表情符有 (

‘

beautiful’,

‘

delicious’)。如果将表达的情感分类为积极、消极和中性,则(

‘

bad’,

‘

never’)的每个词的情感分类均为消极,而(

‘

beautiful’,

‘

delicious’)的每个词的情感分类均为积极。

61.基于此,作为进一步的实施例,为了训练出和领域无关的情感预测模型,对于无监督语料的情感表述的掩盖操作,只对和领域无关的情感词和表情符进行掩盖操作,例如,语料201中的 (

‘

beautiful’,

‘

delicious’)被施加了掩盖操作,而

‘

fast’没有被施加掩盖操作,或者在大量的训练样本中,大部分的训练样本中的和领域无关的情感词和表情符被施加掩盖操作,而只有小部分的训练样本中的和领域相关的情感词被施加掩盖操作。

62.值得注意的是,掩盖操作不仅可以施加在情感词和/或表情符上,还可以施加在情感词和表情符之外的中性词上,这样可以提升词预测任务的准确性,而且对于同一个无监督语料,可以对其中的多个不同词实施掩盖操作,以得到多个训练样本。

63.进一步地,在随机掩盖操作中,领域无关的情感词和/或表情符在多个无监督语料中被设置为比领域相关的情感词或中性词有更大的概率被掩盖。

64.图3是一个transformer编码器的网络结构示意图。

65.参考图上所示,编码器300的输入数据是文本数据的每个词对应的词向量311以及根据每个词的位置信息得到的位置编码向量312。位置编码向量312根据每个词在文本数据中的位置信息生成。现有技术中有多种位置编码算法可供选择,这里就不一一描述。

66.如图上所示,编码器300由两个子层组成。第一个子层包括用于自注意力操作的自注意力层301,第二个子层包括全连接前馈网络303。在每两个子层之间都使用了残差连接(residual connection)和归一化 (对应于归一化层302和归一化层304)。每个子层的输出可以表示为: layernorm(x sublayer(x)),sublayer(x)是分别是自注意力层301和全连接前馈网络303实现的函数。自注意力层301实现的函数如下所示:

67.x*wq=q

ꢀꢀ

(1)

68.x*wk=k

ꢀꢀ

(2)

69.x*wv=v

ꢀꢀ

(3)

70.其中,x表示输入矩阵,权重矩阵wq,wk,wv表示经由训练得到权重系数,q、k和v表示查询矩阵(query)、键矩阵(key)和值矩阵(value)。

71.然后用公式(4)得到输出,并将输出给求和与归一化层302。

[0072][0073]

表示键向量的维数的平方根,t表示矩阵的转置。

[0074]

全连接前馈网络303包括两个线性交换,然后使用函数relu作为激活函数。

[0075]

ffn(x)=relu(xw1 b1)w2 b2ꢀꢀ

(5)

[0076]

x是输出矩阵,w1和w2是训练得到的权重系数,b1和b2是偏置参数。当然,上述公式会根据实际网络结构有所调整,本公开不局限于此。

[0077]

上述一个或多个编码器300叠加而成的网络结构经训练后,可用于多种自然语言处理任务,例如语音归归纳、文本翻译、关键词抽取、情感预测、等等。而本公开实施例可利用编码器300构建待训练的情感预测模型。在构建时,情感预测模型可由输入层、一个或多个编码器300 以及输出层组成。输入层的功能是接收掩盖操作之后的无监督语料以及掩盖操作之前的无监督语料,并根据每个词构建成词向量和位置编码向量并输出给一个或多个编码器300。一个或多个编码器300的作用是对输入向量进行一系列的计算,并得到另一个维度的输出向量。输出层的作用是根据输出向量确定与被掩盖词对应的词预测以及由此得到的词情感预测。

[0078]

待训练的情感预测模型需要经过反复训练才能够确定权重系数,即不断地将训练样本输入给待训练的情感预测模型,由待训练的情感预测模型执行被掩盖词的词预测任务和词情感预测任务,然后,根据前馈神经网络的误差反向传播算法修正权重系数。由于训练样本包括掩盖操作之前的无监督语料和掩盖操作之后的无监督语料,因此掩盖操作之前的无监督语料和掩盖操作之后的无监督语料经过编码器的各个层的数学计算,并得到任务误差,根据误差反向传播算法基于任务误差修正权重系数。

[0079]

应该强调的是,上述实施例是针对单词级的词预测和词情感预测,输入给编码器

的无监督语料都会转换为词向量和位置编码向量,由此得到的模型是针对单词级作情感预测。可选地,在待训练的情感预测模型中,根据单词级的情感预测结果归纳出句子级情感预测结果,例如,如果句子末尾中包含笑脸的表情符号,则将该句子归类为积极,再例如,如果句子中包括多个情感词,则如果超过一定比例的情感词都表示了

‘

积极’的情感,则可将句子的情感预测确定为

‘

积极’。

[0080]

再有,情感预测模型除了以上的单词级的词预测和词情感预测之外,还可以用于句子级情感预测任务,例如,针对掩盖操作之后的无监督语料进行句子级情感预测任务,然后根据句子级情感预测任务结果和掩盖操作之前的无监督语料计算任务误差,并基于任务误差修正情感预测模型的权重系数。

[0081]

对于情感预测模型来说,可以设置句子级的情感预测和单词级的情感预测各自独立进行,例如一部分编码器专用于句子级的情感预测任务,另一部分的编码器专用于单词级的情感预测任务。单词级情感预测结果和句子级情感预测结果可以互相验证,例如根据单词级情感预测结果归纳出句子级情感预测结果,并根据归纳出来的句子级情感预测结果验证直接得到的句子级情感预测结果,反之亦然。

[0082]

图4是采用情感预测模型进行情感预测的示例图。无监督语料包括文本内容

‘

fast and cheerful service,food was pretty good’和一个评论打分rating。首先根据上述实施例,将

‘

cheerful’、

‘

good’确定为领域无关的情感词,将为表情符,因此掩盖操作将上述情感词和表情符掩盖掉。将掩盖操作之后的上述文本和掩盖操作之前的上述文本同时输入给情感预测模型400。情感预测模型400可采用如图3 所示的编码器构建,用于产生输出向量x1-x11,并在对应的单词位置输出情感预测,其中

‘

cheerful’和

‘

good’都表达

‘

positive’(积极) 的情感,表情符也表示

‘

positive’的情感。同时,情感预测模型400还针对整个文本内容

‘

fast and cheerful service,food waspretty good’和rating输出五星标识。rating表示包含在原文本内容中的打分分值,例如可以将电商平台上的客户对商品的评论作为无监督语料,这种情况下,无监督语料中通常会包括客户对商品的打分分值。

[0083]

值得注意的是,上述示例虽然都采用英文,但是中文示例也是可以的,情感词包括一个或多个汉字。

[0084]

和上述方法对应,本公开实施例还提供情感预测模型的训练装置,该装置如图5所示,包括数据获取模块501、样本准备模块502和模型训练模块503。数据获取模块501用于收集多个无监督语料。样本准备模块502用于对无监督语料中的至少一个情感表述进行掩盖,将掩盖前的语料和掩盖后的语料作为训练样本输入给情感预测模型。模型训练模块503用于利用训练样本训练待训练的情感预测模型,其中,待训练的情感预测模型的训练过程为:针对训练样本中的被掩盖的情感表述进行词预测任务及词情感预测任务,并根据词预测任务结果、词情感预测任务结果以及掩盖前的语料计算任务误差,并基于任务误差修正情感预测模型的权重系数。

[0085]

在一些实施例中,对于无监督语料执行随机掩盖操作,但领域无关的情感词和/或表情符被设置为比其他词(包括中性词和和领域相关的情感词)有更大的概率被掩盖。掩盖操作包括:将被掩盖内容替换为特殊字符;和/或,将被掩盖内容替换为其他词。

[0086]

在一些实施例中,所述待训练的情感预测模型还用于针对掩盖后的语料进行句子级情感预测任务;以及根据句子级情感预测任务结果和掩盖前的语料计算任务误差,并基于任务误差修正情感预测模型的权重系数。句子级情感预测和单词级情感预测可在模型中各自独立地进行,也可以交叉进行。

[0087]

在一些实施例中,待训练的情感预测模型还被配置为:连接句子级情感预测结果和词情感预测结果,并根据句子级情感预测结果和词情感预测结果得到无监督语料最终的情感预测结果。

[0088]

综上所述,本公开实施例提供的情感预测模型的训练方法及装置,基于掩盖操作构建训练样本,利用这样的训练样本对待训练的情感预测模型进行训练,不但可以提高情感预测分析任务的准确率,也可以提高模型的稳定性,大大减少训练样本的数目。

[0089]

图6示出了不同模型从源领域迁移到目标领域的得分值和平均分。如图上所示,模型bert-daat整体得分为90.12。本方案(sentix

fix

)与其他模型在不同领域上的对比,可以看出本方案在所有领域上都远超对比模型。sentix

fix

是基于本公开实施例在sentix基础上的改进方案。这也为情感分析任务提供一个统一的接口提供了可能,不再需要针对不同领域去训练一个模型。同时,通过本方案的训练方式,在保证模型准确率的同时,可以大大的减少跨领域任务的训练时间和空间,加快模型的收敛。

[0090]

表7给出了本方案和其他模型在时间空间和收敛性的对比示例。从图上可以看出,本方案(sentix

fix

)可以快速收敛,同时只要2k的训练参数,而未改进前的基础模型sentix却需要133m的训练参数,同时本方案运行速度是基础模型sentix的三倍。

[0091]

图8a-8c分别给出本方案和其他模型进行多个不同领域迁移时表征样本数目和模型准确性的关联性的线性对比图。如图上所示,横坐标表示训练数目,纵坐标表示模型准确性。从图上可以看出,本方案(sentix

fix

) 在领域b到e、d到b以及e到d的领域迁移时,在样本数目很小的情况下也能够取得很好的效果。b表示图书,e标识电子信息,d表示dvd。

[0092]

本公开实施例还提供一种电子设备90,如图9所示,在硬件层面,包括存储器902和处理器901,除此之外,一些情况下还包括输入输出设备903和其他硬件904。存储器902例如为高速随机存取存储器 (random-access memory,ram),也可能是非易失性存储器(non-volatilememory),例如为至少1个磁盘存储器等。输入输出设备903例如为显示器、键盘、鼠标、网络控制器等设备。处理器901可以基于目前市场上各种型号的处理器构建。处理器901、存储器902、输入输出设备903 和其他硬件904通过总线相互连接,该总线可以是isa(industrystandard architecture,工业标准体系结构)总线、pci(peripheralcomponent interconnect,外设部件互连标准)总线或eisa(extendedindustry standard architecture,扩展工业标准结构)总线等。所述总线可以分为地址总线、数据总线、控制总线等。为便于表示,图9中仅用一个线条表示,但并不表示仅有一根总线或一种类型的总线。

[0093]

存储器902用于存放程序。具体地,程序可以包括程序代码,程序代码包括计算机指令。存储器可以包括内存和非易失性存储器,并向处理器901提供计算机指令和数据。处理器901从存储器902中读取对应的计算机程序到内存中然后运行,在逻辑层面上述实施例的模型预训练方法。

[0094]

本领域的技术人员能够理解,本公开可以实现为系统、方法和计算机程序产品。因此,本公开可以具体实现为以下形式,即完全的硬件、完全的软件(包括固件、驻留软件、微

代码),还可以实现为软件和硬件结合的形式。此外,在一些实施例中,本公开还可以实现为一个或多个计算机可读介质中的计算机程序产品的形式,该计算机可读介质中包含计算机可读的程序代码。

[0095]

可以采用一个或多个计算机可读介质的任意组合。计算机可读介质可以是计算机可读信号介质或者计算机可读存储介质。计算机可读存储介质例如但不限于为电、磁、光、电磁、红外线或半导体的系统、装置或器件,或其他任意以上的组合。计算机可读存储介质的更具体的例子包括:具体一个或多个导线的电连接,便携式计算机磁盘、硬盘、随机存取存储器(ram)、只读存储器(rom)、可擦除可编程只读存储器(eprom 或者闪存)、光纤、便携式紧凑磁盘只读存储器(cd-rom)、光存储器、磁存储器或者上述任意合适的组合。在本文中,计算机可读的存储介质可以是任意包含或存储程序的有形介质,该程序可以被处理单元、装置或者器件使用,或者与其结合使用。

[0096]

计算机可读信号介质可以包括在基带中或者作为截波一部分传播的数据信号,其中承载了计算机可读的程序代码。这种传播的数据信号可以采用多种形式,包括但不限于电磁信号、光信号或者其他任意合适的组合。计算机可读的信号介质还可以是计算机可读存储介质之外的任何计算机可读介质,该计算机可读介质可以发送、传播或者传输用于由指令系统、装置或器件使用或者与其结合使用的程序。

[0097]

计算机可读介质上包含的程序代码可以用任何适当的介质传输,包括但不限于无线、电线、光缆、rf等等,以及上述任意合适的组合。

[0098]

可以以一种或者多种程序设计语言或者组合来编写用于执行本公开实施例的计算机程序代码。所述程序设计语言包括面向对象的程序设计语言,例如java、c ,还可以包括常规的过程式程序设计语言,例如c。程序代码可以完全地在用户计算机上执行、部分地在用户计算机上执行、作为一个独立的软件包执行、部分在用户计算机上部分在远程计算机上执行、或者完全在远程计算机或服务器上执行。在涉及远程计算机的情形中,远程计算机可以通过任意种类的网络包括局域网(lan)或广域网(wan)连接到用户计算机,或者,可以连接到外部计算机(例如利用因特网服务提供商来通过因特网连接)。

[0099]

以上所述仅为本公开的优选实施例,并不用于限制本公开,对于本领域技术人员而言,本公开可以有各种改动和变化。凡在本公开的精神和原理之内所作的任何修改、等同替换、改进等,均应包含在本公开的保护范围之内。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。