1.本发明涉及驾驶员驾驶行为识别领域,特别是一种基于循环图卷积网络的驾驶员驾驶行为识别方法。

背景技术:

2.驾驶员驾驶行为是安全行车的一个重要因素。据世界卫生组织统计,全球每年约125万人死于道路交通事故,2000万人由此受到严重伤害,而约80%的道路交通事故直接或间接地归咎于人为因素。因此建立一个驾驶员驾驶行为识别系统显得尤为重要。

3.现有的驾驶员驾驶行为识别方法大致可分为两类:

4.1)基于人工特征的驾驶员驾驶行为识别方法。通过构建特征提取公式,将图像信息或头部转角、眼动等生理信息转化为区分度更大的特征信息(如梯度直方图、光流、注视区域等),然后运用svm等机器学习分类器实现驾驶员驾驶行为识别。

5.2)基于深度学习的驾驶员驾驶行为识别方法。利用深度学习强大的特征提取能力,将原始传感器信息自适应地转化为具有显著辨别性的高维特征向量,通过制定合理的损失函数和优化器,不断更新网络的权值参数以获取最佳驾驶员驾驶行为识别模型,最终运用softmax等分类器实现驾驶员驾驶行为识别。

6.基于人工特征的驾驶员驾驶行为识别算法流程如图1所示。首先通过传感器获取图像信息、生理信息等原始输入数据。然后根据输入数据特性人为地制定特征提取算法,将原始数据转化为人工特征,如头部姿态、光流、梯度直方图、注视区域等。最终由svm等分类器对人工特征分类,输出最终的驾驶员驾驶行为类别。

7.基于人工特征的驾驶员驾驶行为识别算法的缺点主要有以下两点:

8.1)人工特征受图像质量影响较大,而图像质量随环境(如光照)变化较大,因此难以建立一个稳定的特征提取过程。

9.2)在多驾驶员驾驶行为分类时,存在某些驾驶员驾驶行为相似性大的情况,此时难以构建一种在各类驾驶员驾驶行为间都有显著区分性的人工特征。

10.基于传统循环神经网络的驾驶员驾驶行为识别算法流程如图2所示。循环神经网络lstm将视频流中的人体骨架像素坐标信息转化为高维特征向量,通过损失函数和优化器不断更新循环神经网络的权值,最终由softmax函数(归一化指数函数)计算各分类概率,获得最终的驾驶员驾驶行为分类。

11.基于传统循环神经网络的驾驶员驾驶行为识别算法的缺点主要有以下两点:

12.1)循环神经网络仅在时间维度上具有良好的特征提取能力,缺乏在单帧图像中提取空间特征的能力。

13.2)原始人体骨架信息仅以一维向量的形式进入lstm网络,丢失了人体结构特征和各节点间的相互作用关系,导致lstm网络的识别效果欠佳。

技术实现要素:

14.本发明所要解决的技术问题是,针对现有技术不足,提供一种基于循环图卷积网络的驾驶员驾驶行为识别方法及系统,快速、准确地识别驾驶员驾驶行为。

15.为解决上述技术问题,本发明所采用的技术方案是:一种基于循环图卷积网络的驾驶员驾驶行为识别方法,包括以下步骤:

16.1)利用骨架信息构建人体骨架结构图,利用循环图卷积网络对所述骨架结构图进行图卷积运算,提取骨架信息空间特征向量;

17.2)将所述骨架信息空间特征向量作为lstm网络的输入,计算骨架信息在时间上的动态特征,基于注意力机制融合各时刻的动态特征,获取最终的时空特征向量,利用最终的时空特征向量,计算驾驶员驾驶行为的概率分布,预测驾驶员的驾驶行为。

18.本发明的方法不仅能提取骨架信息时间特征,还提取了骨架信息空间特征,提高了模型对于人体骨架节点之间、肢体之间空间特征的提取能力,从而保证人体结构特征和各节点间的相互作用关系能进入lstm网络,保证了lstm网络识别的准确性。

19.步骤1)的具体实现过程包括:

20.1)输入视频流数据;

21.2)从视频图像中提取骨架信息;

22.3)对所述骨架信息进行批次内归一化预处理;

23.4)利用预处理后的骨架信息构建骨架结构图;

24.5)对所述骨架结构图进行图卷积运算,提取骨架信息空间特征。

25.从上述过程可见,本发明依据人体运动学的图卷积网络,提高了模型对于人体骨架节点之间、肢体之间空间特征的提取能力。

26.优选地,在循环图卷积网络的每一个卷积层之前均对所述骨架信息进行批次内归一化预处理。使数据分布更接近正态分布,更切合实际分布,保证模型训练时的可学习能力,提高模型的非线性表达能力。

27.从视频图像中提取骨架信息的具体实现过程包括:利用预训练的cnn网络从视频图像中提取驾驶员骨架节点的像素坐标,第i帧图像的骨架信息以a

t

=(x1,y1,

…

,xi,yi,

…

xm,ym)形式储存,(xi,yi)分别为索引为i的骨架节点的像素横坐标和像素纵坐标;第i帧图像的骨架信息保留驾驶员上半身m个节点坐标,连续t帧图像的骨架信息构成序列z=(a1,

…

,a

t

,

…

,a

t

)。该提取过程简单,实用新强。

28.步骤4)中,为了保留节点间的相互作用关系,构建的骨架结构图g表示如下:

29.g=(n,l);

[0030][0031][0032]

其中,l

ij

为骨架节点ni与骨架节点nj的连接关系;为预处理后的像素坐标值。

[0033]

步骤5)中,骨架信息空间特征向量其中为节点i的空间特征;f

in

为节点状态值;s(ni,d)为图采

样函数,s(ni,d)={nj|d

ij

≤d}为采样函数,d

ij

为节点nj与主节点ni之间的步长,d为步长,w()为权值分配函数,p()为节点分组函数;其中主节点是指图卷积核对应的中心节点;所述节点分组函数是指将卷积区域分为主节点、副中心节点和其余相邻节点三组,每个分组共享一个独立的权值,从而形成固定尺寸为3

×

1的图卷积核;所述卷积区域是指距离主节点单位步长的节点所组成的集合。图卷积权值分配函数,简化了图卷积的运算过程,提高了计算效率;节点分组函数可以提高图卷积计算的便捷性。

[0034]

步骤2)的具体实现过程包括:

[0035]

1)对所述空间特征向量进行平均下采样预处理;

[0036]

2)将预处理后的空间特征向量输入到lstm网络,计算各时刻的时间特征;

[0037]

3)利用注意力机制融合各时刻的时间特征,得到输出时空特征向量;

[0038]

4)由输出时空特征向量计算分类概率分布,输出驾驶员驾驶行为。

[0039]

本发明将图卷积网络输出的空间特征向量作为lstm网络的输入,并在lstm末端结合注意力机制,消除了动作峰值时间不确定性,提高了模型的时间特征提取能力。

[0040]

所述lstm网络包括两个相连的lstm层,第一lstm单元与所述图卷积网络输出层连接,第二lstm层与第一lstm层连接;其中,第一lstm层的输入为序列各时刻骨架空间特征v

t

;第二lstm层的输入为第一lstm层的输出h

t

。lstm网络的输入既包含了当前时刻的状态信息,也融入了历史时刻的状态信息由此,从而建立了输入数据在时间维度上的连接关系,可以有效地提取序列的时间特征。

[0041]

为解决动作峰值的时间不确定性,本发明引入了注意力机制,即步骤3)的具体实现过程包括:根据各个时刻状态向量的特性,自适应地为各状态向量分配权值系数,对各个时刻状态向量进行加权求和,所得向量即为时空特征向量y;其中,各状态向量权值系数的集合α=softmax(w

t

m),w为可学习的权值向量,m=tanh(h),h为lstm网络的输出;softmax()为归一化指数函数。

[0042]

预测驾驶员驾驶行为的具体实现过程包括:对所述时空特征向量进行softmax函数运算,得到驾驶员驾驶行为的概率分布,利用argmax函数提取概率值最大的驾驶员驾驶行为,即得到最终预测的驾驶员驾驶行为。

[0043]

相应地,本发明还提供了一种基于循环图卷积网络的驾驶员驾驶行为识别系统,包括计算机设备;所述计算机设备被编程或配置为用于本发明所述方法的步骤。

[0044]

与现有技术相比,本发明所具有的有益效果为:

[0045]

1、本发明构造了依据人体运动学的图卷积网络,提高了模型对于人体骨架节点之间、肢体之间空间特征的提取能力。

[0046]

2、建立了具有特定节点分组机理的图卷积权值分配函数,简化了图卷积的运算过程,提高了计算效率。

[0047]

3、将图网络输出的空间特征向量作为lstm网络的输入,并在lstm末端结合注意力机制,消除了动作峰值时间不确定性,提高了模型的时间特征提取能力。

[0048]

4、整体网络将图卷积网络和lstm网络前后布置,各自运算过程影响较小,网络结构合理,并能有效提取骨架信息时空特征,提高驾驶员驾驶行为识别准确性。

附图说明

[0049]

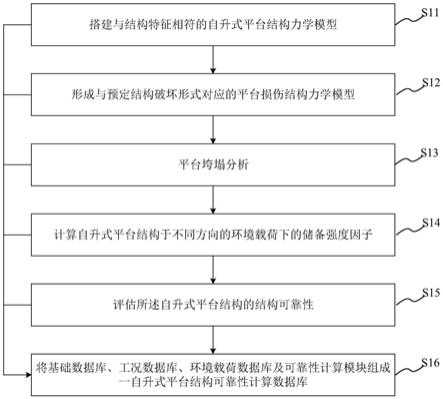

图1为基于人工特征的驾驶员驾驶行为识别方法流程图;

[0050]

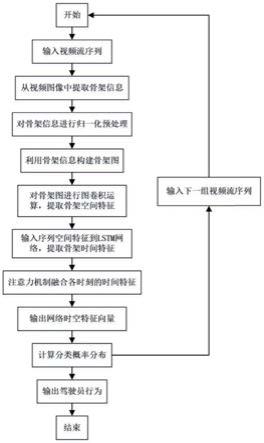

图2为基于传统循环神经网络的驾驶员驾驶行为识别算法流程图;

[0051]

图3为基于循环图卷积网络的驾驶员驾驶行为识别系统架构示意图;

[0052]

图4为考虑人体运动学的图卷积网络构建流程;

[0053]

图5(a)~图5(g)为图像采集和骨架拟合结果;图5(a)左后视镜检查;图5(b)右后视镜检查;图5(c)发短信;图5(d)打电话;图5(e)使用中控台;图5(f)喝水;图5(g)拿东西;

[0054]

图6为含节点分组函数的图权值分配流程图;

[0055]

图7为注意力增强的循环神经网络的构建流程图;

[0056]

图8为注意力增强lstm网络结构图;

[0057]

图9为本发明核心流程示意图;

[0058]

图10为基准模型混淆矩阵;

[0059]

图11为模型1混淆矩阵;

[0060]

图12为模型2混淆矩阵;

[0061]

图13为循环图卷积网络混淆矩阵;

[0062]

图14为模块剥离试验精确率-召回率曲线;

[0063]

图15为现有方法对比实验精确率-召回率曲线。

具体实施方式

[0064]

本发明的系统架构如图3所示。通过车载摄像头获取驾驶行为视频流信息;预训练的cnn网络获取人体骨架像素坐标;图卷积网络利用原始骨架坐标构建人体骨架结构图,并在骨架结构图上进行图卷积,从而获取骨架的空间特征;lstm网络将图卷积网络获取的空间特征作为输入,获取连续帧图像之间的时间特征,并由注意力机制将各时刻的状态向量融合,从而获得最终的时空特征;利用分类器对网络输出的时空特征分类,获得最终的驾驶员驾驶行为类别。

[0065]

图卷积网络构建流程如图4所示,该模块的主要方法步骤如下:

[0066]

1)输入视频流数据

[0067]

本发明视频流数据由单目摄像头获得,其安装位置为车辆右侧a柱,以便完整地获取驾驶员图像。视频流帧率为每秒30帧。设定序列长度为30,可以有效地拍摄到持续时间较短的驾驶员驾驶行为,如查看后视镜等。

[0068]

2)从视频图像中提取骨架信息

[0069]

利用预训练的cnn网络从视频图像中提取驾驶员骨架节点的像素坐标,第i帧图像的骨架信息以a

t

=(x1,y1,

…

,xi,yi,

…

x

12

,y

12

)形式储存,(xi,yi)分别为索引为i的骨架节点的像素横坐标和像素纵坐标。考虑到驾驶员下半身与驾驶员驾驶行为的相关性较小,骨架信息保留了驾驶员上半身12个节点坐标。连续30帧图像的骨架信息将作为一个序列z=(a1,

…

,a

t

,

…

,a

30

)进入网络。视频图像与骨架拟合结果如图5(a)~图5(g)所示。

[0070]

3)对骨架信息进行批次内归一化预处理

[0071]

为了优化批次数据的均值与方差,减少由于数据噪音、卷积操作等引起的数据分布漂移的情况,使数据分布更接近正态分布,更切合实际分布,保证模型训练时的可学习能

力,提高模型的非线性表达能力,本发明在图卷积网络的每一个卷积层之前均进行批归一化处理,即:

[0072][0073]

其中b为批次数据,m为批次中序列的个数,根据计算平台显存大小,本发明中m=128,μb为批次数据的均值,σb为批次数据的方差,为规范化后的数据,ε为微小正数用以防止分母为零,un为尺度、平移变换后的数据,γ尺度变换系数β为平移变换系数,γ和β均为可学习参数,通过网络模型训练获得。

[0074]

4)利用骨架信息构建骨架图

[0075]

图卷积网络中图的概念并非通常的图像,而是指由节点,节点间连接所构成的结构图。预处理后,每一帧图像的节点信息仍以形式储存,为预处理后的像素坐标值。该形式仅将节点信息以一定顺序进行排列,失去了节点之间的连接关系。为了保留节点间的相互作用关系,本发明根据人体骨架构造,将节点信息转化为由节点集合n和连接集合l组成的骨架图g,即:

[0076][0077]

其中l

ij

为节点ni与节点nj的连接关系。

[0078]

5)对骨架图进行图卷积运算,提取骨架空间特征

[0079]

图卷积运算主要分为采样过程和权值分配过程。不同于像素图像存在自左至右、自上而下的像素排列规律,骨架图上的节点处于非欧式空间中,缺乏规律的排列顺序。因此,图卷积操作无法直接运用传统卷积运算,针对图卷积的图采样函数和图权值分配函数均需重新定义。

[0080]

图采样函数构建:对于一个图卷积核,需要采样出卷积区域。本发明图采样函数以步长d作为采样标准,步长d的定义为:骨架图上,采样点与主节点之间最短路径的连接数,例如两点直接相连则步长为1,其中主节点为当前图卷积核所对应的中心节点。本发明将距离主节点单位步长(即与主节点直接相连)的节点所组成的集合作为卷积区域,即:

[0081]

s(ni,d)={nj|d

ij

≤d}

ꢀꢀꢀ

(3)

[0082]

其中d

ij

为节点nj与主节点ni之间的步长,d=1。

[0083]

图权值分配函数构建:由上述图采样函数所得卷积区域中的节点数量是变化的,倘若每个节点分配一个独立的权值,则卷积核的尺寸是变化的,这大大增加了卷积运算的复杂度。为提高图卷积计算的便捷性,我们构造了一种类似传统卷积操作的具有固定尺寸的卷积核。本发明提出一种依据人体运动学的节点分组函数,如图6所示。

[0084]

人体动作需要各肢体协同作用,相互配合运动,各肢体的中心节点之间应具有更为重要的连接关系。根据这一特性,本发明首先为所有节点编号,并将节点0、1、3、6分别定义为头部、躯干、右臂和左臂的肢体中心节点。因而,节点分组函数可将卷积区域节点分为主节点、副中心节点(即四肢中心节点)和其余相邻节点3组,每个分组共享一个独立的权值,从而形成固定尺寸为3

×

1的图卷积核。当卷积区域中节点不足以分为3组时,采取补0策略。节点分组函数p计算公式如下:

[0085][0086]

根据节点分组函数,可得权值分配函数如下:

[0087][0088]

结合上述图采样函数和图权值分配函数,对于主节点ni的图卷积运算可定义为:

[0089][0090]

其中为输出特征,f

in

为输入特征,为节点ni的权值分配函数,如式(5)所示,根据节点分组函数p输出的节点标签,建立图卷积核w中权值与领域节点nj∈s(ni,d)的对应关系。例如图卷积核w为3

×

1的矩阵,即w=[w1,w2,w3],若节点分组函数p(ni,nj)=1,则权值分配函数

[0091]

上式中,令输入特征为节点状态值,即f

in

=n,并遍历骨架图上的所有节点,经多层图卷积运算,便可输出骨架图的空间特征向量其中为节点i的输出特征。

[0092]

注意力增强的循环神经网络整体流程如图7所示。图卷积网络获得的空间特征向量经预处理后,作为lstm网络的输入;lstm通过序列中的状态传递来获取序列骨架信息间的时间特征;注意力机制将lstm网络各记忆单元输入的状态向量融合,获得时空特征;softmax函数计算分类概率分布,得到最终的驾驶员驾驶行为分类。

[0093]

1)输入空间特征并进行平均下采样预处理

[0094]

本发明设定序列长度为30帧,因此将连续30帧图像经模块1输出的空间特征向量(v1,v2,

…

,v

29

,v

30

)作为模块2的输入。为减小计算量,预处理上采取空间特征向量内部的平均下采样,即对于每1帧的空间特征向量v

t

:

[0095]

[0096]

2)将空间特征输入到lstm,计算时间特征

[0097]

本发明构建了两层lstm网络,每层包含64个单元。lstm单元内部的计算过程为:

[0098][0099]

其中σ为sigmoid激活函数,

⊙

为矩阵元素相乘运算,w、b均为可学习参数。

[0100]

lstm单元的输入为当前时刻骨架空间特征v

t

和上一时刻的单元输出h

t-1

,通过为遗忘门f

t

、输入门i

t

、输出门o

t

以及模块参数u

t

分配各自的可学习的变换系数矩阵w、b,单元输出时间特征h

t

,既包含了当前时刻的状态信息,也融入了历史时刻的状态信息,由此,从而建立了输入数据在时间维度上的连接关系,有效地提取序列的时间特征。将各时刻时间特征联立得到lstm网络输出h=(h1,

…

,h

30

)。

[0101]

3)利用注意力机制融合各时刻的时间特征

[0102]

传统lstm网络通常将网络最后一个记忆单元输出的状态向量作为最终的特征向量。这种特征提取方式存在局限性。对于完整的动作序列而言,固定长度的滑动窗口中,驾驶员驾驶行为发生的时刻是不确定的,驾驶员驾驶行为的动作峰值可能位于序列的任意位置。换言之,序列中的每一帧图像所包含的特征信息量是不同的。尽管lstm网络包含了前后时刻的状态传递过程,但是该状态传递作用随着相隔时间的增长而减弱,相隔较远的两个时刻之间的状态相关性已较弱。因此完全将最后时刻的状态向量作为最终的特征向量是不合适的。本发明为解决动作峰值的时间不确定性,引入了注意力机制,其运算过程为:

[0103][0104]

其中h为lstm网络输出,w为可学习的权值向量,α为各时刻状态向量的分配系数集合,y为注意力机制的输出特征向量。

[0105]

注意力增强的lstm网络的整体结构如图8所示。骨架空间特征向量v

t

经lstm网络运算后得到各个时刻的状态向量h

t

,注意力机制根据各个时刻状态向量的特性,自适应地为各状态向量分配权值系数α

t

,将各个时刻状态向量的加权求和可得注意力机制的输出特征向量y,即为最终的时空特征向量。

[0106]

4)由输出特征向量计算分类概率分布,输出驾驶员驾驶行为

[0107]

对输出特征向量y进行softmax函数运算,可得到驾驶员驾驶行为的概率分布。运用argmax函数提取概率值最大的驾驶员驾驶行为即为最终预测的驾驶员驾驶行为,计算过程如下:

[0108]

class=argmax(softmax(y))

ꢀꢀꢀ

(10)

[0109]

本发明的核心流程如图9所示。

[0110]

对比试验

[0111]

本发明建立了驾驶员第二驾驶任务数据集,用于网络模型的训练与评估。设计了模块剥离试验以验证本发明各个模块的有效性。此外,将本发明与其他方法对比以证明本发明的识别准确性。

[0112]

1)驾驶员第二驾驶任务数据集

[0113]

现有公开数据集均为离散的单帧图像数据集,各样本间缺乏时序上的连续性,而本发明所需数据集为视频序列数据集,为验证模型有效性,本发明建立了包含7类驾驶任务的视频数据集。数据集的采集流程分为两个部分,真实驾驶数据采集和模拟驾驶数据采集。真实驾驶数据采集过程中,为保证实验安全性,志愿者驾驶实验车辆在固定道路上行驶,引导员在交通场景相对安全的情况下,向志愿者发出第二驾驶任务指令,志愿者以及指令完成相应的驾驶任务。由于真实驾驶数据中第二驾驶任务样本数量较少,本发明通过模拟第二驾驶任务以增加样本数量。在模拟驾驶任务数据采集过程中,志愿者需依据自身驾驶习惯,在静止的试验车中完成第二驾驶任务,此外,结束第二驾驶任务后需恢复至正常驾驶状态,并保持一分钟,从而使模拟驾驶数据更接近于真实驾驶数据。将所有视频数据根据驾驶员任务类别裁剪为对应的视频片段,最终得到数据集样本分布如表1所示。

[0114]

表1驾驶员驾驶任务数据集样本分布

[0115][0116]

2)模型搭建与训练

[0117]

本发明的模型搭建平台为64位ubuntu16.04系统,采用英特尔i7处理器和英伟达gtx1080显卡。使用了python3.5编程语言和tensorflow深度学习框架编写模型程序,并使用英伟达cuda10和cudnn7深度学习加速器提升模型运算速度。模型共包含9个图卷积层和2个lstm层。网络训练超参数如表2所示。

[0118]

表2模型训练超参数

[0119][0120]

3)模块剥离实验

[0121]

本发明以基础的lstm网络作为基准模型。在基准模型上依次增加图卷积模块和注意力机制模块分别验证本发明各模块有效性。以下记模型1为基准模型增加注意力机制后的模型,模型2为基准模型增加图卷积模块后的模型。首先验证注意力机制模块有效性。图10、图11分别为基准模型和模型1的混淆矩阵,对比可知,模型1的整体准确率为87.6%,而基准模型的整体准确率为85.6%,模型1稍优于基准模型。具体对比每类驾驶任务的精度可知,模型1在长序列动作的识别上有较大提升,如发短信动作,模型1相较基准模型提升16%。其次验证图卷积模块有效性。图12为模型2的混淆矩阵。对比图10和图12可知,模型2的整体准确率达到93.7%,相较基准模型有较大提升。此外模型2的大部分驾驶任务识别精度均高于九成,喝水任务精度相较基准模型提升96%,从而验证了图卷积模块强大的空间特征提取能力。图13为循环图卷积网络的混淆矩阵,其整体准确率达到了最优的95.4%。图14为剥离实验中各模型的精确率-召回率曲线,表3为模块剥离实验中各模型的准确率、召回率及f1分数。可见本发明各模块都在基准模型之上取得不同程度精度提升。

[0122]

表3模块剥离实验

[0123][0124]

4)现有方法对比

[0125]

本发明将与三种现有方法对比,以验证本发明驾驶员驾驶任务识准确性。三种现有方法分别为geometric-lstm网络,st-gcn网络和gmm-alexnet网络。所有方法均在同一数据集下测试,并使用统一的交叉验证方法(留一法)。表4为各方法的测试准确率、召回率及f1分数,本发明的识别准确率,召回率和f1分数均优于现有方法。图15为各方法的精确率召回率曲线,本发明同样取得了最优的分类效果。相较现有方法,本发明融合图卷积模块,注意力机制模块以及lstm网络,从而在骨架结构空间维度和长序列视频的时间维度上都有较好的特征提取能力,因而在驾驶员驾驶任务识别准确性上优于现有方法。

[0126]

表4现有方法对比

[0127]

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。