1.本发明涉及机器学习技术领域,尤其涉及基于统一锚点与子空间学习的谱聚类方法及系统。

背景技术:

2.多视图聚类集成了视图之间的多样性和互补信息进行聚类,是机器学习和多媒体数据挖掘社区中一种重要的无监督学习方法。现有文献中已经提出了许多多视图聚类算法,其中多视图子空间聚类非常流行。多视图子空间聚(mvsc)通常从融合的多视图数据表示中寻求统一的子空间结构,然后将数据在子空间中进行分离,即以下两步策略:i)图构建:从多视图数据中获得低维子空间表示,得到视图特定的相似图或者融合图;ii)谱聚类:对融合图进行谱聚类。通过捕获非线性结构并保留图中的成对相似性,mvsc已广泛应用于各种应用,例如图像分类、面部聚类、社区检测。

3.尽管现有的mvsc方法在提高聚类性能方面取得了巨大成功,但mvsc进一步应用的一个主要缺点是关于样本数的三次时间复杂度,第一个图构建阶段需要解决每次迭代的时间复杂度至少为o(n3)的n凸二次规划子问题。此外,第二个谱聚类过程需要o(n3)进行奇异值分解(svd)。因此,设计可扩展的mvsc算法来处理大规模多视图数据仍然是一个悬而未决的问题。

4.近年来,人们提出了基于锚点的mvsc来缓解传统子空间方法的高复杂性。通过独立采样选择k个锚点,原始的大小为n

×

n的全局图被替换为大小为n

×

k的对应锚图。将各锚图等权重融合到共识图中,然后进行谱聚类得到最终的聚类结果。基于锚点的多视图子空间聚类方法的整个时间复杂度可以减少到o(n),并且可以应用于大规模任务。

5.现有的基于锚点的多视图子空间聚类策略可以通过以下考虑进一步改进。首先,每个视图的锚点是通过k均值聚类或随机采样独立生成的,与其他视图信息没有关联。此外,启发式采样和图构建过程的分离导致弱判别锚点。因此,选定的锚点可能无法反映实际的数据分布并生成不精确的图结构。其次,在没有充分信息融合的情况下,互补的多视图信息没有得到很好的利用,因为图是由相应视图的锚点独立构建的。现有方法的上述两种限制都会降低聚类性能。

技术实现要素:

6.本发明的目的是针对现有技术的缺陷,提供了基于统一锚点与子空间学习的谱聚类方法及系统。

7.为了实现以上目的,本发明采用以下技术方案:

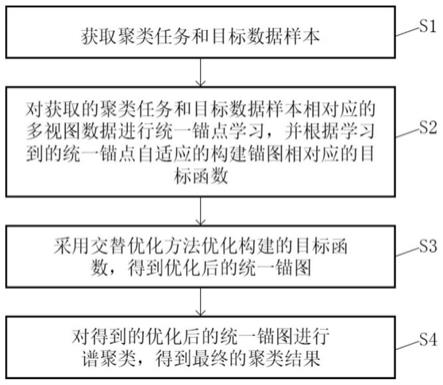

8.基于统一锚点与子空间学习的谱聚类方法,包括:

9.s1.获取聚类任务和目标数据样本;

10.s2.对获取的聚类任务和目标数据样本相对应的多视图数据进行统一锚点学习,并根据学习到的统一锚点自适应的构建锚图相对应的目标函数;

11.s3.采用交替优化方法优化构建的目标函数,得到优化后的统一锚图;

12.s4.对得到的优化后的统一锚图进行谱聚类,得到最终的聚类结果。

13.进一步的,所述步骤s2中根据学习到的统一锚点自适应的构建锚图相对应的目标函数,表示为:

[0014][0015]

s.t.α

t

1=1,w

it

wi=id,a

t

a=im,z≥0,z

t

1=1

[0016]

其中,α表示视图的权重;wi表示第i视图的锚点投影矩阵;a∈rd×m表示统一的锚矩阵,d表示整个视图的公共维度,m表示锚的数量;z表示具有m

×

n维的统一锚图;v表示v个视图;αi表示第i个视图的权重;表示原始数据的第i视图,di表示对应视图的维度,n表示样本数;α

t

表示α的转置;w

it

表示wi的转置;z

t

表示z的转置;a

t

表示a的转置;id∈rd×d表示单位矩阵;im∈rm×m表示单位矩阵;1表示所有元素为一的向量。

[0017]

进一步的,所述步骤s3中采用交替优化方法优化构建的目标函数,具体包括:

[0018]

a1.固定变量a、z、αi,则目标函数中wi的优化表示为:

[0019][0020]

a2.更新a,固定wi、z、αi,则目标函数中a的优化表示为:

[0021][0022]

a3.更新z,固定变量wi、a、αi,则目标函数中z的优化表示为:

[0023][0024]

s.t.z≥0,z

t

1=1

[0025]

a4.更新αi,固定其他变量wi、a、z,则目标函数中αi的优化表示为:

[0026][0027]

其中,mi=||x

i-wiaz||f,表示xi的重构损失。

[0028]

进一步的,所述步骤a1中还包括:

[0029]

通过frobenius范数去除与wi无关的项,将步骤a1中的公式转化为以下等价问题,表示为:

[0030][0031]

其中,bi=xiz

tat

,表示矩阵的乘积。

[0032]

进一步的,所述步骤a2中还包括:

[0033]

通过frobenius范数去除与a无关的项,将步骤a2中的公式转化为以下等价问题,表示为:

[0034][0035]

其中,表示矩阵的乘积。

[0036]

进一步的,所述步骤a3中还包括:

[0037]

对z的每一行解通过qp问题解决,则将步骤a3中的公式表示为:

[0038][0039][0040]

其中,j表示矩阵中的每列元素。

[0041]

进一步的,所述步骤s3中采用交替优化方法优化构建的目标函数,其中终止条件为找到最小值或达到收敛条件。

[0042]

相应的,基于统一锚点与子空间学习的谱聚类系统,包括:

[0043]

获取模块,用于获取聚类任务和目标数据样本;

[0044]

构建模块,用于对获取的聚类任务和目标数据样本相对应的多视图数据进行统一锚点学习,并根据学习到的统一锚点自适应的构建锚图相对应的目标函数;

[0045]

优化模块,用于采用交替优化方法优化构建的目标函数,得到优化后的统一锚图;

[0046]

聚类模块,用于对得到的优化后的统一锚图进行谱聚类,得到最终的聚类结果。

[0047]

进一步的,所述构建模块中根据学习到的统一锚点自适应的构建锚图相对应的目标函数,表示为:

[0048][0049]

s.t.α

t

1=1,w

it

wi=id,a

t

a=im,z≥0,z

t

1=1

[0050]

其中,α表示视图的权重;wi表示第i视图的锚点投影矩阵;a∈rd×m表示统一的锚矩阵,d表示整个视图的公共维度,m表示锚的数量;z表示具有m

×

n维的统一锚图;v表示v个视图;αi表示第i个视图的权重;表示原始数据的第i视图,di表示对应视图的维度,n表示样本数;α

t

表示α的转置;w

it

表示wi的转置;z

t

表示z的转置;a

t

表示a的转置;id∈rd×d表示单位矩阵;im∈rm×m表示单位矩阵;1表示所有元素为一的向量。

[0051]

进一步的,所述优化模块中采用交替优化方法优化构建的目标函数,具体包括:

[0052]

固定变量a、z、αi,则目标函数中wi的优化表示为:

[0053][0054]

更新a,固定wi、z、αi,则目标函数中a的优化表示为:

[0055][0056]

更新z,固定变量wi、a、αi,则目标函数中z的优化表示为:

[0057][0058]

s.t.z≥0,z

t

1=1

[0059]

更新αi,固定其他变量wi、a、z,则目标函数中αi的优化表示为:

[0060][0061]

其中,mi=||x

i-wiaz||f,表示xi的重构损失。

[0062]

与现有技术相比,本发明提出了一种新颖的具有统一锚点与子空间学习的谱聚类方法,该方法将锚点学习和图的构建整合到一个统一的框架,使学习到的锚点可以更准确的代表实际数据分布,与现有的锚点图融合策略相比,利用自适应的方法使一致锚图捕获/获得视图间的互补信息,同时学习不同视图的重要性。大量的实验结果证明了我们的聚类性能和运行时间的优越性。

附图说明

[0063]

图1是实施例一提供的基于统一锚点与子空间学习的谱聚类方法流程图;

[0064]

图2是实施例一提供的传统的基于锚点的多视图子空间策略框架和本文的smvsc策略示意图;

[0065]

图3是实施例二提供的比较方法和超过七个数据集的运行时间示意图;

[0066]

图4是实施例二提供的lmvsc和本算法在caltech101-20上的图结构比较示意图;

[0067]

图5是实施例二提供的本方法在五个基准数据集上的目标示意图。

具体实施方式

[0068]

以下通过特定的具体实例说明本发明的实施方式,本领域技术人员可由本说明书所揭露的内容轻易地了解本发明的其他优点与功效。本发明还可以通过另外不同的具体实施方式加以实施或应用,本说明书中的各项细节也可以基于不同观点与应用,在没有背离本发明的精神下进行各种修饰或改变。需说明的是,在不冲突的情况下,以下实施例及实施例中的特征可以相互组合。

[0069]

本发明的目的是为了将锚点学习和图构建结合到统一的框架中,使学习到的一致锚点可以与各视图的投影矩阵联合优化。因此,学习的锚点可以准确地表示具体的潜在数据,从而形成更好的图结构/更好的构建图结构。部视图的恢复也由单一视图对统一图的具体细节产生影响,本发明提供了基于统一锚点与子空间学习的谱聚类方法及系统。

[0070]

将锚学习和图构建结合到一个统一的框架中,其中使一致锚点与各自的视图排列矩阵联合优化。因此,学习的锚点可以准确地表示实际的潜在数据分布,从而更好地构建图结构。每个视图的重要性也由单个视图对统一图的贡献自适应地衡量。最重要的是,本发明提出的算法的线性时间复杂度使其能够应用于大规模多视图数据。然后,提出了一种具有证明收敛性的四步替代优化算法来解决由此产生的优化问题。

[0071]

实施例一

[0072]

本实施例提供基于统一锚点与子空间学习的谱聚类方法,如图1所示,包括:

[0073]

s1.获取聚类任务和目标数据样本;

[0074]

s2.对获取的聚类任务和目标数据样本相对应的多视图数据进行统一锚点学习,并根据学习到的统一锚点自适应的构建锚图相对应的目标函数;

[0075]

s3.采用交替优化方法优化构建的目标函数,得到优化后的统一锚图;

[0076]

s4.对得到的优化后的统一锚图进行谱聚类,得到最终的聚类结果。

[0077]

评估多视图子空间聚类的性能关键在于算法中构建图的质量。在传统的基于锚点的多视图子空间聚类框架中,主要包括三个阶段:第一阶段,先启发式地选择锚点,然后通过从每个视图中的原始数据中采样来选取固定的锚点。在第二阶段,每个视图选取的锚点互相独立并分别进行锚点图的构建,各视图之间没有信息交换。第三阶段,各视图构成的特定锚图直接等量连接成一个统一的锚图,之后通过锚图进行谱聚类得到最终的聚类结果。这三个阶段相互独立,视图之间没有交互作用。与传统策略不同,本实施例提出基于一致锚点的可扩展多视图子空间聚类算法,该算法主要包括两个阶段:锚点学习和图的构建。第一阶段,本实施例针对大规模的多视图数据进行锚点学习,使学习到的锚点更能准确的代表实际数据的分布。第二阶段,考虑到各视图的重要性有所不同,本实施例通过学习到的一致锚点自适应的构建锚图,之后通过一致锚图进行谱聚类得到最终的聚类结果。这两个阶段相互促进且共同优化,使构建的一致锚图不仅具有视图间的互补信息,也具有更强的判别性图结构。该算法打破了传统方法的局限性,有效提高聚类性能。

[0078]

在步骤s2中,对获取的聚类任务和目标数据样本相对应的多视图数据进行统一锚点学习,并根据学习到的统一锚点自适应的构建锚图相对应的目标函数。

[0079]

利用所有原始点来表示自表达策略中的每个点,广泛用于多视图子空间聚类。尽管对全局关系进行了很好的探索,但与全局图相关的优化时间和存储成本限制了多视图子空间聚类的可扩展性。此外,用所有样本描绘一个点是不必要和多余的。因此,本实施例采用锚点策略选择一小组数据点称为锚点重建底层子空间并捕获流形结构。在现有文献中,锚点的选择可以通过从原始数据空间中随机抽样或均匀抽样,或者利用执行k-means得到的聚类中心来获得。然而,在之前的策略中,锚点在初始化后就固定了,使得锚点学习(anchor learning,al)与图构建彼此分离。本实施例将这两个过程集成到一个通用框架中,从而产生更具辨别力的锚点。

[0080]

此外,从独立视图生成锚点会导致不同的锚点集,使图融合变得困难。视图之间的补充信息还没有得到很好的探索。

[0081]

针对这些问题,本实施例经投影得到的统一锚点,通过自适应的学习得到具有互补视图信息和更具判别性锚点结构的统一锚图。在数学上,将本实施例的统一锚图相对应的目标函数,表示为:

[0082][0083]

s.t.α

t

1=1,w

it

wi=id,a

t

a=im,z≥0,z

t

1=1

[0084]

其中,α表示视图的权重;wi表示第i视图的锚点投影矩阵,可以将统一的锚点投影到对应的原始数据空间;a∈rd×m表示统一的锚矩阵,d表示整个视图的公共维度,m表示锚的数量,在本实施例中,选择k作为公共维度,并选择锚点数m∈{k,2k,3k},公共维度与正交约束一起将a限制为更具辨别力;z表示具有m

×

n维的统一锚图;v表示v个视图;αi表示第i个

视图的权重;表示原始数据的第i视图,di表示对应视图的维度,n表示样本数;α

t

表示α的转置;w

it

表示wi的转置;z

t

表示z的转置;a

t

表示a的转置;id∈rd×d表示单位矩阵;im∈rm×m表示单位矩阵;1表示所有元素为一的向量。

[0085]

根据现有文献[gao q,xia w,wan z,et al.2020.tensor-svd based graph learning for multi-view subspace clustering.in aaai 3930-3937]、[yong h,meng d,j li,et al.2018.model inconsistent but correlated noise:multi-view subspace learning with regularized mixture of gaussians]、[cai d,chen x.2015.large scale spectral clustering via landmark-based sparse representation.in ieee trans cybern,45(8):1669-1680]的结论,锚图z的左奇异向量等于完整图s=z

t

z的左奇异向量。因此,本实施例通过对z进行svd得到左奇异向量u,并对u执行k-means得到最终的聚类结果。

[0086]

在步骤s3中,采用交替优化方法优化构建的目标函数,得到优化后的统一锚图。

[0087]

当同时考虑所有变量时,目标函数中的优化问题不是联合凸的。因此,本实施例提出了一种交替优化算法来优化每个变量,即优化其中一个变量,固定其他变量。之后,本实施例提供了优化算法和时间/空间复杂度分析的总体框架。

[0088]

a1.固定变量a、z、αi,则目标函数中wi的优化表示为:

[0089][0090]

如图2所示为传统的基于锚点的多视图子空间策略框架和本实施例的smvsc策略图对比图。

[0091]

由于每个wi在对应的视图方面彼此分离,因此可以通过frobenius范数去除与wi无关的项,作为上述公式转化为以下等价问题,表示为:

[0092][0093]

其中,bi=xiz

tat

,表示矩阵的乘积。假设bi的奇异值分解(svd)结果是u∑v

t

,根据现有技术中的方法计算uv

t

可以很容易地得到最优的wi。

[0094]

a2.更新a,固定wi、z、αi,则目标函数中a的优化可以转化为解决一下问题,表示为:

[0095][0096]

类似步骤a1中wi的优化,对a进行优化,具体为通过frobenius范数去除与a无关的项,将上述公式优化等于以下形式,表示为:

[0097][0098]

其中,表示矩阵的乘积。更新变量a的最优解可以得到c的左奇异矩阵与右奇异矩阵的相乘。

[0099]

a3.更新z,固定变量wi、a、αi,更新变量z的优化问题可以改写为:

[0100][0101]

s.t.z≥0,z

t

1=1

[0102]

z的上述优化问题可以很容易地表述为以下二次规划(qp)问题,优化可以通过对z的每一行解通过qp问题解决,则表示为:

[0103][0104][0105]

其中,j表示矩阵中的每列元素。

[0106]

a4.更新αi,固定其他变量wi、a、z,可以得到更新αi的优化问题,其中令mi=||x

i-wiaz||f,表示为:

[0107][0108]

根据cauchy-buniakowskyschwarz不等式,最优的αi可以直接得到。

[0109]

随着迭代的进行,上述优化中的四个变量单独求解,其他变量固定。由于每个子问题都是严格凸的,目标值会单调递减,直到找到最小值或达到收敛条件。并且可以很容易地证明目标函数的下界为零。上述优化的整个过程在下表1的算法中列出。

[0110][0111]

表1

[0112]

对上述优化过程进行复杂性分析,具体为:首先将分析总体优化过程中的时间复杂性,然后从主要空间复杂度的角度对比了几种对比方法。

[0113]

时间复杂度的分析:

[0114]

计算复杂度由每个变量的优化成本组成。在更新wi时,在bi上执行svd需要花费o(did2),并且o(didk2)是执行矩阵乘法来得到最优wi的时间消耗。类似于更新wi,更新a的需要o(md2)和o(dmk2)的时间复杂度,来进行svd分解和矩阵乘法。当解决更新z的qp问题时,计

算所有列的成本是o(nm3)。计算αi的时间成本仅为o(1)。因此,优化过程总的时间开销为因此,本实施例提出的优化算法的计算复杂度是线性复杂度o(n)。

[0115]

经过优化后,本实施例对z进行了svd分解,得到了其左奇异矩阵u,并通过k均值得到了最终的聚类结果。在后处理过程中,计算复杂度是o(nm2),这也是一个线性复杂度。因此,在优化过程和后处理过程中都实现了一个线性时间算法。

[0116]

空间复杂度的分析:

[0117]

在本事实例中,主要内存代价是矩阵:a∈rk×m和z∈rm×n。因此,本实施例的smvsc的空间复杂性mn (h m)k,在这里因此,smvsc的空间复杂度是o(n)。

[0118]

本实施例的目的为:

[0119]

(1)与传统的启发式锚点抽样策略不同,将锚点学习和图的构建整合到一个统一的框架。这两个过程彼此促进并共同优化,使学习到的锚点可以更准确的代表实际数据分布。因此,得到的子空间图结构具有更强的判别性,进一步提高了聚类性能

[0120]

(2)与现有的锚点图融合策略相比,通过自适应的方法使一致锚图获得视图间的互补信息,同时学习不同视图的重要性。更重要的是,我们提出的线性时间复杂度的方法被证明是更有效的大规模子空间聚类问题。

[0121]

(3)设计了一个交替优化算法,以解决结果优化问题,并证明了收敛性。大量的实验结果证明了我们的聚类性能和运行时间的优越性。此外,据我们所知,与传统的基于多视图子空间的聚类方法相比,我们是第一个在超过10万个样本上高效运行mvsc的。

[0122]

本实施例提出了一种新颖的具有统一锚点的可扩展多视图子空间聚类方法,该方法将锚点学习和图的构建整合到一个统一的框架,使学习到的锚点可以更准确的代表实际数据分布,与现有的锚点图融合策略相比,利用自适应的方法使一致锚图捕获/获得视图间的互补信息,同时学习不同视图的重要性。

[0123]

实施例二

[0124]

本实施例提供的基于统一锚点与子空间学习的谱聚类方法与实施例一的不同之处在于:

[0125]

本实施例以图像数据集为例进行说明。

[0126]

s1.获取与图像数据相关的聚类任务和目标数据样本;

[0127]

s2.对获取的聚类任务和目标数据样本相对应的多视图数据进行统一锚点学习,并根据学习到的统一锚点自适应的构建锚图相对应的目标函数;

[0128]

s3.采用交替优化方法优化构建的目标函数,得到优化后的统一锚图;

[0129]

s4.对得到的优化后的统一锚图进行谱聚类,得到最终的聚类结果。

[0130]

图像数据可以为面部视频图像数据集、自然灾害图像数据集、遥感图像数据集、医学图像数据集、人群图像数据集、人群计数数据集等等。

[0131]

本实施例在七个广泛使用的数据集上评估了该方法的聚类性质。

[0132]

将smvsc的性能与六种最先进的多视图子空间聚类方法和两种面向大规模的方法

进行比较。

[0133]

methodmemory costtime complexitymax reportedrmkm(n h)ko(n)30475mvsc2vn2 nko(n3)1230amglvn2 nko(n3)12613mlrssc(v 1)n2o(n3)2000fmrn2 nmo(n3)10158pmsc2vn2 (v 1)nko(n3)2386mlesn2 hm mno(n3)544lmvscvm(n h)o(n3)30000oursmn (h m)ko(n)101499

[0134]

表2 比较方法的复杂性分析

[0135]

对于时间和空间复杂度的分析中,如表2所示,大多数基于子空间的多视图聚类方法在上述过程中具有o(n3)时间复杂度。在表2中计算了所比较算法的主要内存成本。很容易观察到,大多数最先进的算法的空间复杂度是o(n2),如mvsc、amgl、mlrssc、fmr等。lmvsc方法也执行o(n)空间复杂度,但它们必须为每个视图构造一个图,这将比本实施例的统一空间占用更高。高时间和空间的复杂性限制了许多多视图子空间聚类的规模,使它们只适用于相对较小的数据集。在表2中显示了报告中的最大的数据集上的算法比较,它在一定程度上反映了提出算法的效率。

[0136]

本实施例使用的基准数据集见表3,caltech101-all和nuswideobj都是对象图像数据集。ccv是一个丰富的youtube视频数据库,包含20个语义类别。sunrgbd数据集被密集地注释了出来。具有属性的动物数据集被称为awa。youtubeface是一个从youtube上获得的面部视频数据库。

[0137][0138][0139]

表3 基准数据集的信息

[0140]

将算法进行对比:

[0141]

应用在大数据集上的多视图k-means聚类算法(rmkm)。这项工作是一种鲁棒的大规模多视图聚类方法,它集成了大规模数据的异构表示。

[0142]

多视图子空间聚类算法(mvsc)。提出了一种有效的多视图子空间聚类方法,并验证了该算法的有效性。

[0143]

无参数自动加权多图学习:一个多视图聚类和半建议分类的聚类算法(amgl)的框架。提出了一个框架,自动学习每个图的最优权值,并获得全局最优结果。

[0144]

低秩稀疏多视图子空间聚类算法(mlrssc)。该工作通过构造所有视图之间共享的亲和矩阵来学习子空间表示,并解决了相关的低秩和稀疏约束优化问题。

[0145]

针对子空间聚类(fmr)的灵活的多视图表示学习。这项工作灵活地编码不同视图编码互补信息,从而避免使用部分信息进行数据重建。

[0146]

基于分区级别的多视图子空间群集的聚类算法(pmsc)。提出了一个统一的多视图子空间聚类模型,并验证了该算法的有效性。

[0147]

基于潜在嵌入空间的多视图聚类算法(mles)中的多视图聚类。该算法可以同时学习全局结构和聚类指标矩阵,然后在潜在的嵌入空间中聚类多视图数据。

[0148]

具有线性时间复杂度的大规模多视图子空间聚类(lmvsc)。该算法被设计用于处理大规模的数据,并具有线性复杂度。

[0149]

实验设置:

[0150]

在实验设置中,w、a和z的初始化被设置为零矩阵。遵循底层子空间所需的点数不应小于子空间数的原则,选择了{k、2k、3k}和公共维数d=k范围内的锚点m的数量。为了进行公平的比较,从他们的原始网站上下载了比较算法的相关代码。由于所有的方法都需要利用k均值方法来得到最终的聚类结果,运行了50次k均值方法来消除所有比较方法中的随机性。然后通过广泛使用的度量精度(acc)、标准化互信息(nmi)、纯度(purity)和fscore来评估聚类性能。此外,实验环境是intel core i7-7820x cpu和64gb内存、matlab 2020b(64位)的台式计算机上实现的。

[0151]

聚类性能:

[0152]

本实施例在7个广泛使用的多视图基准数据集上将本实施例提出的算法smvsc与8个多视图子空间聚类算法进行了比较。表4和表5显示了详细的聚类性能结果,在这些表中将最佳结果标记为粗体,次优结果标记为斜体,

“‑”

意味着内存不足失败。

[0153]

在样本大小为10,000及以下的数据集上的聚类性能:

[0154]

如表4所示,选择了具有不同样本量的caltech101-20,ccv,caltech101-all和sungrbd数据集。

[0155]

在acc方面,本实施例的算法优于其他最先进的多视图聚类算法。smvsc在四个数据集上分别超过具有同样具有线性复杂度的聚类算法(lmvsc)18%、2%、7%和1%。rmkm是一种解决大规模聚类问题的多视图的k均值聚类算法,然而smvsc分别比rmkm高出27%、11%、19%和1%。在nmi、纯度和fscore中,smvsc可以与其他算法接近等同,甚至表现出更好的性能。此外,由于某些算法的内存不足,表4中没有相关的结果。例如,从图3中可以看出这两种最新的算法:mles和pmsc,在样本大小为2000的数据集上每组参数都要耗费数以万计的时间,之后就出现了内存不足的错误。因此,没有继续进行这些算法的实验。

[0156]

在图3中,比较方法和超过七个数据集的运行时间。为了清晰起见,y轴通过取对数进行缩放,以减轻一些方法和我们的方法之间的差距。缺失的条表明,该方法在这个数据集下在实验平台上遇到了内存不足的错误。

[0157]

需要说明的是,图3中每个数据集中对应的柱状体从左到右依次是rmkm、mvsc、amgl、mlrssc、fmr、pmsc、mles、lmcsc、ours,但是从图3中可以看到只有第一个数据集中有9

个柱状图,但是其余数据集中会有空的位置,空的位置也是代表一个算法,那么其余数据集中的柱状图依然是按照上述顺序排列。

[0158]

此外,在图4中绘制了完整的图来说明本实施例与图中的lmvsc相比更好学习的聚类结构。图4为lmvsc和本实施例算法在caltech101-20上的图结构比较。更亮的颜色意味着一个更大的值。与lmvsc图相比,本实施例的图显示出更清晰的聚类结构,噪声更小。

[0159]

[0160][0161]

表4

[0162]

由于lmvsc中每个视图的锚图是独立学习的,将它们连接起来形成一个vm

×

n锚点图然后由构造一个完整图。完整图可以通过统一锚图z

t

z直接得到。如图4所示,本实施例的图显示了更清晰的块结构,而lmvsc中的图似乎更嘈杂,也不那么清晰。

[0163]

在样本大小超过30,000的数据集上的聚类性能:

[0164]

为了更好地应用于大规模场景,选择了样本大小为30,000或更多的nuswideobj、awa和youtubeface。

[0165]

在实验过程中,除解决大规模数据的算法外,所有的多视图子空间聚类算法都直接存在“内存不足”的问题。因此,对于表5中的上述数据集,这些算法没有聚类性能。

[0166]

基于表5中的实验结果,提出的smvsc在这些较大的数据集上仍然保持着良好的聚类性能。在youtubeface的10万样本数据集上,smksc在acc、nmi、纯度和fscore上分别比lmvsc提升了11%、10%、5%和4%。这些结果表明,本实施例的算法在处理大规模数据时具有较低的空间复杂度,并在稳定性和精度方面优于类似的算法。

[0167]

表5中三万多个样本数据集下比较方法的聚类性能。其他竞争对手都内存了。

’–’

表示出现内存不足的故障。最好的结果是粗体,斜体表示第二或没有统计学差异。

[0168]

[0169][0170]

表5

[0171]

运行时间:

[0172]

为了进行公平的比较,统一地设置了所有的算法来执行k均值50次,并报告了最优参数集的运行时间。图3中显示了所有数据集上运行时间的分布。一些算法在一些数据集上没有实验结果,因此,本图中没有相应的直方图。可以看到smvsc的运行时间非常有优势,并且更多关于运行时间以及加速的细节记录在表6和表7中。

[0173]

从表6和表7中可以看到,smvsc的速度明显优于其他算法,并且几乎是有一些算法的两倍。关于amgl和mlrssc,尽管它们对于有10,000个样本及以下的数据集工作良好,但它们消耗了太多的时间成本。更重要的是,这两种算法的聚类相比之下性能并不令人满意。在较大的数据集上,smvsc和面向大规模的多视图子空间聚类算法(lmvsc)的聚类性能更令人印象深刻,尽管两者都有线性复杂度。虽然lmvsc在大多数数据集中是最快的,但使用的均值采样策略和等权重组合不利于各个视图交换互补信息。

[0174]

这些结果证明了smvsc的线性时间复杂度更容易扩展到大规模数据中,而一些多视图子空间聚类算法在处理大规模数据时需要很长时间。

[0175]

[0176][0177]

表6

[0178][0179]

表7

[0180]

收敛性:

[0181]

如本方法部分所述,本实施例的算法可以从理论上保证收敛到一个局部最优值。在每个数据集上记录,以显示本实施例的实验收敛性。由于空间的限制,只在五个数据集caltech101-20,caltech101-all,sunrgbd,nuswideobj和awa上绘制目标值的演化。如图5所示。目标值在每次迭代中单调递减,通常收敛于小于20次迭代,大多数数据集可以收敛于小于10次迭代。这些结果通过实验验证了该算法的收敛性。

[0182]

本实施例提出了一种具有统一锚点的可扩展的多视图子空间聚类算法来解决大规模数据的聚类问题。该算法自适应地学习每个视图的权重,并将锚点学习和图的构造结合到一个统一的优化框架中。这使得学习到的锚点能够更准确地表示实际的底层数据分

布,并获得一个更有判别性的聚类结构。smvsc具有的线性复杂度,其快速的运行时间使smvsc更适合现实的大规模应用程序场景。与最先进的多视图子空间聚类方法和面向大规模任务的多视图子空间聚类方法相比,大量的实验证明了smvsc具有线性时间复杂度的同时,也保持了等同甚至更好的聚类性能。

[0183]

实施例三

[0184]

本实施例提供了基于统一锚点与子空间学习的谱聚类系统,包括:

[0185]

获取模块,用于获取聚类任务和目标数据样本;

[0186]

构建模块,用于对获取的聚类任务和目标数据样本相对应的多视图数据进行统一锚点学习,并根据学习到的统一锚点自适应的构建锚图相对应的目标函数;

[0187]

优化模块,用于采用交替优化方法优化构建的目标函数,得到优化后的统一锚图;

[0188]

聚类模块,用于对得到的优化后的统一锚图进行谱聚类,得到最终的聚类结果。

[0189]

进一步的,所述构建模块中根据学习到的统一锚点自适应的构建锚图相对应的目标函数,表示为:

[0190][0191]

s.t.α

t

1=1,w

it

wi=id,a

t

a=im,z≥0,z

t

1=1

[0192]

其中,α表示视图的权重;wi表示第i视图的锚点投影矩阵;a∈rd×m表示统一的锚矩阵,d表示整个视图的公共维度,m表示锚的数量;z表示具有m

×

n维的统一锚图;v表示v个视图;αi表示第i个视图的权重;表示原始数据的第i视图,di表示对应视图的维度,n表示样本数;α

t

表示α的转置;w

it

表示wi的转置;z

t

表示z的转置;a

t

表示a的转置;id∈rd×d表示单位矩阵;im∈rm×m表示单位矩阵;1表示所有元素为一的向量。

[0193]

进一步的,所述优化模块中采用交替优化方法优化构建的目标函数,具体包括:

[0194]

固定变量a、z、αi,则目标函数中wi的优化表示为:

[0195][0196]

更新a,固定wi、z、αi,则目标函数中a的优化表示为:

[0197][0198]

更新z,固定变量wi、a、αi,则目标函数中z的优化表示为:

[0199][0200]

s.t.z≥0,z

t

1=1

[0201]

更新αi,固定其他变量wi、a、z,其中令mi=||x

i-wiaz||f,则目标函数中αi的优化表示为:

[0202][0203]

需要说明的是,本实施例提供的基于统一锚点与子空间学习的谱聚类系统与实施

例一类似,在此不多作赘述。

[0204]

本实施例将锚点学习和图的构建整合到一个统一的框架,使学习到的锚点可以更准确的代表实际数据分布,与现有的锚点图融合策略相比,利用自适应的方法使一致锚图捕获/获得视图间的互补信息,同时学习不同视图的重要性。

[0205]

注意,上述仅为本发明的较佳实施例及所运用技术原理。本领域技术人员会理解,本发明不限于这里所述的特定实施例,对本领域技术人员来说能够进行各种明显的变化、重新调整和替代而不会脱离本发明的保护范围。因此,虽然通过以上实施例对本发明进行了较为详细的说明,但是本发明不仅仅限于以上实施例,在不脱离本发明构思的情况下,还可以包括更多其他等效实施例,而本发明的范围由所附的权利要求范围决定。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。