1.本发明涉及智能交通信号控制技术领域,尤其是一种结合状态预测的深度强化学习交通信号控制方法。

背景技术:

2.随着生活水平的提高,汽车保有量持续增长,城市的交通拥堵问题也日趋严重。交通信号控制是提高道路通行效率、缓解交通拥堵最直接、成本最低的途径,传统的信控方法主要包括固定配时控制、感应控制和自适应控制等。scats(sydney coordinated adaptive traffic system)和scoot(split cycle offset optimizing technique)是目前广泛使用的自适应交通信控系统,它们利用简化的交通模型求解最优的信号控制策略;但是简化模型的建立依赖大量的假设和经验方程,在复杂多变的真实交通场景下,这类系统难以达到最佳效果。近年来,随着人工智能技术的发展,深度强化学习(deep reinforcement learning,drl)在交通信号控制方面展现出卓越的应用前景。

3.drl结合了dl的强感知能力与rl的强决策能力,是一种“试错”的学习方法,通过与环境交互来学习最优策略。应用在交通信号控制中,可以把一个或几个交叉口看成一个agent,agent观测路网状态后做出决策,通过最大化环境反馈的奖励以学习最优的信号配时方案。zheng等(zheng g,xiong y,zang x,et al.learning phase competition for traffic signal control[c]//proceedings of the 28th acm international conference on information and knowledge management.2019:1963-1972.)提出frap模型,利用不同信号相位间的竞争关系,实现了在交通流中翻转和旋转等对称情况下的普适性。tan等(tan t,bao f,deng y,et al.cooperative deep reinforcement learning for large-scale traffic grid signal control[j].ieee transactions on cybernetics,2019,50(6):2687-2700.)将大规模路网分为若干个子区域,对每个区域,使用peraction dqn或wolpertinger ddpg进行控制,将所有agent的学习策略传递给全局agent实现全局学习。这些drl信控方法本质上依赖于一阶马尔可夫决策过程,仅使用当前的交通状态进行决策。但是,对于实际场景中复杂多变的交通流,只有综合当前、历史和未来状态才可能获得最优控制策略。

[0004]

现实交通流数据具有突变性、实时性、周期性等特征,是典型的时序数据,目前基于drl的信号控制方法都只是利用当前的交通状态做决策,控制效果有限。

技术实现要素:

[0005]

本发明所要解决的技术问题在于,提供一种结合状态预测的深度强化学习交通信号控制方法,能够缩短车辆的等待时间,提高路网的通行效率。

[0006]

为解决上述技术问题,本发明提供一种结合状态预测的深度强化学习交通信号控制方法,包括如下步骤:

[0007]

(1)路网环境、车流数据建模;用sumo对路网进行建模,包括单路口以及多路口,根

据现实交通场景的情形模拟车辆的生成;

[0008]

(2)深度强化学习算法选择与三要素设计;选择drl智能体控制交通信号,采用dtse的方式精心设计状态,包含路网中多种交通信息,并根据实际情况设计动作与奖励;

[0009]

(3)预测未来的交通状态;使用动态分配、卡尔曼滤波或神经网络方法对步骤(2)中设计的状态进行预测,预测状态将与当前状态一起输入drl智能体进行最优决策;

[0010]

(4)训练模型;选择合适的优化器以及设置超参数,利用sumo生成的车流数据对步骤(2)中的drl智能体以及步骤(3)中的预测模型进行训练,训练完后保存最后的模型;

[0011]

(5)实验测试;用同一分布生成的车流数据对发明的控制方法进行测试评估,定义评价指标,并与其他控制方法进行比较。

[0012]

优选的,步骤(1)中,用sumo仿真软件对路口进行建模,每个路口都是双向六车道,车流数据包括仿真时长、车辆生成方式、车辆数目以及行驶轨迹,车辆的生成服从韦伯分布,设置三种车辆密度,分别对应低、中、高三种流量条件,每辆车以一定的概率直行或是转弯。

[0013]

优选的,步骤(2)中,drl模型采用d3qn,使用经验回放来更新目标q值,使用双网络减轻过度估计,缓解模型的过拟合问题,将q网络分为价值函数与优势函数两部分,对网络结构进行优化;drl智能体状态设计如下:首先按一定距离比例将车道分为若干元胞,计算每个元胞中车辆的数目、平均速度和平均加速度,作为数目向量、速度向量和加速度向量,这三个向量构成环境的状态向量;动作定义为选择一个可能的绿灯相位,包含4种选择,为南北方向直行和右转绿灯、南北方向左转绿灯、东西方向直行和右转绿灯、东西方向左转绿灯,每个绿灯相位设置最小持续时间与最大持续时间,绿灯和红灯切换期间会执行一定时长的黄灯;奖励定义为动作执行期间队列长度、等待时间、车辆延误、通过路口的车辆数目以及通过路口车辆的通行时间的加权和。

[0014]

优选的,步骤(3)中,使用长短期记忆网络预测未来的微观状态,即对步骤(2)中定义的每个元胞中车辆的数目、平均速度和平均加速度进行预测,预测步数由神经网络学习得到。

[0015]

优选的,步骤(4)中,drl相关超参数包括训练回合数、经验池最小尺寸、最大尺寸、折扣因子;深度q网络为全连接神经网络,均方误差作为损失函数,选用adam优化器,相关超参数包括深度、宽度、学习率、批处理大小、训练迭代次数;lstm预测网络采用二值交叉熵作为损失函数,选用adam优化器,相关超参数包括单元数、层数、神经元个数、批处理大小、训练迭代次数。

[0016]

优选的,步骤(5)中,评价指标包括平均等待时间、平均队列长度、平均行驶时间、平均co排放、平均co2排放,对比算法选用韦伯斯特固定配时控制、车辆驱动控制、不加预测的d3qn控制,可以说明发明的信控方法在提高路网通行效率,降低污染排放方面的有效性与可行性。

[0017]

本发明的有益效果为:(1)引入显示的交通状态预测,采用lstm网络预测未来的微观状态,d3qn智能体使用当前和预测状态进行最优决策,可以充分利用交通数据的时序相关性,提高路网的通行效率;(2)精心设计智能体的状态,采用dtse的方法将车道划分为元胞,计算元胞中的车辆数目、平均速度和平均加速度,在减少数据量的同时保留了重要的交通信息,易于预测;(3)使用marl实现路网的交通信号控制,采用状态信息交互和空间折扣

因子来实现多智能体协作,车流数据模拟了现实中高低峰的情形,具有工程应用价值。

附图说明

[0018]

图1为本发明的信号控制方法网络结构示意图。

[0019]

图2为本发明的以十字路口西向车道为例的状态设计示意图。

[0020]

图3为本发明的经验回放流程示意图。

具体实施方式

[0021]

如图1所示,一种结合状态预测的深度强化学习交通信号控制方法,包括如下步骤:

[0022]

步骤1:用sumo建模产生路口模型,路口为双向6车道,车道长500m,沿着车辆的行驶方向,左边车道为左转车道,中间车道为直行车道,右边车道为直行加右转车道。车流数据包括车辆生成方式、仿真时长、车辆数目和行驶轨迹。本发明中车辆的生成服从韦伯分布,可以模拟现实生活中交通高低峰的情形,具有工程应用价值,其概率密度函数为:

[0023][0024]

其中λ是比例参数设为1,a是形状参数设为2。仿真一个回合的时长为2小时,车辆数目设为1000、2000、3000,分别对应低、中、高三种流量条件。车辆长度为5m,最大速度为25m/s,最大加速度为2m/s2,最大减速度为5m/s2,车辆之间的最小间距为2.5m,车辆行驶时以70%的概率直行,15%的概率左转,15%的概率右转。

[0025]

步骤2:本发明中drl模型采用d3qn,利用两个dqn对信号控制策略进行训练,通过当前网络选择最大q值对应的动作,再获取此动作在目标网络中的q值,使每次选择的动作q值不是最大,减轻对q值的过度估计,缓解模型的过拟合问题,当前网络的优化目标表示为:

[0026][0027]

其中r为奖励,γ为折扣因子,w为当前网络的参数,w-为目标值网络的参数。d3qn还对网络结构进行优化,将状态动作对的q值拆分为两部分进行输出,一部分代表环境状态本身具有的价值函数v(s),另一部分表示通过选择动作带来的额外价值,称为优势函数a(s,a),则q值可以改写为:

[0028]

q(s,a)=v(s) a(s,a)

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(3)

[0029]

接下来定义强化学习的三要素状态、动作和奖励。

[0030]

状态包含路网中车辆的数目、速度和加速度信息,首先按照一定距离比例将车道分为若干元胞,图2所示的是以十字路口西向车道为例的状态设计图,包含了元胞的长度信息。其中,右边的两条车道看作一个整体划分,最左边的左转车道单独划分,靠近红绿灯的部分以7m为单位划分5个元胞,之后依次以10m、25m、40m、160m以及230m划分元胞,这样路口一个方向的车道将划分为20个元胞,一个路口将划分为80个元胞。计算每个元胞中车辆的数目、平均速度和平均加速度,作为数目向量、速度向量和加速度向量,这三个向量构成环境的状态。

[0031]

动作采用的是切换路口红绿灯的状态,让更多车辆快速地通过路口。动作组a=

{nsg,nslg,ewg,ewlg},包括4个动作,每个动作执行的时间都是3秒。其中,nsa表示南北方向直行和右转绿灯,nsla表示南北方向左转绿灯,ewa表示东西方向直行和右转绿灯,ewla表示东西方向左转绿灯。对于直行和右转动作,设置绿灯时长最短12s,最长60s,对于左转动作,设置绿灯时长最短12s,最长24s。agent在绿灯和红灯切换期间,会先执行时长3s的黄灯。

[0032]

奖励表示的是agent执行一个动作之后环境反馈的奖励,本发明中定义为执行动作期间队列长度、等待时间、车辆总延误、通过路口的车辆数目以及通过路口车辆的通行时间的加权和,表示为:

[0033]rn 1

=α1*ln α2*wn α3*dn α4*nn α5*tnꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(4)

[0034]

其中r

n 1

表示执行第n个动作后环境反馈给agent的奖励,ln表示执行第n个动作期间的总队列长度,wn表示所有车辆的等待时间,dn表示所有车辆的延误,nn表示通过交叉口的车辆数目,tn表示通过路口车辆的通行时间之和,α1、α2、α3、α4、α5表示加权系数,本发明中分别设为-0.5、-0.25、-0.5、1、0.5。

[0035]

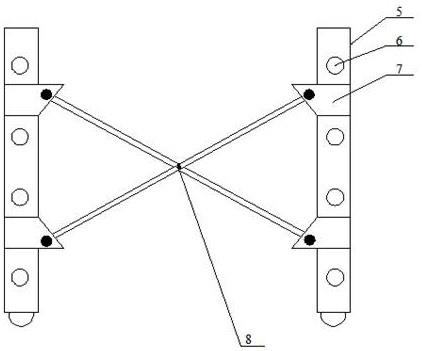

对于多路口,用marl的方法控制交通信号,每个路口的交通信号都由一个agent控制,采用状态信息交互和空间折扣因子来实现多智能体协作。以2

×

2的井字形路网为例,每个路口都是等价的。对于左上方的路口,其agent的输入状态除了当地路口的交通信息,还包括右上方路口以及左下方路口相连车道的交通信息,奖励为所有路口奖励的加权和,表示为:

[0036]

r=β1r

tl

β2r

tr

β3r

ll

β4r

lr

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(5)

[0037]

其中r表示左上方agent的奖励,r

tl

、r

tr

、r

ll

、r

lr

表示左上、右上、左下、右下方路口的奖励,β1、β2、β3、β4表示加权系数,本发明中分别定义为0.5、0.2、0.2、0.1。

[0038]

步骤3:使用lstm预测未来的微观状态,对k个时间步后的数目向量、速度向量和加速度向量进行预测,预测步数k由网络学习得到,当前状态记为s,预测状态记为s

p

,结合状态预测的d3qn算法下最优动作价值函数的优化目标表示为:

[0039][0040]

步骤4:d3qn使用经验回放来更新目标价值,将agent与环境交互获得的样本(s,a,r,s')存入经验池中,从经验池均匀采样小批量样本,使用随机梯度下降方法训练深度神经网络使其逼近q值,随机采样能够打破样本间的强相关性,使训练收敛稳定,经验回放的流程图如图3所示。drl相关超参数设置如下:训练回合数为400、经验池最小尺寸为2000、最大尺寸为100000、折扣因子为0.85。q网络为全连接神经网络,使用均方误差损失函数,选用adam优化器,相关超参数设置如下:深度为5、宽度为400、学习率为0.001、批处理大小为128、训练迭代次数为800。lstm预测网络采用二值交叉熵作为损失函数,选用adam优化器,相关超参数设置如下:单元数为6、层数为3、神经元个数为160、批处理大小为128、训练迭代次数为1。

[0041]

步骤5:用sumo生成的车流数据对步骤4训练好的模型进行测试,并与韦伯斯特配时控制、车辆驱动控制、不加预测的d3qn控制比较,评价指标包括平均等待时间t

wt

、平均队列长度l、平均行驶时间t

at

、平均co排放d

co

、平均co2排放表示为:

[0042][0043]

其中n表示车辆总数,t表示每回合的时长,wn

t

表示t时刻路网中停止车辆的总数,l

t

表示t时刻路网的队列总长度,n

t

表示t时刻路网中运行车辆的总数,co

t

表示t时刻路网中排放的co总量,co

2t

表示t时刻路网中排放的co2总量。

[0044]

本发明利用离散交通状态编码(discrete traffic state encoding,dtse)设计简洁且高效的状态,使用动态分配、卡尔曼滤波或神经网络等方法预测未来的交通状态,agent根据当前状态和预测状态进行最优决策,从而缩短车辆的等待时间,提高路网的通行效率。本发明对促进短时交通预测、强化学习技术在智能交通信号控制领域的研究和发展具有积极的理论意义与应用价值。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。