基于gpu资源在人工智能与工程领域调度系统及优化算法

技术领域

1.本发明涉及计算机技术,特别是涉及一种基于gpu资源在人工智能与工程领域调度优化算法。

背景技术:

2.对人工智能与工程领域计算平台上的gpu资源需求,基于gpu不同于cpu的特性,在一定规格的服务器上cpu数量时恒定的,而gpu在每台服务器上的数量极有可能不一致,而传统的基于cpu的调度方式,能够基于恒定数量的cpu资源进行调度,但是无法调度数量不确定的gpu资源,这就使得传统的cpu资源调度技术不适用于gpu资源调度。

3.目前,gpu资源调度的技术主要有:nvidia gpu docker、slurm,nvidia gpu docker技术能够实现批处理调度,但是无法实现交互式高性能调度,没有优先级调度算法;slurm属于开源技术,调度算法弱,无交互式与优先级。这两种技术均由国外研发,使用广泛,客户群体广,但局限于调度cpu,无法满足专业领域使用的不同节点不同gpu数量的调度要求,更无法跨节点调度gpu,而且都是国外研发,存在安全隐患。

技术实现要素:

4.有鉴于现有技术的上述缺陷,本发明所要解决的技术问题是提供一种基于gpu资源在人工智能与工程领域调度系统及优化算法,其能够实现对gpu资源的高效调度。

5.为实现上述目的,本发明提供了一种基于gpu资源在人工智能与工程领域调度系统,包括:人家交互模块,用于使操作者可视化操作,且将客户端操作3d模型的指令输送至服务器,服务器端计算3d模型的运算量后反馈回客户端,从而通过云计算的方式使得客户端操作3d模型与在服务器端操作3d模型无异;资源管理模块,将能使用的gpu资源组建为gpu资源池,gpu资源池由数个节点构成,每个节点对应一台设备,每个节点gpu的内部多卡id关系及节点gpu可用资源变化均实时反馈至gpu资源池,以便于资源管理模块动态管理;各gpu周期性向资源管理模块反馈使用状态,包括gpu空闲状态、gpu资源利用率、任务完成,资源管理模块获得任务完成信号后,会释放该gpu资源,以便于后续任务使用;调度模块,对人机交互模块输入的任务进行运算量预算,根据预算的运算量分配gpu资源,以实现在提高运算速度和合理利用gpu资源之间的平衡。

6.进一步地,调度模块的调度方式包括:1)自主识别模型规模与匹配调度,根据输入的任务预算所需的算力,然后根据所需算力分配gpu资源进行运算;2)先入先出,根据任务预算所需gpu资源后,根据每个节点的gpu资源匹配任务,优先将任务分配给同一节点,同时优先将任务分配至空闲gpu运算,当gpu对应多个任务时,依次排队运算;

3)最优解,根据任务量及当前gpu资源状态,在不影响其他任务计算的前提下选择最快运算的gpu资源;4)优先级,按照紧急情况划分优先级级别,划分依据采用预设阈值;需要在任务中分配优先级时,直接在任务中赋予一个优先级参数,调度模块根据任务携带的优先级参数与各优先级阈值比对,换算任务优先级级别,然后根据优先级级别优先使用gpu资源,优先级默认按照最优解方式分配gpu资源,对于优先级较高的任务,则采用最短时间原则,优先占用最优gpu资源;在对应gpu有优先权的优先运算优先权任务,对应gpu存在多个优先权的根据优先权参数值排队依次计算,对应gpu有多个优先权且优先权参数相等的,根据先进先出原则排队运算。

7.更进一步地,而模型量预算的方式主要有:根据模型量预算,利用3d模型的数据量作为标准,预算完成指定任务所需运算量;根据输入值预算,将操作者在客户端输入的运算量作为预算运算量;根据运算量预算算法预算,建立运算量评估模型,利用大量的运算数据进行训练,使得运算量预算算法可与根据当前任务的特征自动估算所需运算量;动态调节,在运算过程中,监控运算进度,如果运算进度低于预期则增加gpu资源,如果运算进度高于预期则适当减少gpu资源,以保证各个运算任务的快速、流畅进行。

8.本发明还公开了一种基于gpu资源在人工智能与工程领域调度优化算法,包括:s100、资源管理模块动态更新gpu资源池信息;s200、操作者在客户端通过人机交互模块输入需要运算的任务,需要运算的任务上传至服务器端,服务器端转送至调度模块进行处理; s300、调度模块首先检查任务中是否包含优先级参数,如果包含有优先级参数,则进入优先级调度,如果没有则进行普通的调度方式调度。

9.进一步地,s100中还包括:s110、周期性向各个gpu请求信息,各个gpu根据请求信息反馈信号,gpu资源池根据反馈的信号判断该gpu是否能正常使用,从而及时发现不能使用的gpu,以在后续的任务分配中避免使用该gpu;s120、在各个节点的gpu数量增减时,该节点向gpu资源池发送更新信息,gpu资源池根据此信息更新该节点的gpu资源;s130、在运算过程中,各节点收集其内部gpu的状态信息并周期性反馈至资源管理模块,gpu的状态信息包括gpu的空闲状态、gpu运行时的资源利用率、任务完成状态,资源管理模块获得任务完成状态信息后会释放该gpu的算力,从而进入下一任务的运算,且根据各gpu的状态对其进行任务指派。

10.更进一步地,s300中还包括:s310、按照紧急情况划分优先级级别,划分依据采用预设阈值;需要在任务中分配优先级时,直接在任务中赋予优先级参数,调度模块根据任务携带的优先级参数与各优先级阈值比对,换算任务优先级级别,然后根据优先级级别优先使用gpu资源;优先级默认按照最优解方式分配gpu资源,对于优先级较高的任务,则采用最短时间原则,优先占用最优gpu资源;

在对应gpu有优先权的优先运算优先权任务,对应gpu存在多个优先权的根据优先权参数值排队依次计算,对应gpu有多个优先权且优先权参数相等的,根据先进先出原则排队运算。

11.更进一步地,s300中还包括:s320、普通调度方式包括:s321、自主识别模型规模与匹配调度,根据输入的任务预算所需的算力,然后根据所需算力分配gpu资源进行运算;s322、先入先出,根据任务预算所需gpu资源后,根据每个节点的gpu资源匹配任务,优先将任务分配给同一节点,同时优先将任务分配至空闲gpu运算,当gpu对应多个任务时,依次排队运算;s323、最优解,根据任务量及当前gpu资源状态,在不影响其他任务计算的前提下选择最快运算的gpu资源。

12.本发明还公开了一种3d模型的交互方法,应用了上述的优化方法;具体包含以下步骤:s1、客户端获取用户输入的交互操作指令,然后将交互操作指令传输至服务器端;s2、服务器端根据获取的交互操作指令完成图形运算,获得运算过程的图形变化量;s3、服务器端对s2中获得的图形变化量按桢提取信息形成图像集,然后将图像集按照视频流编码后压缩,并将压缩后的图像集传送至客户端;s4、客户端接收到压缩图像集后进行解码,按照视频流的信息连续播放,以实现对用户输入的交互操作指令进行反馈。

13.本发明的有益效果是:1、本发明根据自动发现与编排技术方法,在接受到一个任务需求后,根据任务要求的资源数量,实现动态建立灵活的临时gpu资源池组,以响应不同的人工智能与工程领域应用计算需求,任务计算结束,gpu资源组释放,gpu回归共享资源池,实现满足人工智能的大规模算力要求。

14.2、本发明调度模块的调度算法支持cpu下的多种模式,最优解调度、先入先出调度、自主识别模型规模与匹配调度等,通过算法对平台算力的分析,寻找空闲满足条件的资源匹配任务,运行仿真任务,计算完成,自主释放,接受下一个任务。

15.3、本发明通过对gpu资源调度算法优化,将gpu资源的利用率进行分析,并且通过调度系统实时反馈给用户,用户提交的任务通过调度系统自动分配给空闲的gpu资源,进行计算,从而不占用cpu数量和服务器,实现性能快速提升。

16.4、本发明通过对任务的数据自动分析优先级,分析的方法根据用户提交的参数与标准库对比,寻找出最优解决方案,然后同时进行优先级算法调度,满足重要任务优先执行;5、本发明十分适用于具有专业图形要求的所有工业设计与仿真领域,涵盖影视设计、生物与基因、航空航天航发、汽车制造与零部件、模具、芯片与半导体、核工业、工业与民用电器、气象等领域。

附图说明

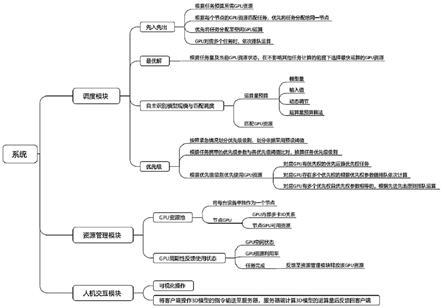

17.图1是本发明的系统构成示意图。

具体实施方式

18.下面将结合本发明实施例中的附图,对本发明实施例中的技术方案进行清楚、完整地描述。

19.参见图1,一种基于gpu资源在人工智能与工程领域调度系统,包括:人家交互模块,用于使操作者可视化操作,且将客户端操作3d模型的指令输送至服务器,服务器端计算3d模型的运算量后反馈回客户端,从而通过云计算的方式使得客户端操作3d模型与在服务器端操作3d模型无异;资源管理模块,将能使用的gpu资源组建为gpu资源池,gpu资源池由数个节点构成,每个节点对应一台设备,每个节点gpu的内部多卡id关系及节点gpu可用资源变化均实时反馈至gpu资源池,以便于资源管理模块动态管理,如增减gpu数量时,将相应信息结合节点信息反馈至gpu资源池,从而使得gpu资源池对该节点的gpu数量、资源等信息进行增减。各gpu周期性向资源管理模块反馈使用状态,主要是gpu空闲状态、gpu资源利用率、任务完成,资源管理模块获得任务完成信号后,会释放该gpu资源,以便于后续任务使用。

20.调度模块,对人机交互模块输入的任务进行运算量预算,根据预算的运算量分配gpu资源,以实现在提高运算速度和合理利用gpu资源之间的平衡。

21.调度模块的调度方式包括:1、自主识别模型规模与匹配调度,根据输入的任务预算所需的算力,然后根据所需算力分配gpu资源进行运算。而模型量预算的方式主要有:根据模型量预算,利用3d模型的数据量作为标准,预算完成指定任务所需运算量。

22.根据输入值预算,将操作者在客户端输入的运算量作为预算运算量。

23.根据运算量预算算法预算,建立运算量评估模型,利用大量的运算数据进行训练,使得运算量预算算法可与根据当前任务的特征自动估算所需运算量。

24.动态调节,在运算过程中,监控运算进度,如果运算进度低于预期则增加gpu资源,如果运算进度高于预期则适当减少gpu资源,以保证各个运算任务的快速、流畅进行。

25.2、先入先出,根据任务预算所需gpu资源后,根据每个节点的gpu资源匹配任务,优先将任务分配给同一节点,同时优先将任务分配至空闲gpu运算,当gpu对应多个任务时,依次排队运算。

26.3、最优解,根据任务量及当前gpu资源状态,在不影响其他任务计算的前提下选择最快运算的gpu资源。

27.4、优先级,按照紧急情况划分优先级级别,划分依据采用预设阈值。需要在任务中分配优先级时,直接在任务中赋予一个优先级参数,调度模块根据任务携带的优先级参数与各优先级阈值比对,换算任务优先级级别,然后根据优先级级别优先使用gpu资源,优先级默认按照最优解方式分配gpu资源,对于优先级较高的任务,则采用最短时间原则,优先占用最优gpu资源。在对应gpu有优先权的优先运算优先权任务,对应gpu存在多个优先权的根据优先权参数值排队依次计算,对应gpu有多个优先权且优先权参数相等的,根据先进先出原则排队运算。

28.本实施的调度模块将gpu资源最大化利用,本实施例将调度模块集成为jss针for gpu,对gpu模式的调度与传统的cpu不同,调度模块首先得分析出不同的节点的gpu资源的空闲状态,并且同时分析出gpu内部的多卡id之间的关系,并且记录到jss的gpu资源池,实时反馈状态,然后根据任务对gpu的需求与实现gpu资源池相结合,可同时实现在高达10000个服务器节点间的8000块gpu资源高性能高速调度,实现任务的有序执行、自动排队、优先级调度、按需分配资源等。

29.一种基于gpu资源在人工智能与工程领域调度优化算法,包括:s100、资源管理模块动态更新gpu资源池信息,更新方式主要是周期性向各个gpu请求信息,各个gpu根据请求信息反馈信号,gpu资源池根据反馈的信号判断该gpu是否能正常使用,从而及时发现不能使用的gpu,以在后续的任务分配中避免使用该gpu。另外在各个节点的gpu数量增减时,该节点向gpu资源池发送更新信息,gpu资源池根据此信息更新该节点的gpu资源。在运算过程中,各节点收集其内部gpu的状态信息并周期性反馈至资源管理模块,gpu的状态信息包括gpu的空闲状态、gpu运行时的资源利用率、任务完成状态,资源管理模块获得任务完成状态信息后会释放该gpu的算力,从而进入下一任务的运算,且根据各gpu的状态对其进行任务指派。

30.s200、操作者在客户端通过人机交互模块输入需要运算的任务,需要运算的任务上传至服务器端,服务器端转送至调度模块进行处理;本实施例中,人机交互模块将客户端操作3d模型的指令输送至服务器,服务器端计算3d模型的运算量后反馈回客户端,使得客户端操作大型3d模型与在服务器端操作无异。

31.s300、调度模块首先检查任务中是否包含优先级参数,如果包含有优先级参数,则进入优先级调度,如果没有则进行普通的调度方式调度。

32.s310、优先级为按照紧急情况划分优先级级别,划分依据采用预设阈值;需要在任务中分配优先级时,直接在任务中赋予优先级参数,调度模块根据任务携带的优先级参数与各优先级阈值比对,换算任务优先级级别,然后根据优先级级别优先使用gpu资源;优先级默认按照最优解方式分配gpu资源,对于优先级较高的任务,则采用最短时间原则,优先占用最优gpu资源;在对应gpu有优先权的优先运算优先权任务,对应gpu存在多个优先权的根据优先权参数值排队依次计算,对应gpu有多个优先权且优先权参数相等的,根据先进先出原则排队运算;s320、普通调度方式主要有:s321、自主识别模型规模与匹配调度,根据输入的任务预算所需的算力,然后根据所需算力分配gpu资源进行运算。而模型量预算的方式主要有:根据模型量预算,利用3d模型的数据量作为标准,预算完成指定任务所需运算量;根据输入值预算,将操作者在客户端输入的运算量作为预算运算量;根据运算量预算算法预算,建立运算量评估模型,利用大量的运算数据进行训练,使得运算量预算算法可与根据当前任务的特征自动估算所需运算量;动态调节,在运算过程中,监控运算进度,如果运算进度低于预期则增加gpu资源,如果运算进度高于预期则适当减少gpu资源,以保证各个运算任务的快速、流畅进行。

33.s322、先入先出,根据任务预算所需gpu资源后,根据每个节点的gpu资源匹配任

务,优先将任务分配给同一节点,同时优先将任务分配至空闲gpu运算,当gpu对应多个任务时,依次排队运算;s323、最优解,根据任务量及当前gpu资源状态,在不影响其他任务计算的前提下选择最快运算的gpu资源。

34.本发明还公开了一种3d模型的交互方法,应用了上述的优化方法;具体包含以下步骤:s1、客户端获取用户输入的交互操作指令,然后将交互操作指令传输至服务器端;s2、服务器端根据获取的交互操作指令完成图形运算,获得运算过程的图形变化量;s3、服务器端对s2中获得的图形变化量按桢提取信息形成图像集,然后将图像集按照视频流编码后压缩,并将压缩后的图像集传送至客户端;s4、客户端接收到压缩图像集后进行解码,按照视频流的信息连续播放,以实现对用户输入的交互操作指令进行反馈。

35.本发明未详述之处,均为本领域技术人员的公知技术。

36.以上详细描述了本发明的较佳具体实施例。应当理解,本领域的普通技术人员无需创造性劳动就可以根据本发明的构思作出诸多修改和变化。因此,凡本技术领域中技术人员依本发明的构思在现有技术的基础上通过逻辑分析、推理或者有限的实验可以得到的技术方案,皆应在由权利要求书所确定的保护范围内。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。