1.本发明涉及一种基于小世界现象的文本聚类方法,具体是涉及利用文本结构的小世界现象计算词的聚类权重,选择聚类权重大的词作为聚类中心进行文本聚类,从而改进传统的无监督聚类中随机选择聚类中心的方法。

背景技术:

2.文本聚类是自然语言处理领域的基础问题,主要包括划分型算法,层次型算法及基于密度的算法等。

3.k

‑

means算法是最经典的划分型聚类算法,采用距离作为相似性的评价指标,即空间上的两个节点距离越近,其相似度也越大。初始聚类中心随机选择,并由启发式算法经过多轮迭代,采用簇中样本均值更新聚类中心。这种算法复杂度低,易于实现。但是需要预先指定分组数目k,但若缺少先验知识,很难预先确定k值。另外初始的随机聚类中心对最终的聚类结果及运行效率都有很大的影响。k

‑

medoids改进了k

‑

means中聚类中心更新的方法,选取簇中到所有样本点距离和最小的样本点作为聚类中心。因此相较于k

‑

means,k

‑

medoids对噪音样本的干扰具有较强的鲁棒性,但是仍然存在预先确定分组k及初始随机选择聚类中心的问题。

4.层次聚类方法包括自底向上层次聚类和自顶向下层次聚类。自底向上的方法初始假设每个样本都是一个簇,自底向上不断选择最近的簇进行合并,直到所有的簇都合并到一个簇中或满足某个给定条件为止。自顶向下聚类则相反,初始状态所有样本同属于一个簇,按照一定规则不断将簇分裂,直至最终每个样本自身为一个簇。

5.基于密度的聚类方法以样本集在空间上分布的密度作为划分类的依据。预先给定密度阀值,若某个空间区域中的样本密度超过阀值,就把该区域的所有样本划入临近的分区中。该方法无需预先设定聚类分组数目,适合对未知样本数据集进行聚类操作。但阀值的设定会影响聚类效果,如阀值过大可能导致同一类被分割,而阀值较小可能导致不同类聚集。

技术实现要素:

6.本发明的目的在于针对k

‑

means及k

‑

medoids随机指定聚类中心的迭代式聚类方法,提出一种基于小世界现象的聚类中心计算方法,具体是利用文本结构的小世界现象计算词的聚类权重及聚类概率,选择聚类概率大的词作为聚类中心进行文本聚类,从而提升聚类效果,缩减聚类迭代时间。

7.为达到上述目的,本发明采用下述技术方案:

8.一种基于小世界现象的文本聚类方法,具体步骤如下:

9.1)将文本集合中的所有文本首尾相接,合并为一个长文本;

10.2)对该长文本进行预处理,包括分词、词性标注和去除停用词,保留所有的名词和动词;

11.3)将所有的名词和动词构建成一个词网络;

12.4)计算词网络中每个词的聚类系数;

13.5)根据步骤4)所得的聚类系数,计算每个词的聚类权重;

14.6)将所有词的聚类权重进行softmax归一化,得到每个词的聚类概率;

15.7)将词按照其聚类概率从大到小排列,选择topk个词作为聚类中心,对所有文本进行kmeans聚类,输出聚类准确度。

16.所述步骤3)中将所有的名词和动词构建成一个词网络,该词网络的节点是词。若两个词在一个句子中共同出现,则把这两个词节点连起来形成一条边。

17.所述步骤4)中计算词网络中每个词的聚类系数,对于一个词v

i

,其聚类系数c(v

i

)计算公式如下:

[0018][0019]

其中,neg

i

为词v

i

的邻居个数,sum(neg

i

)为词v

i

的邻居之间的边数,i=1

…

n,n为词网络的词数量。

[0020]

所述步骤5)中计算每个词的聚类权重,对于一个词v

i

,其聚类权重cw(v

i

)计算公式如下:

[0021]

cw(v

i

)=cc(v

i

)

×

freq(v

i

)

[0022]

其中freq(v

i

)为词v

i

的词频。

[0023]

所述步骤6)将所有词的聚类权重进行softmax归一化,得到每个词v

i

的聚类概率cp(v

i

),其计算公式如下:

[0024][0025]

其中j=1

…

n,n为词网络的词数量。

[0026]

本发明的文本聚类方法与现有的技术相比较,具有如下突出优点:

[0027]

本发明的聚类权重法计算简单,易于实现,缩减聚类迭代时间,提高聚类准确度。

附图说明

[0028]

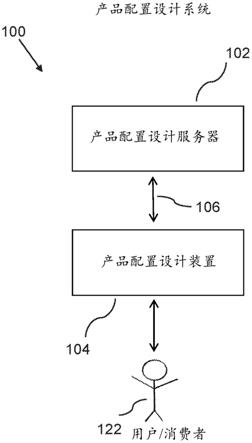

图1是本发明的一种基于小世界现象的文本聚类方法的流程图。

[0029]

图2是本发明方法的聚类中心所得的混淆矩阵示意图。

[0030]

图3是kmeans的聚类中心所得的混淆矩阵示意图。

具体实施方式

[0031]

以下结合附图对本发明的实施例作进一步的说明。

[0032]

本发明的实施例,从知网(https://www.cnki.net/)搜索下载10个领域的共计1000篇文章,每个领域100篇。10个领域为:机器学习,计算机视觉,系统结构,天文学,物理,音乐,电力,经济,公共卫生和地理。为方便在后续图表中简洁标示,将这10个领域依次标注为第0~第9类。

[0033]

如图1所示,本发明的基于小世界现象的文本聚类方法,其步骤如下:

[0034]

1)将文本集合中的所有文本首尾相接,合并为一个长文本。

[0035]

2)对该长文本进行预处理,包括分词、词性标注和去除停用词,保留所有的名词和动词。

[0036]

3)将所有的名词和动词构建成一个词网络;该词网络的节点是词。若两个词在一个句子中共同出现,则把这两个词节点连起来形成一条边。

[0037]

4)计算词网络中每个词的聚类系数;对于每个词v

i

,其聚类系数c(v

i

)计算公式如下:

[0038][0039]

其中,neg

i

为词v

i

的邻居个数,sum(neg

i

)为词v

i

的邻居之间的边数,i=1

…

n,n为词网络的词数量。

[0040]

5)根据步骤4)所得的聚类系数,计算每个词的聚类权重;对于每个词v

i

,其聚类权重cw(v

i

)计算公式如下:

[0041]

cw(v

i

)=cc(v

i

)

×

freq(v

i

)

[0042]

其中freq(v

i

)为词v

i

的词频。

[0043]

6)将所有词的聚类权重进行softmax归一化,得到每个词的聚类概率cp(v

i

),其计算公式如下:

[0044][0045]

其中j=1

…

n,n为词网络的词数量。

[0046]

7)将词按照其聚类概率从大到小排列,选择top k个词作为聚类中心,对所有文本进行kmeans聚类,输出聚类准确度。

[0047]

本实施例的一个实验例如下:

[0048]

随机从10类文献文本中每类中随机选取m篇,共10

×

m篇文本,以本发明的方法及kmeans方法分别得出10个聚类中心。然后再将每类文献文本中剩余的(100

‑

m)篇,共10

×

(100

‑

m)篇文本分别以这两种聚类中心作为标准进行聚类,相似度计算方法为欧氏距离。如图2所示,为m=20时,用本发明方法的聚类中心进行聚类所得的混淆矩阵。如图3所示,为m=20时,用kmeans方法的聚类中心进行聚类所得的混淆矩阵。两个混淆矩阵的纵坐标代表真实的类别编号,横坐标是聚类相似度算法计算出的文本所在类别,即预测类别编号。

[0049]

表1为m分别为20、40、60和80时,本发明方法的聚类中心与kmeans方法的聚类中心进行聚类的macro

‑

f1值。

[0050]

表1.kmeans与本发明方法比较

[0051][0052]

由此表1可知,本发明的聚类中心选取方法比kmeans的自动迭代出的聚类中心在准确性上有明显提升。

[0053]

上面对本发明实施例结合附图进行了说明,但本发明不限于上述实施例,还可以根据本发明的发明创造的目的做出多种变化,凡依据本发明技术方案的精神实质和原理下做的改变、修饰、替代、组合或简化,均应为等效的置换方式,只要符合本发明的发明目的,只要不背离本发明的技术原理和发明构思,都属于本发明的保护范围。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。