技术特征:

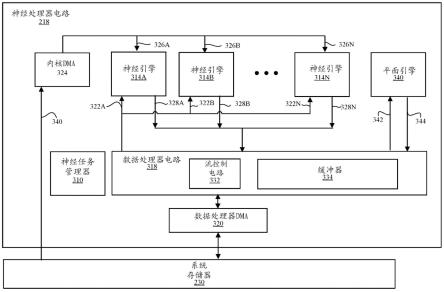

1.一种神经处理器,包括:多个神经引擎电路,所述神经引擎电路中的至少一个神经引擎电路被配置为执行第一输入数据与一个或多个内核的卷积操作以生成第一输出;以及耦接到所述多个神经引擎电路的平面引擎电路,所述平面引擎电路被配置为通过以下方式生成第二输出:响应于将所述平面引擎电路置于池化模式下而缩减由所述平面引擎接收的第二输入数据的版本的空间尺寸,所述第二输入数据对应于所述第一输出或所述神经处理器的输入数据的版本,以及响应于将所述平面引擎电路置于逐元素模式下而对所述第二输入数据执行逐元素操作,所述第二输入数据对应于所述第一输出或所述神经处理器的输入数据的版本。2.根据权利要求1所述的神经处理器,还包括耦接到所述多个神经引擎电路和所述平面引擎电路的数据处理器电路,所述数据处理电路被配置为缓冲所述第一输出以用于发送给所述平面引擎电路或缓冲所述第二输出以用于发送给所述多个神经引擎。3.根据权利要求1所述的神经处理器,其中所述平面引擎电路包括:第一滤波器电路,所述第一滤波器电路被配置为在所述池化模式下缩减所述第二输入数据的所述版本的第一维度的第一尺寸以生成中间数据,以及第二滤波器电路,所述第二滤波器电路被配置为在所述池化模式下缩减所述中间数据的第二维度的第二尺寸以生成所述第二输出的版本。4.根据权利要求3所述的神经处理器,其中所述平面引擎电路还包括位于第一滤波器电路与所述第二滤波器电路之间的行缓冲器电路,所述行缓冲器电路被配置为存储所述中间数据以用于发送给所述第二滤波器电路。5.根据权利要求3所述的神经处理器,其中所述第一滤波器电路或所述第二滤波器电路中的至少一者被配置为在所述逐元素模式下对所述第二输入数据的版本执行所述逐元素操作。6.根据权利要求3所述的神经处理器,其中所述平面引擎电路还包括耦接到所述第一滤波器电路的格式转换器,所述格式转换器被配置为对所述第二输入数据执行一个或多个格式转换以生成所述第二输入数据的所述版本。7.根据权利要求1所述的神经处理器,其中所述卷积操作是用于实施机器学习模型的多个操作中的一个操作。8.根据权利要求1所述的神经处理器,其中所述平面引擎电路还被配置为在缩减模式下缩减张量的秩。9.根据权利要求8所述的神经处理器,其中所述平面引擎电路包括滤波器电路,所述滤波器电路被配置为:缩减在所述池化模式下接收的所述第二数据的所述空间尺寸,在所述逐元素模式下执行一个或多个张量的版本的所述逐元素操作,以及在所述缩减模式下生成标量值。10.根据权利要求1所述的神经处理器,其中所述第一输入数据表示跨多个通道的数据,并且所述第二输入数据表示所述通道之一中的数据。11.根据权利要求1所述的神经处理器,其中所述逐元素操作包括张量相加、逐元素最

大值、逐元素最小值、或逐元素相乘中的一者或多者。12.根据权利要求1所述的神经处理器,其中所述平面引擎电路的电路在从所述池化模式切换到所述逐元素模式时被重新配置。13.一种用于操作神经处理器的方法,所述方法包括:传输第一输入数据给所述神经处理器的多个神经引擎电路中的至少一个神经引擎电路;使用所述多个神经引擎电路中的所述至少一个神经引擎电路执行所述第一输入数据与一个或多个内核的卷积操作以生成第一输出;传输第二输入数据给所述神经处理器的平面引擎电路,所述平面引擎电路耦接到所述多个神经引擎电路;在所述平面引擎电路处通过响应于将所述平面引擎电路置于池化模式下而缩减所述第二输入数据的版本的空间尺寸来从所述第二输入数据生成第二输出,所述第二输入数据对应于所述第一输出或所述神经处理器的输入数据的版本,所述第二输入数据对应于所述第一输出或所述神经处理器的输入数据的版本;以及在所述平面引擎电路处通过响应于将所述平面引擎电路置于逐元素模式下而缩减所述第二输入数据的版本的空间尺寸来从所述第二输入数据生成第二输出。14.根据权利要求13所述的方法,其中缩减所述平面引擎在所述池化模式下接收的第二输入数据的所述版本的所述空间尺寸包括:利用第一滤波器电路缩减所述第二输入数据的所述版本的第一维度的第一尺寸以生成中间数据;以及利用第二滤波器电路缩减所述中间数据的第二维度的第二尺寸以生成所述第二输出的版本。15.根据权利要求14所述的方法,其中缩减所述平面引擎在所述池化模式下接收的第二输入数据的所述版本的所述空间尺寸还包括:在所述第一滤波器电路与所述第二滤波器电路之间的行缓冲器电路处存储所述中间数据以用于发送给所述第二滤波器电路。16.根据权利要求14所述的方法,其中在所述逐元素模式下执行所述第二输入数据的所述逐元素操作包括利用所述第一滤波器电路或所述第二滤波器电路中的至少一者执行所述逐元素操作。17.根据权利要求13所述的方法,其中所述卷积操作是用于实施机器学习模型的多个操作中的一个操作。18.根据权利要求13所述的方法,还包括在缩减模式下缩减张量的秩。19.一种电子设备,包括:存储机器学习模型的存储器;以及神经处理器,所述神经处理器包括:多个神经引擎电路,所述神经引擎电路中的至少一个神经引擎电路被配置为执行第一输入数据与一个或多个内核的卷积操作以生成第一输出;以及耦接到所述多个神经引擎电路的平面引擎电路,所述平面引擎电路被配置为通过以下方式生成第二输出:

响应于将所述平面引擎电路置于池化模式下而缩减所述平面引擎所接收的第二输入数据的版本的空间尺寸,所述第二输入数据对应于所述第一输出或所述神经处理器的输入数据的版本,以及响应于将所述平面引擎电路置于逐元素模式下而对所述第二输入数据执行逐元素操作,所述第二输入数据对应于所述第一输出或所述神经处理器的输入数据的版本。20.根据权利要求19所述的电子设备,其中所述卷积操作是用于实施机器学习模型的多个操作中的一个操作。

技术总结

实施方案涉及一种神经处理器,该神经处理器包括多个神经引擎电路和一个或多个平面引擎电路。该多个神经引擎电路能够执行神经引擎电路的输入数据与一个或多个内核的卷积操作以生成输出。该平面引擎电路耦接到该多个神经引擎电路。该平面引擎电路从对应于神经引擎电路的输出或神经处理器的输入数据的版本的输入数据生成输出。平面引擎电路可被配置到多种模式。在池化模式下,平面引擎电路缩减输入数据的版本的空间尺寸。在逐元素模式下,平面引擎电路对输入数据执行逐元素操作。在缩减模式下,平面引擎电路缩减张量的秩。平面引擎电路缩减张量的秩。平面引擎电路缩减张量的秩。

技术研发人员:C

受保护的技术使用者:苹果公司

技术研发日:2020.09.23

技术公布日:2022/7/15

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。