本公开涉及机器人的控制装置、机器人的控制方法以及程序。

背景技术:

传统上,关于机器人装置及其控制方法,下面提到的专利文献1描述了分别由加速度传感器和旋转角传感器检测加速度信息和旋转角信息,并且将检测到的信号按时间序列存储到储存单元中,并然后根据存储的时间序列信号计算诸如方差的特定信息,从而从特定信息判定机器人装置的状态。

现有技术文献

专利文献

专利文献1:日本专利第4517509号

技术实现要素:

技术问题

作为宠物饲养的动物在与人类交流时会执行各种动作。同样关于机器人等,期望动物型机器人等执行与实际动物的动作相似的动作。

然而,尽管在上述专利文献中描述的技术设想了基于加速度信息和旋转角信息来判定机器人的状态,但没有设想在用户抱起机器人的情况下,机器人执行与实际动物的动作类似的动作。

因此,要求在机器人被用户抱起的情况下,执行与实际动物的动作类似的动作。

问题的解决方案

根据本公开,提供了一种机器人的控制装置,包括:判定部,判定机器人被抱起;旋转角度获取部,获取在机器人被抱起的状态下机器人旋转时的旋转角度;以及驱动控制部,基于旋转角度控制机器人的可移动部的驱动,使得可移动部朝向预定方向。

此外,根据本公开,提供了一种机器人的控制方法,包括:判定机器人被抱起;获取在机器人被抱起的状态下机器人旋转时的旋转角度;以及基于该旋转角度控制机器人的可移动部的驱动,使得可移动部朝向预定方向。

此外,根据本公开,提供了一种程序,用于使计算机用作:用于判定机器人被抱起的装置、用于获取在机器人被抱起的状态下机器人旋转时的旋转角度的装置、以及用于基于该旋转角度控制机器人的可移动部的驱动以使得可移动部朝向预定方向的装置。

附图说明

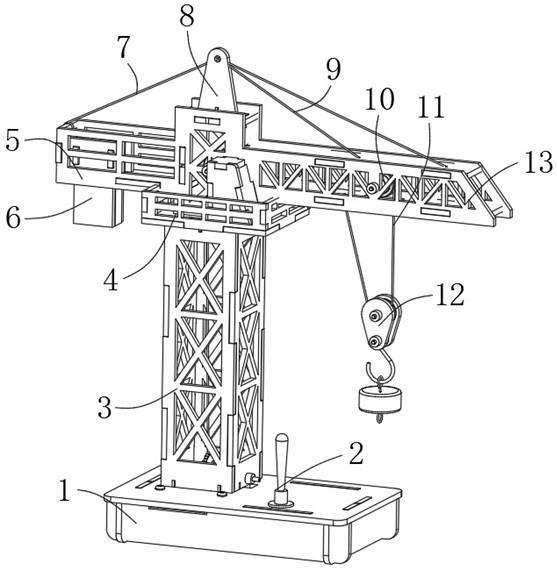

图1是示出机器人装置的外观和关节的旋转轴的示意图。

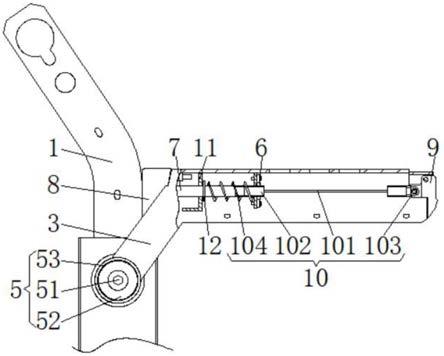

图2是示出机器人装置的头部的示意图。

图3是示出用于控制机器人装置的系统的配置的示意图。

图4是示出用户抱起机器人装置的状态的示意图。

图5是示出了在存在多个人的情况下确定目标位置的坐标的方法的示意图。

图6a是示出了要由控制部执行的处理的流程图。

图6b是详细示出了用于在图6a的步骤s12确定(更新)目标坐标的处理的流程图。

具体实施方式

以下,参考附图详细描述本公开的优选实施例。应当注意,在本说明书和附图中,具有基本相同功能配置的相同部件由相同的附图标记表示,并且省略它们的重叠描述。

需要注意的是,按照以下顺序给出描述。

1.机器人装置的配置

2.面部到目标的跟踪控制

3.根据抱起的面部朝向控制

4.控制变化

5.控制部执行的过程

1.机器人装置的配置

图1是示出根据本公开的实施例的机器人装置1000的外观和关节的旋转轴的示意图。机器人装置1000包括四个爪100、110、120以及130,每个爪100、110、120以及130由诸如伺服电动机的电动机驱动。

如图1所示,机器人装置1000包括多个关节部。这里,为了便于描述,将机器人装置1000根据动作分类为右前爪系统、左前爪系统、右后爪系统、左后爪系统、主体(身体)系统以及头部系统。右前爪系统包括关节部102、另一关节部104以及又一关节部106。左前爪系统包括关节部112、另一关节部114以及又一关节部116。右后爪系统包括关节部122、另一关节部124以及又一关节部126。左后爪系统包括关节部132、另一关节部134以及又一关节部136。此外,主体系统包括关节部142。头部系统包括关节部152、另一关节部154、又一关节部156以及再一关节部158。这些系统连接到主体140。应当注意的是,图1中所示的关节部表示主要关节部,每个主要关节部由电动机驱动。除了图1所示的关节部之外,还包括关节部,机器人装置1000还包括这样的关节部:每个关节部根据不同关节部的动作而被动地移动。此外,机器人装置1000包括诸如嘴、耳朵以及尾巴的多个可移动部,并且每个可移动部也由电动机等驱动。

在图1中,每个关节部用圆柱体表示。在每个关节部,圆柱体的中心轴对应于关节部的旋转轴。在头部系统中,由于设置了关节部152,因此实现了从正面观察机器人装置1000时的向左和向右倾斜头部的动作。同时,在主体系统中,由于设置了关节部142,因此实现了在从上方观察机器人装置1000时的左右方向上晃动臀部的动作。因此,机器人装置1000能够实现比以往更多的各种动作。

各关节部由伺服电动机等电动机(以下简称为电动机)驱动。需要注意的是,驱动源没有特别限定。每个关节部处的电动机与齿轮机构、编码器和用于驱动电动机的微控制器一起容纳在一个箱体(盒体)中。该箱体由树脂材料(塑料等)配置。通过将电动机和齿轮机构容纳在一个箱体中密封,可以提高机器人装置1000的安静性能。

以右后爪系统为例,用于关节部132和关节部134的电动机、齿轮机构、编码器以及微控制器容纳在一个箱体中,并且该箱体配置一个旋转轴。同时,在头部系统中,三轴的旋转轴由关节部152、关节部154以及关节部156配置。

要注意的是,通过在一个箱体中容纳两个轴的旋转轴,可以实现球形关节。此外,通过在一个箱体中容纳两个轴的旋转轴,可以抑制用于关节部的空间,并且可以在聚焦设计的情况下确定机器人装置1000的形状。

上面描述的诸如右前爪系统等的系统分别由包括在每个关节部中的微型计算机控制。例如,关节部中的头部系统的关节部158被配置成使得被电制动。如果在电源断开时或类似情况下允许关节部158自由旋转,则存在头部向下移动并接触用户的手等的可能性。通过制动关节部158,可以避免如上所述的这种情况。该制动可以通过这样的方法来实现:当电源断开时,基于由关节部158的电动机的旋转而产生的电动势来判定电动机的旋转,并且使在与电动机趋于旋转的方向相反的方向上产生驱动力。

图2是示出机器人装置1000的头部150,特别是面部的示意图。图2所示的机器人装置1000的眼睛350被配置为根据机器人装置1000的动作执行各种运动和显示。为此,机器人装置1000在左眼350和右眼350中的每一个中包括自发光型显示器件(oled)。

2.面部到目标的跟踪控制

现在,描述在机器人装置1000被用户抱起的情况下执行的机器人装置1000的面部(头部)到对象的跟踪控制。在根据本实施例的机器人装置1000中,可以根据用户的抱起动作将面部连续地指向感兴趣的对象。该动作对应于诸如狗的动物的动作,例如在狗被抱起并且动物的方向被改变的情况下,即使身体的朝向改变狗也继续观察感兴趣的对象。通过实施如上所述的这样的动作,机器人装置1000的动作可以进一步模仿实际动物的动作。然后,由于机器人装置1000根据用户的动作执行动作,因此可以展现机器人装置1000对对象感兴趣,并且机器人装置1000可以执行与用户的密切交互,并且可以增强交互的价值。应当注意的是,尽管在以下描述中描述了面部到对象的跟随控制,但是面部是示例,并且还可以控制除面部之外的任选的可移动部,使得可移动部的朝向跟随对象。例如,可以控制手的朝向以便跟踪对象。

图3是示出用于控制机器人装置1000的控制装置2000的配置的示意图,并且示出用于执行面部的跟踪控制的配置。控制装置2000包含在机器人装置1000中。如图3所示,控制装置2000被配置为包括驱动单元200、角度获取单元300、特征识别单元400、感情和性格获取单元500、以及控制部600。

驱动单元200对应于每个关节部的电动机、编码器以及齿轮机构。角度获取单元300由惯性测量单元(imu:inertialmeasurementunit)配置,并且在机器人装置1000被用户抱起并且移动的情况下,检测机器人装置1000的三个轴(偏航、俯仰、滚动)的旋转角度。

特征识别单元400被配置为包括照相机,并且对照相机的捕获图像执行图像处理,以识别捕获图像的特征。如图2所示,照相机700安装在机器人装置1000的鼻子上,并且照相机700对应于特征识别单元400的照相机。

特征识别单元400可以执行例如面部识别处理,以识别与机器人装置1000具有特定关系的人,诸如机器人装置1000的所有者(以下将该人称为所有者等)、与机器人装置1000具有亲密关系的所有者等以外的人等。要注意的是,通过预先保留所有者等和具有亲密关系的人的面部图像,并且将捕获的面部图像与保留的面部图像进行比较,来执行面部识别处理。此外,特征识别单元400可以包括3d照相机,使得获取到图像捕获目标的距离。此外,特征识别单元400可以包括tof传感器,并且可以从tof传感器检测对象的深度信息。

感情和性格获取单元500获取机器人装置1000的感情和性格。机器人装置1000可以根据当前状态被设置为多个感情中的任一个。感情和性格获取单元500获取针对当前时间点设置的机器人装置1000的感情。作为感情的设定,“愤怒”、“快乐”、“悲伤”等等都是可用的。

此外,机器人装置1000具有先天或后天设定的性格。感情和性格获取单元500获取机器人装置1000的设定性格。作为设定的感情,“狂野”、“可爱”、“害羞”、“爱撒娇”等等都是可用的。

控制部600基于从驱动单元200、角度获取单元300、特征识别单元400以及感情和性格获取单元500获得的信息来执行机器人装置1000的面部的跟踪控制。为此,控制部600被配置为包括抱起判定部602、目标位置确定部603、旋转角度获取部604、驱动控制部606、坐标变换部608、驱动表现确定部610以及坐标更新部612。应当注意,控制部600的部件可以由电路(硬件)或诸如cpu的中央处理单元以及用于使中央处理单元工作的程序(软件)来配置。

3.根据抱起的面部朝向控制

现在,描述由控制部600执行的处理。图4是示出用户抱起机器人装置1000的状态的示意图。如果机器人装置1000被用户抱起,则由控制部600的抱起判定部602判定机器人装置1000被抱起。抱起判定部602基于从角度获取部300的imu获取的信息、从安装在机器人装置1000的爪等上的接触检测传感器获取的信息等,判定机器人装置1000被抱起。

然后,在抱起状态下,目标位置确定部603基于从驱动单元200的编码器获得的信息,确定表示面部的朝向的向量(图1所示的向量a)所指向的目标位置(x1、y1、z1)的坐标。应当注意,在以下描述中,将向量a称为鼻向量a。

特别地,由于每个关节部的角度可以由设置在关节部处的编码器来判定,所以表示面部的朝向的鼻向量a基于判定的角度唯一地判定。目标位置确定部603基于在机器人装置1000被抱起的时刻的面部的朝向,确定例如在鼻向量a的方向上存在的对象为目标,并且基于到该对象的距离来确定目标位置的坐标。应当注意,可以从包括在特征识别单元400中的3d照相机和tof传感器检测到对象的距离。

要注意的是,同时,在上述描述中,本发明提供了一种基于面部在抱起时的朝向来确定目标位置的坐标的方法,目标位置的坐标例如可以是表示机器人装置1000的所有者等的面部的位置的坐标;表示作为所有者等以外的人并且他们的面部图像被存储在机器人装置1000中的特定人的面部的位置的坐标;从特征识别单元400获得的抱起姿势下的头部坐标等。这样的人由如上所述执行面部识别处理的特征识别单元400识别。

在基于从角度获取单元300获得的机器人装置1000的旋转角度使机器人装置旋转90度以上的情况下或类似的情况下,当由特征识别单元400识别的特征位置被更新时,目标位置的坐标被更新。目标位置的坐标由控制部600的坐标更新部612更新。

如果在用户抱起机器人装置1000之后,人为移动机器人装置1000,则鼻向量a从目标位置的坐标(x1,y1,z1)移位。图4示出了用户在箭头标记a1的方向上转动机器人装置1000的方式。此时,由角度获取单元300获取人为移动机器人装置1000时的旋转角度(与目标位置的偏差)。

控制部600的旋转角度获取部604获取由角度获取单元300获取的旋转角度(偏差)。控制部600的坐标变换部608执行用于校正旋转角度的面部的旋转量的算术运算(目标位置的坐标变换)。控制部600的驱动控制部606将旋转量发送到驱动单元200以控制面部的旋转。因此,主要控制头部系统的关节部152、关节部154、关节部156、以及关节部158的电动机,以响应于人为移动机器人装置1000来设定面部的方向,使得鼻向量a指向目标位置的坐标(x1,y1,z1)。在图4的例子中,面部的朝向沿箭头标记a2的方向旋转。因此,可以将面部旋转到面部朝向锁定到原始目标位置的位置。

具体地,可以按照以下方式执行由控制部600执行的上述面部的旋转量的算术运算。在基于从角度获取单元300获得的信息对原始目标位置的坐标(x1,y1,z1)执行偏航(yaw)的α旋转、俯仰(pitch)的β旋转、以及滚动(roll)的γ旋转的情况下,对坐标(x1,y1,z1)依次执行偏航的α旋转、俯仰的β旋转以及滚动的γ旋转,以计算校正后的目标位置的坐标(x4,y4,z4)。另外,机器人装置1000本身的坐标为(0,0,0)。

偏航(yaw)是α旋转

x2=x1

y2=y1cosα–z1sinα

z2=y1sinα z1cosα

俯仰(pitch)是β旋转

x3=x2cosβ z2sinβ

y3=y2

z3=-x2sinβ z2cosβ

滚动(roll)是γ旋转

x4=x3cosγ–y3sinγ

y4=x3sinγ y3cosγ

z4=z3

根据上述,可以根据鼻向量a相对于机器人装置1000的坐标(0,0,0)的方向来计算鼻向量a是否指向目标位置。要注意的是,通过在校正后将面部的方向重新调整到目标位置,可以将面部旋转到面部朝向锁定到原始目标位置的地方。

通过在机器人装置1000被抱起的同时继续上述控制,可以将面部连续地定向到目标位置。因此,能够实现机器人装置1000的面部的朝向跟随感兴趣对象的动作,并且能够允许机器人装置1000产生与实际动物类似的具有活力的运动。

4.控制变化

在下面的描述中,描述由控制部600的控制的变化。控制部600除了根据上述抱起时的角度变化量来校正鼻向量a之外,还根据机器人装置1000的感情或性格来改变用于将面部朝向目标位置的运动的表现,以及通过除头部之外的诸如眼睛350的驱动部来控制该表现。另外,眼睛350的驱动控制也由控制部600的驱动控制部606执行。

为此,控制部600的驱动表现确定部610获取由感情和性格获取单元500获取的机器人装置1000的感情和性格,并且根据机器人装置1000的感情和性格确定运动的表现。驱动控制部606基于由驱动表现确定部610确定的驱动表现来控制驱动单元200。

因此,在驱动控制部606基于人为移动机器人装置1000时的旋转角度执行面部朝向控制的情况下,驱动控制部考虑从感情和性格获取单元500获取的机器人装置1000的感情和性格,来执行面部的朝向控制。

例如,在从感情和性格获取单元500获取的机器人装置1000的性格为“狂野”的情况下,基于从角度获取单元300获取的旋转角度,比通常更快地执行头部向目标位置的运动,并且这表示机器人装置1000的性格是“狂野”。另一方面,在从感情和性格获取单元500获取的机器人装置1000的性格是“害羞”的情况下,基于从角度获取单元300获取的旋转角度缓慢地执行头部向目标位置的运动,并且这表示机器人装置1000的性格是“害羞”。

此外,在从感情和性格获取单元500获取的机器人装置1000的性格是“害羞”的情况下,控制机器人装置1000的头部以外的眼睛350和爪的运动,以执行机器人装置1000害羞的表现。例如,通过延迟返回到目标位置或者通过执行这样的运动以用前爪隐藏面部,可以表示机器人装置1000是害羞的。

另一方面,在从感情和性格获取单元500获取的机器人装置1000的性格是“可爱”的情况下,控制机器人装置1000的眼睛350或爪的运动,以便执行使得机器人装置1000表现出可爱的表现。例如,通过将摆动动作添加到头部返回目标位置的运动中、通过增加眼睛350的眨眼次数、或者通过执行使得前爪细微移动的动作,可以执行使得机器人装置1000表现出可爱的表现。

此外,在从感情和性格获取单元500获取的机器人装置1000的感情是“生气”的情况下,基于从角度获取单元300获取的旋转角度,快速地执行头部到目标位置的运动,就像机器人装置1000生气一样。

当控制部600的驱动控制部606基于人为移动机器人装置1000时的旋转角度来执行面部的朝向控制时,基于旋转角度的大小,也可以改变面部朝向目标位置的运动的表现,或者可以由诸如眼睛驱动单元350的头部驱动单元以外的驱动单元执行该表现的控制。

例如,在旋转角度大于预定值的情况下,控制眼睛350的显示,使得机器人装置1000的眼睛350表示惊讶状态。此外,在旋转角度大于预定值的情况下,驱动控制部606执行驱动单元200的控制,使得采取用前爪隐藏面部的回避危险的姿势。

另一方面,在旋转角度小于预定值的情况下,用于将面部朝向目标位置的控制速度可以被控制为响应于从角度获取单元300获取的旋转角度(旋转角速度)的变化而改变。另一方面,在旋转角度大于预定值的情况下,用于将面部朝向目标位置的控制速度可以被控制为固定的。

此外,将面部朝向目标位置的轨迹可以不是最短轨迹,而是可以响应于机器人装置1000的感情或旋转角度(偏差)而改变。例如,在机器人装置1000的感情是“害羞”的情况下,用于将面部朝向目标位置的轨迹不被确定为最短轨迹,并且可以添加剩余轨迹,使得其表示机器人装置1000是害羞的。

图5是示出在存在多个人的情况下确定目标位置的坐标的方法的示意图。在存在多个人的情况下,机器人装置1000将头部转向箭头标记a3的方向,执行俯视和扫描多个人的运动,并且将诸如所有者等预先识别的人更新为目标坐标。此外,在存在多个人的情况下,可以将中心的人确定为目标位置的坐标。此外,可以获取人的声音,从而将声音发出的方向确定为目标位置。

5.控制执行的过程

图6a是示出了由控制部600执行的处理的流程图。首先,在步骤s10,用户将抱起机器人装置1000。在下一步骤s12,确定目标坐标(x1,y1,z1)。在下一步骤s14,从角度获取单元300获取用户移动机器人装置1000时的旋转角度。

在下一步骤s16,控制部600基于从角度获取单元300获取的旋转角度,通过上述方法执行三维坐标变换。在下一步骤s18,控制部600基于由感情和性格获取单元500获取的机器人装置1000的感情和性格来确定驱动表现。在下一步骤s20,控制部600控制驱动单元200,使得鼻向量a朝向至目标位置。

此外,在步骤s20,控制部600基于在步骤s18确定的驱动表现来控制驱动单元200。因此,根据感情和性格来执行驱动单元200的控制。

在下一步骤s22中,控制部600判定用户对机器人装置1000的抱起是否继续,并且在继续抱起的情况下,处理返回到步骤s12,以执行从步骤s12开始的处理。另一方面,在不继续抱起的情况下,控制部600结束抱起(步骤s24)并且结束步骤s24的处理。

图6b是详细示出了在图6a的步骤s12中确定(更新)目标坐标的处理的流程图。在步骤s26,控制部600判定通过特征识别单元400的图像识别获得的特征点是否已经更新,或者机器人装置1000的偏航轴是否已经旋转90度以上。在步骤s26中判定为特征点已更新或机器人装置1000的偏航轴已经旋转90度以上的情况下,处理前进到步骤s28,在该步骤中,控制部600更新目标坐标。在步骤s28之后,控制部600结束处理。另一方面,在步骤s26判定为特征点没有更新,并且机器人装置1000的偏航轴没有旋转90度以上的情况下,控制部600结束处理,而不将处理前进到步骤s28。

参考附图详细描述了本公开的优选实施例,本公开的技术范围不限于如上所述的这样的示例。显然,在本公开的技术领域中具有公知常识的技术人员可以在权利要求书中描述的技术思想的范围内可以设想各种改变或修改,并且自然地认识到各种改变或修改也属于本公开的技术范围。

此外,本说明书中描述的有利效果是解释性的或示例性的,而不是限制性的。其中,根据本公开的技术可以与上文所述的有利效果一起或代替上文所述的有利效果来展示本领域技术人员显而易见的其他有利效果。

应当注意,如下所述的这种配置也属于本公开的技术范围。

(1)一种机器人的控制装置,包括:

判定部,判定机器人被抱起;

旋转角度获取部,获取在机器人被抱起的状态下机器人旋转时的旋转角度;以及

驱动控制部,基于旋转角度控制机器人的可移动部的驱动,使得可移动部朝向预定方向。

(2)根据上述(1)的机器人控制装置,还包括:

目标位置确定部,将在预定方向上存在的对象的位置确定为可移动部要朝向的目标位置。

(3)根据上述(2)的机器人的控制装置,其中,目标位置确定部将机器人被抱起的时刻可移动部所朝向的对象的位置确定为目标位置。

(4)根据上述(2)的机器人控制装置,还包括:

特征识别单元,识别在预定方向上存在的特定对象的特征,其中,

目标位置确定部将由特征识别单元识别的特定对象的位置确定为目标位置。

(5)根据上述(4)的机器人控制装置,其中

特征识别单元执行面部识别,并且

特定对象是与机器人有特定关系的人。

(6)根据上述(2)至(5)中任一项的机器人的控制装置,还包括:

坐标变换部,基于旋转角度对目标位置执行坐标变换,其中,

驱动控制部控制可移动部的驱动,使得可移动部朝向至坐标变换后的目标位置。

(7)根据上述(2)至(6)中任一项的机器人的控制装置,还包括:

更新部,在机器人执行预定动作时更新目标位置。

(8)根据上述(1)至(7)中任一项的机器人的控制装置,还包括:

获取部,获取与对机器人设定的感情或性格相关的信息;并且

表现确定部,基于与感情或性格相关的信息来确定可移动部的运动的表现,其中,

驱动控制部基于表现控制可移动部的运动。

(9)一种机器人的控制方法,包括:

判定机器人被抱起;

获取在机器人被抱起的状态下机器人旋转时的旋转角度;以及

基于旋转角度控制机器人的可移动部的驱动,使得可移动部朝向预定方向。

(10)使计算机起作用的程序:

用于判定机器人被抱起的装置;

用于获取在机器人被抱起的状态下机器人旋转时的旋转角度的装置;以及

用于基于旋转角度控制机器人的可移动部的驱动,使得可移动部朝向预定方向的装置。

附图标记列表

602:抱起判定部

603:目标位置确定部

604:旋转角度获取部

606:驱动控制部

608:坐标转换部

610:驱动表现确定部

1000:机器人装置

2000:控制装置。

本文用于企业家、创业者技术爱好者查询,结果仅供参考。