1.本发明涉及数据处理技术领域,尤其涉及一种基于深度特征与梯度信息的数据重建方法、系统、中心服务器及计算机可读存储介质。

背景技术:

2.近年来,随着数据的爆发式增长以及计算机软硬件的飞速发展,人工智能技术在各个领域取得了长足的进步,而深度学习技术便是人工智能最重要的代表技术之一。

3.深度学习在图像分类、图像分割以及语音识别领域都取得了非常大的进步发展。深度学习的模型训练有两种方式,一种是集中式中心训练,即由中心服务器收集所需要的训练数据,将数据聚集到中心服务器上并在中心服务器上训练模型。

4.然而,由于现实世界中数据往往分布在个人设备(如智能手机)中,由于法律或者数据传输成本的限制,中心式收集数据的方法往往会受到很多限制,制约了模型的使用场景。因此,另外一种训练方式被提出,这种方式不需要对训练数据进行集中收集,仅利用设备本地数据在本地设备上训练模型,然后将训练的梯度或者模型参数信息发送给中心服务器进行聚合,以此协同多个参与设备共同训练深度学习模型,这种方法被称为协作学习。

5.另外,深度学习模型的性能取决于训练数据的数量以及质量,而且当用于查询模型的数据与训练数据分布相似或者一致时,才能使模型发挥最大的效能。而在协作学习中,由于各个参与设备分布在不同的节点,有可能导致数据偏差较大,从而导致协作学习训练效果较差。

6.例如,在协作训练一个广告推荐模型中,不同参与者之间的年龄分布可能不一样,从而导致协作训练不准确。另外,对于一个协作训练的模型,需要根据每个参与者的数据进行分析,以此将训练模型进行精确的部署,达到最佳使用效果。例如,在一个协同训练的推荐模型中,将酒类广告信息推荐给未成年人往往是不合适的。因此,需要的是可以根据协作学习中上传的训练梯度或者模型参数信息,对参与者的数据进行精确的推断,以此为不同数据分布时的模型训练添加合适约束以及在模型训练完成后,根据参与者的数据分布进行更好的部署。

7.生成对抗网络是近年来发展非常迅速,是一种无监督的深度学习方法,常被用于生成数据。生成对抗网络通常包含有一个鉴别器以及一个生成器,当训练完成后,将特定的隐变量输入生成器即可生成对应的数据。另外,协作训练提取的深度特征以及上传的相关梯度或者参数信息都包含有本地设备数据的特定信息,可以用于优化寻找合适的隐变量,使得生成对抗网络的生成器生成与训练设备数据相似的数据。

8.例如现有技术一中利用协作学习中上传的本地设备训练时的模型损失对于模型参数的梯度直接对数据进行重建,具体做法为,将随机初始化的训练数据输入模型,计算给数据所对应的损失梯度,然后根据特定的距离函数最小化该损失梯度与上传梯度之间的差距,以此优化随机初始化的数据。这种方法会受到三个方面的影响而导致性能不佳,一是模型结构的影响,当模型越复杂时,重构效果不佳;二是想重建的数据的大小的影响,当想重

建的数据越大时,重构效果不佳;三是训练样本数量的影响,当训练样本数量增大时,重建的效果也不理想。因此,该方法的稳定性通常比较差。

9.另外,例如现有技术二的做法是直接利用生成对抗网络生成与训练数据相似的数据。具体来说,该方法将一个随机初始化的隐变量输入生成对抗网络的生成器中,然后计算生成数据所对应的损失梯度,最小化该损失梯度与本地设备训练后上传的损失梯度之间的差距,以此优化隐变量,使得隐变量更加精准,将隐变量输入生成器生成的模型更加接近原始训练数据。但是,由于训练时采用小批次(mini-batch)训练,梯度是由所有样本加权平均而来,因此该方案的优化信息不够明确,导致该方案仅仅能产生与原始样本分布相似的数据,产生的样本与真实样本的细节之间的差距仍然比较大,无法达到精确重建样本的目的。因此,该方法的准确性比较差。

10.因此,现有技术还有待于改进和发展。

技术实现要素:

11.本发明的主要目的在于提供一种基于深度特征与梯度信息的数据重建方法、系统、中心服务器及计算机可读存储介质,旨在解决现有技术中对训练数据进行重建时稳定性和准确性差的问题。

12.为实现上述目的,本发明提供一种基于深度特征与梯度信息的数据重建方法,所述基于深度特征与梯度信息的数据重建方法包括如下步骤:

13.中心服务器将初始化后的协同学习共享模型发送给各个本地参与设备,各个本地参与设备利用协同学习共享模型计算各自的本地训练数据对应的第一深度特征和反向传播的预测损失相对于模型参数的第一梯度信息,并上传给中心服务器;

14.中心服务器通过协同学习共享模型提取辅助数据集的第二深度特征和对应的第一预测标签,将第二深度特征和第一预测标签拼接后输入特征编码器,特征编码器输出隐变量至生成器,生成器根据隐变量输出目标数据至生成对抗网络中的鉴别器和协同学习共享模型,以训练特征编码器;

15.中心服务器将各个本地参与设备的本地训练数据的第一深度特征和对应的第二预测标签输入训练完成的特征编码器,获取初始化隐变量,并将初始化隐变量输入到生成器,生成器根据初始化隐变量输出初始化目标数据;

16.中心服务器将初始化目标数据和对应的监督信息输入协同学习共享模型,计算初始化目标数据的第二梯度信息,最小化第一梯度信息和第二梯度信息之间的距离,优化初始化隐变量,获得重建目标数据。

17.所述的基于深度特征与梯度信息的数据重建方法,其中,所述特征编码器的损失函数为:

18.;

[0019][0020]

其中,x为训练特征编码器的训练样本,为生成器生成的样本,为将x输入协同学习共享模型预测的标签信息,表示交叉熵损失函数,f

vgg

是一个预训练的vgg网络,用于提取感知损失,λ

lpips

和λ

adv

是可调整的超参数,用于各个损失之间的权重分配,

指取均值,表示鉴别器对的预测分数。

[0021]

所述的基于深度特征与梯度信息的数据重建方法,其中,所述鉴别器的损失函数为:

[0022][0023]

其中,指取均值,表示鉴别器对的预测分数,d(x)表示鉴别器对x的预测分数,γ是一个超参数,表示d(x)对x求偏导,是一个稳定项,用于保证鉴别器训练时的稳定性。

[0024]

所述的基于深度特征与梯度信息的数据重建方法,其中,优化初始化隐变量的损失函数为:

[0025][0026]

其中,c为向量余弦相似度计算函数,g为第一梯度信息,为第二梯度信息,z表示初始化隐变量,g(z)表示优化初始化隐变量过程中生成器根据z生成的目标数据,s为输入鉴别器的输出分数,f

tv

(g(z))为计算全变分损失的函数,λ

dis

和λ

tv

为可调整的超参数。

[0027]

所述的基于深度特征与梯度信息的数据重建方法,其中,所述监督信息为与协作学习需要学习的任务相关的监督信息。

[0028]

所述的基于深度特征与梯度信息的数据重建方法,其中,所述隐变量和所述初始化隐变量为输入所述生成器的变量。

[0029]

所述的基于深度特征与梯度信息的数据重建方法,其中,所述目标数据包括图片、语音和文本。

[0030]

此外,为实现上述目的,本发明还提供一种基于深度特征与梯度信息的数据重建系统,其中,所述基于深度特征与梯度信息的数据重建系统包括:

[0031]

特征信息收集模块,用于中心服务器将初始化后的协同学习共享模型发送给各个本地参与设备,各个本地参与设备利用协同学习共享模型计算各自的本地训练数据对应的第一深度特征和反向传播的预测损失相对于模型参数的第一梯度信息,并上传给中心服务器;

[0032]

特征编码器训练模块,用于中心服务器通过协同学习共享模型提取辅助数据集的第二深度特征和对应的第一预测标签,将第二深度特征和第一预测标签拼接后输入特征编码器,特征编码器输出隐变量至生成器,生成器根据隐变量输出目标数据至生成对抗网络中的鉴别器和协同学习共享模型,以训练特征编码器;

[0033]

第一数据重建模块,用于中心服务器将各个本地参与设备的本地训练数据的第一深度特征和对应的第二预测标签输入训练完成的特征编码器,获取初始化隐变量,并将初始化隐变量输入到生成器,生成器根据初始化隐变量输出初始化目标数据;

[0034]

第二数据重建模块,用于中心服务器将初始化目标数据和对应的监督信息输入协同学习共享模型,计算初始化目标数据的第二梯度信息,最小化第一梯度信息和第二梯度信息之间的距离,优化初始化隐变量,获得重建目标数据。

[0035]

此外,为实现上述目的,本发明还提供一种中心服务器,其中,所述中心服务器包

括:存储器、处理器及存储在所述存储器上并可在所述处理器上运行的基于深度特征与梯度信息的数据重建程序,所述基于深度特征与梯度信息的数据重建程序被所述处理器执行时实现如上所述的基于深度特征与梯度信息的数据重建方法的步骤。

[0036]

此外,为实现上述目的,本发明还提供一种计算机可读存储介质,其中,所述计算机可读存储介质存储有基于深度特征与梯度信息的数据重建程序,所述基于深度特征与梯度信息的数据重建程序被处理器执行时实现如上所述的基于深度特征与梯度信息的数据重建方法的步骤。

[0037]

本发明通过中心服务器将初始化后的协同学习共享模型发送给各个本地参与设备,各个本地参与设备利用协同学习共享模型计算各自的本地训练数据对应的第一深度特征和反向传播的预测损失相对于模型参数的第一梯度信息,并上传给中心服务器;中心服务器通过协同学习共享模型提取辅助数据集的第二深度特征和对应的第一预测标签,将第二深度特征和第一预测标签拼接后输入特征编码器,特征编码器输出隐变量至生成器,生成器根据隐变量输出目标数据至生成对抗网络中的鉴别器和协同学习共享模型,以训练特征编码器;中心服务器将各个本地参与设备的本地训练数据的第一深度特征和对应的第二预测标签输入训练完成的特征编码器,获取初始化隐变量,并将初始化隐变量输入到生成器,生成器根据初始化隐变量输出初始化目标数据;中心服务器将初始化目标数据和对应的监督信息输入协同学习共享模型,计算初始化目标数据的第二梯度信息,最小化第一梯度信息和第二梯度信息之间的距离,优化初始化隐变量,获得重建目标数据。本发明通过利用协作学习训练过程中提取的深度特征以及相关损失梯度寻找训练数据的隐变量,然后利用隐变量以及生成器对训练数据进行重建,最终获得精确的重建数据。

附图说明

[0038]

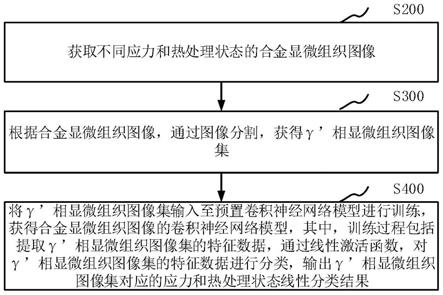

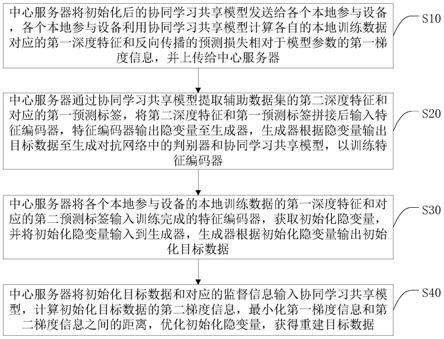

图1是本发明基于深度特征与梯度信息的数据重建方法的较佳实施例的流程图;

[0039]

图2是本发明基于深度特征与梯度信息的数据重建方法的较佳实施例中表明了整体方法的模型框架图;

[0040]

图3是本发明基于深度特征与梯度信息的数据重建方法的较佳实施例中重建训练数据的流程图;

[0041]

图4是本发明基于深度特征与梯度信息的数据重建方法的较佳实施例中重建效果图对比图;

[0042]

图5是本发明基于深度特征与梯度信息的数据重建系统的较佳实施例的原理示意图;

[0043]

图6为本发明中心服务器的较佳实施例的运行环境示意图。

具体实施方式

[0044]

为使本发明的目的、技术方案及优点更加清楚、明确,以下参照附图并举实施例对本发明进一步详细说明。应当理解,此处所描述的具体实施例仅仅用以解释本发明,并不用于限定本发明。

[0045]

本发明较佳实施例所述的基于深度特征与梯度信息的数据重建方法,如图1-图3所示,所述基于深度特征与梯度信息的数据重建方法包括以下步骤:

[0046]

步骤s10、中心服务器将初始化后的协同学习共享模型发送给各个本地参与设备,各个本地参与设备利用协同学习共享模型计算各自的本地训练数据对应的第一深度特征和反向传播的预测损失相对于模型参数的第一梯度信息,并上传给中心服务器。

[0047]

具体地,所述中心服务器将初始化协同学习共享模型c(即图2中的共享模型c)发送给各个本地参与设备,本地参与设备指的是将数据留在本地,利用协作训练过程中交换的梯度信息参与协作学习(协作学习:多个参与者利用自己的本地数据共同训练同一个机器学习模型,在此过程中,参与者不需要交换自己的本地数据,而是交换用于模型参数更新的梯度信息。)的参与者,例如,本地参与设备可以是智能手机、个人电脑等设备,本地参与设备在本地数据上随机采用一批本地训练数据用于训练,根据本地参与设备的本地训练数据计算其对应的深度特征(即第一深度特征)以及反向传播的损失相对于模型参数(模型参数是共享模型的参数,模型由一系列参数组成,也可称为模型的权重)的损失梯度g(即第一梯度信息),并将深度特征与损失梯度g上传给中心服务器用于协作训练。

[0048]

在深度学习训练模型(例如协同学习共享模型c)过程中,需要利用模型学习数据的分布并对模型进行更新,也就是对模型的参数信息进行更新。在此过程中,首先需要计算模型对数据的预测信息与数据的标签信息(监督信息)之间的差别,称为预测损失(或者称为预测误差),然后利用反向传播算法,计算该误差相对于模型参数的梯度信息,再利用梯度下降算法对模型参数进行更新。

[0049]

在此步骤中,协作学习参与者的原始数据未离开本地设备,与所述中心服务器交换的仅仅是协同学习共享模型c提取的深度特征以及相关损失梯度。而此步骤中的一批训练数据是指以此训练过程中采用多个数据样本对协同学习共享模型进行训练,也被称为小批量训练(mini-batch training),样本的多少决定了批次(batchsize)的大小。此步骤中的训练数据与协作学习的训练目的相关,例如,如果协作学习的目的是训练一个人脸识别模型,则这部分数据包含的内容则是人脸图片以及对应的监督标签,监督标签是与协作学习想学习的任务相关的监督信息,例如,如果协作学习想学习一个人脸识别模型,则监督标签应该是人脸的身份信息,如果想学习一个男女性别分辨模型,则监督信息应该是男女标签。

[0050]

步骤s20、中心服务器通过协同学习共享模型提取辅助数据集的第二深度特征和对应的第一预测标签,将第二深度特征和第一预测标签拼接后输入特征编码器,特征编码器输出隐变量至生成器,生成器根据隐变量输出目标数据至生成对抗网络中的鉴别器和协同学习共享模型,以训练特征编码器。

[0051]

具体地,所述中心服务器利用协同学习共享模型c提取辅助数据集数据x的深度特征(即第二深度特征)以及相对应的预测标签(即第一预测标签,辅助数据集不含有任何标签信息,因此利用协作学习共享模型对辅助数据集进行预测,并将其作为该数据集的标签),将深度特征(第二深度特征)与预测标签(第一预测标签)拼接(这是一个矩阵的拼接操作,例如特征矩阵的维度是[5,100],预测标签矩阵的维度是[5,10],则拼接后的矩阵维度为[5,110])输入特征编码器e(如图2所示)获得相对应的隐变量z(指输入生成器的变量),再将隐变量z输入生成器g(generator,用于生成数据的模型,如图2所示)生成相应的目标数据(例如目标数据可以是图片,也可以是语音、文本等其他信息,取决于生成器的类

型)。将生成的目标数据(例如图片)输入生成对抗网络(gan,generative adversarial networks)中的鉴别器d(如图2所示)与协同学习共享模型c,保证生成图片的质量以及生成图片的类别属性,再根据生成数据与原始数据之间差距(例如本发明所使用的生成器是生成图片的生成器,因此生成的是图片,计算差距也就是生成图片与原始图片的差距),从而优化特征编码器e。

[0052]

其中,辅助数据集可以是公开的已有数据集,也可以是中心服务器通过其他渠道获取到数据集,如利用爬虫软件来爬取的数据,在收集数据的过程中,人为打上标签信息往往比较昂贵,因此该数据集不含有任何标签信息;辅助数据集应该与协作学习参与者的数据分布类似,将其用于训练生成器(无监督学习,不需要标签)与特征编码器(利用共享模型提供的预测标签作为学习的监督标签)。

[0053]

在此步骤中,生成器g是利用辅助数据集训练而来,此时的生成器g的参数冻结不再改变,仅用于生成数据。而鉴别器d在训练特征编码器e的过程中,仍然参与训练并且保持参数的更新,具体来说,特征编码器e的损失函数为:

[0054][0055]

其中,x为训练特征编码器的训练样本,为生成器生成的样本,为将x输入协同学习共享模型预测的标签信息;表示交叉熵损失函数;f

vgg

是一个预训练的vgg(visual geometry group)网络,用于提取感知损失lpips loss(learned perceptual image patch similarity,可学习图像块感知相似性);λ

lpips

和λ

adv

是可调整的超参数,用于各个损失之间的权重分配,根据经验可以分别将其设置为0.0001以及0.1;指取均值,表示鉴别器对的预测分数;其中,可以保证生成的图片尽量与原图相似,保证特征编码器e能够根据输入预测标签编码为具有该类别特征的隐变量,用于保证生成图片的质量。

[0056]

另外,鉴别器d的损失函数为:

[0057][0058]

其中,指取均值,表示鉴别器对的预测分数,d(x)表示鉴别器对x的预测分数;γ是一个超参数,根据经验可以将其设置为10;表示d(x)对x求偏导,是一个稳定项,用于保证鉴别器训练时的稳定性。

[0059]

在优化模型(例如特征编码器e与鉴别器d)时,首先需要根据模型的目的计算训练误差,然后利用误差方向传播以及梯度下降优化模型,上述的两个损失函数(特征编码器e的损失函数和鉴别器d的损失函数)为计算特征编码器e与鉴别器d的误差的具体数学表达式。

[0060]

步骤s30、中心服务器将各个本地参与设备的本地训练数据的第一深度特征和对应的第二预测标签输入训练完成的特征编码器,获取初始化隐变量,并将初始化隐变量输入到生成器,生成器根据初始化隐变量输出初始化目标数据。

[0061]

具体地,所述中心服务器将协作学习参与者上传的深度特征(即第一深度特征)与对应的预测标签(即第二预测标签)输入训练完成的特征编码器e(即步骤s20中完成训练的特征编码器e),获得相对应的初始化隐变量z(步骤s20中的隐变量z发生在特征编码器的训练过程,而这里的初始化隐变量z指的是根据训练完成后的特征编码器,将参与设备上传的深度特征编码为初始化隐变量z),然后将初始化隐变量z输入生成器g,获得对应的初始化目标数据(例如初始化图片),其重建效果图如图4(b)所示,图4(a)是原图(原始样本),图4(b)是经过步骤s30重建的图,但是图4(b)的效果是直接利用特征编码器将参与者设备的特征编码为隐变量,然后直接输入生成器产生的图片,该隐变量仍然不够准确;该步骤s30的目的是先将隐变量的搜索空间缩小,获得一个与原始样本向对应的隐变量相近的隐变量,使得步骤s40的想要优化的z先处于真实的z附近,提高优化成功率以及加速优化过程。

[0062]

步骤s40、中心服务器将初始化目标数据和对应的监督信息输入协同学习共享模型,计算初始化目标数据的第二梯度信息,最小化第一梯度信息和第二梯度信息之间的距离,优化初始化隐变量,获得重建目标数据。

[0063]

具体地,将初始化隐变量z生成的初始化目标数据(例如初始化图片)与监督信息输入协同学习共享模型c,计算初始化目标数据所对应的梯度(即第二梯度信息),最小化与g之间的差距,不断优化初始化隐变量z,从而优化生成目标数据,最终获得精确的重建目标数据(例如重建图片)。其中,优化初始化隐变量z的损失函数为:

[0064][0065]

其中,c为向量余弦相似度计算函数,g为第一梯度信息,为第二梯度信息,z表示初始化隐变量,g(z)表示优化初始化隐变量过程中生成器根据z生成的目标数据;s为输入鉴别器d的输出分数,例如将此分数s视为鉴别器d认为生成图s真实时的预测分数;λ

dis

(||d(g(z)-s)||)用于保证优化z的过程中生成的图片仍然真实,即该项保证了优化z的过程中g(z)的真实分数始终保持在一定范围,保证了生成图片的真实性;f

tv

(g(z))为计算全变分(total variation)损失的函数,该函数用于保证相邻像素之间的平滑性;λ

dis

和λ

tv

,为可调整的超参数,可以将其都设置为0.001,其重建效果图如图4(c)所示,这样可以获得更加精确的重建图片。

[0066]

本发明通过利用生成对抗网络以及协作学习中共享模型提取的深度特征、协作学习过程中上传的损失函数关于模型参数的梯度信息,对协作学习本地参与者的数据进行重建;先通过将深度特征以及预测标签输入直接输入特征编码器获得生成器的输入隐变量,根据该隐变量直接重建图片;之后,获得的隐变量再进一步根据相对应的梯度差距进行优化,获得更加精确的重建图片。

[0067]

本发明提出的利用生成对抗网络以及根据协作学习中共享模型提取的深度特征以及上传到中心服务器的相关梯度信息重建本地协作学习参与者训练数据的方法,不会受到模型结构、训练数据大小以及训练批次的影响,能够有更加广泛的应用场景,性能更加稳定;可以更加准确地重建出协作学习参与者的本地数据,本发明的技术方案可以应用于某些要求高精度重建出协作学习参与者数据的场景。

[0068]

进一步地,基于上述基于深度特征与梯度信息的数据重建方法,如图5所示,本发

明还提供一种基于深度特征与梯度信息的数据重建系统,其中,所述基于深度特征与梯度信息的数据重建系统包括:

[0069]

特征信息收集模块51,用于中心服务器将初始化后的协同学习共享模型发送给各个本地参与设备,各个本地参与设备利用协同学习共享模型计算各自的本地训练数据对应的第一深度特征和反向传播的预测损失相对于模型参数的第一梯度信息,并上传给中心服务器;

[0070]

特征编码器训练模块52,用于中心服务器通过协同学习共享模型提取辅助数据集的第二深度特征和对应的第一预测标签,将第二深度特征和第一预测标签拼接后输入特征编码器,特征编码器输出隐变量至生成器,生成器根据隐变量输出目标数据至生成对抗网络中的鉴别器和协同学习共享模型,以训练特征编码器;

[0071]

第一数据重建模块53,用于中心服务器将各个本地参与设备的本地训练数据的第一深度特征和对应的第二预测标签输入训练完成的特征编码器,获取初始化隐变量,并将初始化隐变量输入到生成器,生成器根据初始化隐变量输出初始化目标数据;

[0072]

第二数据重建模块54,用于中心服务器将初始化目标数据和对应的监督信息输入协同学习共享模型,计算初始化目标数据的第二梯度信息,最小化第一梯度信息和第二梯度信息之间的距离,优化初始化隐变量,获得重建目标数据。

[0073]

进一步地,如图6所示,基于上述基于深度特征与梯度信息的数据重建方法,本发明还相应提供了一种中心服务器,所述中心服务器包括处理器10、存储器20及显示器30。图6仅示出了中心服务器的部分组件,但是应理解的是,并不要求实施所有示出的组件,可以替代的实施更多或者更少的组件。

[0074]

所述存储器20在一些实施例中可以是所述中心服务器的内部存储单元,例如中心服务器的硬盘或内存。所述存储器20在另一些实施例中也可以是所述中心服务器的外部存储设备,例如所述中心服务器上配备的插接式硬盘,智能存储卡(smart media card,smc),安全数字(secure digital,sd)卡,闪存卡(flash card)等。进一步地,所述存储器20还可以既包括所述中心服务器的内部存储单元也包括外部存储设备。所述存储器20用于存储安装于所述中心服务器的应用软件及各类数据,例如所述安装中心服务器的程序代码等。所述存储器20还可以用于暂时地存储已经输出或者将要输出的数据。在一实施例中,存储器20上存储有基于深度特征与梯度信息的数据重建程序40,该基于深度特征与梯度信息的数据重建程序40可被处理器10所执行,从而实现本技术中基于深度特征与梯度信息的数据重建方法。

[0075]

所述处理器10在一些实施例中可以是一中央处理器(central processing unit,cpu),微处理器或其他数据处理芯片,用于运行所述存储器20中存储的程序代码或处理数据,例如执行所述基于深度特征与梯度信息的数据重建方法等。

[0076]

所述显示器30在一些实施例中可以是led显示器、液晶显示器、触控式液晶显示器以及oled(organic light-emitting diode,有机发光二极管)触摸器等。所述显示器30用于显示在所述中心服务器的信息以及用于显示可视化的用户界面。所述中心服务器的部件10-30通过系统总线相互通信。

[0077]

在一实施例中,当处理器10执行所述存储器20中基于深度特征与梯度信息的数据重建程序40时实现以下步骤:

[0078]

中心服务器将初始化后的协同学习共享模型发送给各个本地参与设备,各个本地参与设备利用协同学习共享模型计算各自的本地训练数据对应的第一深度特征和反向传播的预测损失相对于模型参数的第一梯度信息,并上传给中心服务器;

[0079]

中心服务器通过协同学习共享模型提取辅助数据集的第二深度特征和对应的第一预测标签,将第二深度特征和第一预测标签拼接后输入特征编码器,特征编码器输出隐变量至生成器,生成器根据隐变量输出目标数据至生成对抗网络中的鉴别器和协同学习共享模型,以训练特征编码器;

[0080]

中心服务器将各个本地参与设备的本地训练数据的第一深度特征和对应的第二预测标签输入训练完成的特征编码器,获取初始化隐变量,并将初始化隐变量输入到生成器,生成器根据初始化隐变量输出初始化目标数据;

[0081]

本发明还提供一种计算机可读存储介质,其中,所述计算机可读存储介质存储有基于深度特征与梯度信息的数据重建程序,所述基于深度特征与梯度信息的数据重建程序被处理器执行时实现如上所述的基于深度特征与梯度信息的数据重建方法的步骤。

[0082]

综上所述,本发明提供一种基于深度特征与梯度信息的数据重建方法、系统、中心服务器及计算机可读存储介质,所述方法包括:中心服务器将初始化后的协同学习共享模型发送给各个本地参与设备,各个本地参与设备利用协同学习共享模型计算各自的本地训练数据对应的第一深度特征和反向传播的预测损失相对于模型参数的第一梯度信息,并上传给中心服务器;中心服务器通过协同学习共享模型提取辅助数据集的第二深度特征和对应的第一预测标签,将第二深度特征和第一预测标签拼接后输入特征编码器,特征编码器输出隐变量至生成器,生成器根据隐变量输出目标数据至生成对抗网络中的鉴别器和协同学习共享模型,以训练特征编码器;中心服务器将各个本地参与设备的本地训练数据的第一深度特征和对应的第二预测标签输入训练完成的特征编码器,获取初始化隐变量,并将初始化隐变量输入到生成器,生成器根据初始化隐变量输出初始化目标数据;中心服务器将初始化目标数据和对应的监督信息输入协同学习共享模型,计算初始化目标数据的第二梯度信息,最小化第一梯度信息和第二梯度信息之间的距离,优化初始化隐变量,获得重建目标数据。本发明通过利用协作学习训练过程中提取的深度特征以及相关损失梯度寻找训练数据的隐变量,然后利用隐变量以及生成器对训练数据进行重建,最终获得精确的重建数据。

[0083]

需要说明的是,在本文中,术语“包括”、“包含”或者其任何其他变体意在涵盖非排他性的包含,从而使得包括一系列要素的过程、方法、物品或者装置不仅包括那些要素,而且还包括没有明确列出的其他要素,或者是还包括为这种过程、方法、物品或者装置所固有的要素。在没有更多限制的情况下,由语句“包括一个

……”

限定的要素,并不排除在包括该要素的过程、方法、物品或者装置中还存在另外的相同要素。

[0084]

当然,本领域普通技术人员可以理解实现上述实施例方法中的全部或部分流程,是可以通过计算机程序来指令相关硬件(如处理器,控制器等)来完成,所述的程序可存储于一计算机可读取的计算机可读存储介质中,所述程序在执行时可包括如上述各方法实施例的流程。其中所述的计算机可读存储介质可为存储器、磁碟、光盘等。

[0085]

应当理解的是,本发明的应用不限于上述的举例,对本领域普通技术人员来说,可以根据上述说明加以改进或变换,所有这些改进和变换都应属于本发明所附权利要求的保

护范围。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。