1.本发明涉及文本和语音处理技术领域,具体涉及一种基于变分自编码器的并行语音合成方法。

背景技术:

2.语音合成是一种将文本转换成语音的技术,是人机语音交互中的关键技术。语音合成的音质和速度是语音合成技术在实际应用中的两项重要指标。在人机语音对话系统中,高音质的合成语音能够拉近人与机器之间的距离,而低时延的语音合成过程则能使用户能够得到迅速的反馈,两者都能改善用户在人机口语对话中的体验。

3.传统的语音合成模型主要存在以下几方面的问题:1)传统参数语音合成模型受限于模型的建模能力,合成语音音质和自然度较差;而基于拼接方法的语音合成模型虽然音质和自然度较高,但是依赖于庞大的语音数据库和详细的切分及标记;2)近年来提出的基于序列到序列神经网络模型的语音合成方法能够生成高音质的语音,但其采用自回归(串行)的方式进行声学特征的预测,合成速度慢,且容易导致合成误差的累积;3)针对自回归语音合成模型速度慢的问题,研究者提出非自回归(并行)语音合成模型,通过对音素级别的时长信息的建模来得到语言学特征和声学特征之间的对齐,进而实现并行地合成全部语音声学特征帧,然而,一方面音素级别时长信息的获取过程较为复杂,另一方面基于音素级别时长信息的对齐将语言学特征进行重复扩充,得到的对齐后的特征不平滑,这会影响合成语音的自然度。

技术实现要素:

4.针对上述问题,本发明提出一种基于变分自编码器的并行语音合成方法,采用变分自编码器的神经网络模型对声学特征和语言学特征的对齐信息以及声学特征的重建过程进行建模,以实现并行的、高质量的语音合成。

5.一种基于变分自编码器的并行语音合成方法,包括如下步骤:s1、接收输入文本,并进行字音转换,得到对应的发音序列;s2、对所述发音序列进行上下文信息的建模和编码,得到包含上下文信息的语言学特征;s3、根据所述语言学特征,预测对应的目标声学特征的帧数;s4、基于所述语言学特征从先验概率分布采样长度为所预测帧数的隐变量;s5、将所述语言学特征对齐到所述隐变量上,从对齐的语言学特征中预测目标声学特征,再将所述目标声学特征转换为语音波形信号输出。

6.进一步地,所述发音序列为音素序列或拼音序列,步骤s2具体包括:将所述音素序列输入基于自注意力机制的文本编码器,首先经过嵌入层查询每个音素对应的神经网络向量表示,再经多层一维卷积神经网络进行预处理以编码时序及上下文信息,然后经过多个自注意力机制模块实现基于语义的上下文信息编码。

7.进一步地,步骤s3具体包括:将所述语言学特征输入训练好的总时长预测器,经过两层全连接网络输出字符级别的时长信息,将各个字符对应的输出进行加和得到所述目标

声学特征的帧数。

8.进一步地,步骤s4具体包括:s41、采样长度为所预测帧数的高斯噪声;s42、以所述语言学特征作为条件输入,利用训练好的隐变量先验概率分布编码器将采样的高斯噪声转换成隐变量先验概率分布;s43、基于所述语言学特征,从所述隐变量先验概率分布采样长度为步骤s3所预测帧数的隐变量。

9.进一步地,步骤s5具体包括:s51、利用训练好的声学解码器,以所述隐变量作为语音声学特征的占位符,将所述语言学特征对齐到所述隐变量上,然后从对齐的语言学特征中预测得到所述目标声学特征;s52、利用声码器将所述目标声学特征转换为语音波形信号输出,实现语音合成。

10.进一步地,还包括引入隐变量后验概率分布编码器,对隐变量后验概率分布编码器、隐变量先验概率编码器、声学解码器和总时长预测器同时进行联合训练的过程;训练时,以语言学特征及声学特征为条件的隐变量后验概率分布输入声学解码器进行声学特征的预测,并通过拉近以语言学特征为条件的隐变量先验概率分布和以语言学特征及声学特征为条件的隐变量后验概率分布之间的kl散度来进行训练。

11.进一步地,训练集中的数据对包含训练文本及其对应的语音波形信号;训练时,将训练文本的语言学特征以及从训练文本的语音波形信号提取到的声学特征一同输入隐变量后验概率分布编码器,建模隐变量后验概率分布。

12.进一步地,在训练过程中,所述隐变量后验概率分布编码器将帧级别隐变量的单个时间步的向量的后验概率分布建模为一个各向同性的高斯分布,并预测各个分布的均值向量和方差向量,以得到所述隐变量后验概率分布。

13.进一步地,在训练过程中,所述隐变量后验概率分布编码器建模所述隐变量后验概率分布,具体包括:从训练文本的语音波形信号提取到的声学特征经过基于全连接网络的预处理模块进行稀疏化后作为查询特征,训练文本的语言学特征作为键特征,通过注意力机制进行查询特征与键特征对齐权重的计算;将训练文本的语言学特征作为值特征根据所述对齐权重进行加权,得到对应于每一帧声学特征的语言学上下文特征;以所述语言学上下文特征为输入,通过两个全连接网络模块分别进行均值和方差的预测,得到隐变量后验概率分布。

14.本发明上述提出的基于变分自编码器的并行语音合成方法,通过变分自编码器帧级别的隐变量对声学特征和语言学特征之间对齐信息的编码,可以将隐变量作为语音声学特征的占位符,通过注意力机制将语言学特征对齐到隐变量上,由于该占位符包含丰富的文本信息和对齐信息,从而可以更好地与语言学特征进行对齐,实现更加高质量的语音合成。隐变量的帧数可根据语言学特征通过神经网络进行有效的预测,对齐后的语言学特征可以通过神经网络被映射到声学特征,从而实现并行的语音合成。由于通过注意力机制得到的对齐的语言学特征是连续的,这有利于提高合成语音的自然度。

15.本发明中引入隐变量可以根据语言学特征从先验概率分布中采样得到,隐变量先验概率分布的学习过程使其包含了语言学特征和声学特征的对齐关系,这为语言学特征序列和隐变量序列的准确对齐提供了依据,从而在高效并行合成的基础上保证了合成语音的自然度,实现了并行的、高质量的语音合成。

16.另外,本发明的训练过程不需要音素级别的时长标签,因而可以实现更加简单的

端到端训练;且语言学特征和声学特征之间的对齐方法采用基于注意力机制的软对齐,不会造成特征序列的不平滑问题,更有利于生成高自然度语音。

17.本发明另还提出一种基于变分自编码器的并行语音合成装置,包括:文本分析模块,文本编码模块,总时长预测器,隐变量先验概率分布编码器,声学解码器和声码器;所述文本分析模块接收输入文本并进行字音转换,得到对应的发音序列;所述文本编码模块连接于所述文本分析模块的输出端,用于对所述发音序列进行上下文信息的建模和编码,得到包含上下文信息的语言学特征;所述总时长预测器连接于所述文本编码模块的输出端,用于根据所述语言学特征,预测对应的目标声学特征的帧数;所述隐变量先验概率分布编码器连接于所述文本编码模块的输出端以及所述总时长预测器的输出端,用于基于所述语言学特征从先验概率分布采样长度为所预测帧数的隐变量;所述声学解码器连接于所述隐变量先验概率分布编码器的输出端,用于将所述语言学特征对齐到所述隐变量上,并从对齐的语言学特征中预测目标声学特征;所述声码器连接于所述声学解码器的输出端,用于将所述目标声学特征转换为语音波形信号输出。

18.进一步地,所述隐变量先验概率分布编码器根据所述语言学特征以及采样的高斯噪声,建模述隐变量先验概率分布,并从所述隐变量先验概率分布中采样长度为预测的帧数的隐变量。

19.进一步地,所述声学解码器以所述隐变量作为语音声学特征的占位符,将所述语言学特征对齐到所述隐变量上,然后从对齐的语言学特征中预测得到所述目标声学特征。

附图说明

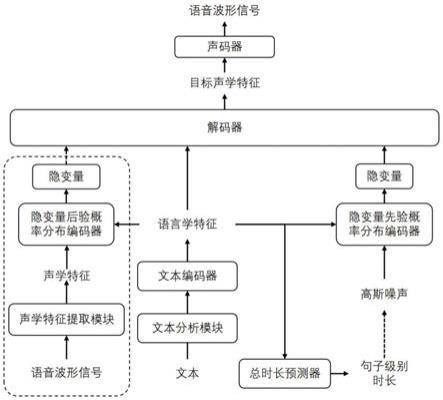

20.图1是本发明实施例基于变分自编码器的并行语音合成装置的原理图;

21.图2是本发明实施例基于变分自编码器的并行语音合成方法的流程图;

22.图3是本发明实施例基于变分自编码器的并行语音合成装置的架构图。

具体实施方式

23.首先,对本发明实施例所涉及的关键技术用语进行解释说明。

24.变分自编码器:一种基于隐变量的神经网络生成模型。其结构包括后验概率分布编码器、先验概率分布编码器和解码器。其中后验概率分布编码器基于输入特征和条件信息建模隐变量的后验概率分布,而先验概率分布编码器则基于条件信息建模隐变量的先验概率分布。解码器负责建模基于隐变量和条件信息恢复输入特征的过程。

25.注意力机制:根据输入查询特征,计算查询特征与键特征序列的相似度,并将相似度计算值特征的加权和作为输出。其本质是建模查询特征与键特征序列的内在对齐关系。

26.声学特征提取模块:接收原始语音波形信号作为输入,通过短时傅里叶变换将时域信号转换成时频声学特征,通常还会将线性频谱特征转换到非线性的梅尔刻度上。

27.字音转换模块:将文本转换成对应发音音素或者拼音序列的模块。

28.文本编码器:基于神经网络的方法对文本发音序列进行处理,输出包含文本上下文发音信息的文本编码,亦即语言学特征。

29.总时长预测器:基于输入的语言学特征预测句子级别的时长,即改句文本对应的声学特征的总帧数。

30.声码器:以语音声学特征为输入恢复语音波形信号的模块。

31.下面结合附图和具体的实施方式对本发明作进一步说明。

32.本发明实施例提出一种基于变分自编码器的并行语音合成装置,图1为该装置的原理图。如图1所示,该装置包括文本分析模块、文本编码模块、总时长预测器、隐变量先验概率分布编码器、声学解码器和声码器。文本分析模块接收输入文本并进行字音转换,得到对应的发音序列;文本编码模块连接于文本分析模块的输出端,用于对所述发音序列进行上下文信息的建模和编码,得到包含上下文信息的语言学特征;所述总时长预测器连接于所述文本编码模块的输出端,用于根据所述语言学特征,预测对应的目标声学特征的帧数;所述隐变量先验概率分布编码器连接于所述文本编码模块的输出端以及所述总时长预测器的输出端,用于基于所述语言学特征从先验概率分布采样长度为所预测帧数的隐变量;所述声学解码器连接于所述隐变量先验概率分布编码器的输出端,用于将所述语言学特征对齐到所述隐变量上,并从对齐的语言学特征中预测目标声学特征;所述声码器连接于所述声学解码器的输出端,用于将所述目标声学特征转换为语音波形信号输出。

33.在一些实施例中,文本分析模块可以通过一层全连接网络实现,包括文本正则化模块和字音转换模块。接收用户输入的文本后,先进行文本正则化,再利用字音转换模块将文本转换成对应的音素序列或拼音序列。

34.在一些实施例中,文本编码模块可以采用transformer模型中的文本编码器,是一种基于自注意力机制的文本编码器。音素序列输入至该文本编码器之后,首先经过嵌入层查询每个音素对应的神经网络向量表示,再经多层一维卷积神经网络进行预处理以编码时序及上下文信息,然后经过多个自注意力机制模块实现基于语义的上下文信息编码。

35.在一些实施例中,总时长预测器可以采用两层全连接网络来实现,其作用是根据输入的语言学特征预测其对应的目标声学特征的帧数,目的是确定目标声学参数的长度以进行相应长度隐变量的采样。具体地,文本编码器输出的语言学特征经过两层全连接网络,得到的输出可认为是字符级别的时长信息,将各个字符对应的输出进行加和得到目标声学参数的总帧数。

36.在一些实施例中,隐变量先验概率分布编码器可以采用glow结构来实现,glow结构是一种神经网络生成模型,可以将简单的概率分布转换成复杂的概率分布。在本发明实施例中,利用glow结构作为隐变量先验概率分布编码器,其作用是建模语言学特征为条件输入的隐变量先验概率分布,并进行隐变量采样。由于隐变量后验概率分布的预测需要参考声学特征,这在推理过程(实际使用过程)中是无法实现的,因此需要隐变量先验概率分布编码器实现在推理过程中基于文本中所提取的语言学特征进行隐变量先验概率分布的建模以及隐变量的采样。隐变量先验概率分布编码器通过glow结构进行建模,glow可以将随机噪声通过一系列可逆变换转换成目标分布。利用这一特性,本发明通过glow建模以语言学特征为条件输入,将高斯噪声转换成隐变量先验概率分布的过程。具体地,本发明首先根据预测的目标声学特征的帧数,采样相同帧数长度的高斯噪声作为隐变量先验概率分布编码器的输入,并以语言学特征作为条件输入,通过glow对该高斯噪声进行多次的转换,在转换过程中通过glow中的耦合网络将语言学特征和隐变量中间特征进行对齐耦合,建模隐变量先验概率分布,最后再基于语言学特征,从所述隐变量先验概率分布采样长度为预测帧数的隐变量,也就是说采样的隐变量具有与目标声学特征相同的帧数。glow中的耦合网

络在本发明的具体实现中也采用了基于多抽头点积的注意力机制。经过多次glow的转换得到的隐变量先验概率分布经训练过程,与隐变量后验概率分布的距离拉近,可得到较为精确的隐变量先验概率分布编码器。基于glow结构,隐变量先验概率分布编码器可以方便地进行隐变量的采样、似然的计算,这为训练过程中损失的计算及推理过程中的隐变量的采样提供了便利。

37.声学解码器的主要作用是根据输入的特征预测目标声学特征。具体地,声学解码器将采样得到隐变量作为语音声学特征的占位符,将输入语言学特征通过注意力机制对齐到隐变量上,从而得到帧级别的对齐的语言学特征。声学解码器的注意力机制依然采用基于多抽头的点积注意力机制。基于对齐的语言学特征,声学解码器最后的模块—基于一维卷积的神经网络模块以帧对帧映射的方法由对齐的语言学特征映射得到目标声学特征。

38.如图3所示,在对前述的装置进行训练时,需要引入隐变量后验概率分布编码器,来同时进行隐变量后验概率分布编码器、对隐变量先验概率编码器、声学解码器和总时长预测器的联合训练。

39.继续参考图3,隐变量后验概率分布编码器的作用是根据语言学特征及其对应的声学特征的真实值(即从训练文本的真实语音波形信号中提取的声学特征)建模隐变量的后验概率分布。利用该隐变量后验概率分布编码器,帧级别隐变量的单个时间步的向量的后验概率分布被建模为一个各向同性的高斯分布,并预测各个分布的均值向量和方差向量。而单个时间步的隐变量后验概率分布则是以声学特征和语言学特征在相应时间步的对齐特征为条件。具体地,声学特征序列经过基于全连接网络的预处理模块进行稀疏化后作为查询特征,文本编码器输出的语言学特征序列作为键特征,通过注意力机制进行二者对齐权重的计算,进而语言学特征序列作为值特征根据该对齐权重进行加权,得到对应于每一帧声学特征的语言学上下文特征,然后以该语言学上下文特征为输入,通过两个全连接网络模块分别进行均值和方差的预测。至此,便可得到隐变量后验概率分布。

40.由于隐变量后验概率分布是基于声学特征和语言学特征的真实值的对齐得到,因此其更能准确地表达隐变量,因此可以作为隐变量先验概率分布编码器的训练参考目标。由隐变量后验概率分布编码器的输入特征和结构也可以得知隐变量所编码的信息应包括语言学信息、声学信息以及二者之间的对齐关系。此外,基于神经网络的隐变量后验概率分布编码器可以方便地进行隐变量的采样、似然值的估计。

41.在一些实施例中,隐变量后验概率分布编码器可以采用transformer模型中的编码器结构。应当理解的是,文本编码器、隐变量先验概率分布编码器和隐变量后验概率分布编码器不限于采用前述所列举的结构,也可以采用其它带有注意力机制的网络结构。

42.本发明的另一实施例给出了基于变分自编码器的并行语音合成方法,图2为该方法的流程图。参考图2,该方法包括如下步骤s1~s5:

43.s1、接收输入文本,并进行字音转换,得到对应的发音序列。

44.具体而言,用户输入的文本先经过正则化,再进行字音转换。通过文本正则化将数字、符号等转换成读音对应的汉字,而字音转换则是将汉字转换成对应的发音序列,例如拼音序列或音素序列。其中,文本正则化的方法可以采用基于规则的文本匹配方法,以将数字、符号等转换成读音对应的汉字。字音转换是将汉字转换成对应的发音序列,例如拼音序列或音素序列。

45.s2、对步骤s1得到拼音序列进行上下文信息的建模和编码,得到包含上下文信息的语言学特征。

46.具体而言,可将步骤s1得到的音素序列输入基于自注意力机制的文本编码器,首先经过嵌入层查询每个音素对应的神经网络向量表示,再经多层一维卷积神经网络进行预处理以编码时序及上下文信息,然后经过多个自注意力机制模块实现基于语义的上下文信息编码。一维卷积一般认为是对局部上下文信息的建模(如前后几个音素),而自注意力机制对全局和局部上下文信息都能较好的建模,一般被认为更能建模语义信息。应当理解的是,此处的上下文信息主要是指对于当前音素对应的声学特征预测有帮助的前后信息,具体可包括当前音素的前后音素以及在所在的音节、词或句子中的位置等。由于语音中协同发音的效应,某个音素的发音会受到前后音素发音的影响,这是建模上下文信息的依据。

47.s3、根据步骤s2得到的语言学特征,预测对应的目标声学特征的帧数。此步骤可采用前述实施例的总时长预测器来实现,具体过程不再赘述。

48.s4、基于所述语言学特征从先验概率分布采样长度为所预测帧数的隐变量。

49.步骤s4可包括如下的具体步骤s41~s43:

50.s41、采样长度为所预测帧数的高斯噪声。通过步骤s3,得到语言学特征的句子级别的时长信息,基于该句子级别的时长信息,采样长度与目标声学特征的帧数相同的高斯噪声。

51.s42、以所述语言学特征作为条件输入,而采样的高斯噪声作为隐变量先验概率分布编码器的输入,利用预先训练的隐变量先验概率分布编码器将采样的高斯噪声转换成隐变量先验概率分布。

52.s43、在步骤s3已预测得到目标声学特征的帧数的基础上,从所述隐变量先验概率分布采样同样帧数的隐变量。

53.步骤s42和s43利用隐变量先验概率分布编码器建模隐变量先验概率分布和采样隐变量的具体过程可参见前述实施例中关于隐变量先验概率分布编码器的描述内容,在此不再赘述。

54.s5、将所述语言学特征对齐到所述隐变量上,从对齐的语言学特征中预测目标声学特征,再将所述目标声学特征转换为语音波形信号输出。

55.步骤s5中,利用预先训练的声学解码器,以所述隐变量作为语音声学特征的占位符,将所述语言学特征对齐到所述隐变量上,然后从对齐的语言学特征中预测得到所述目标声学特征;再利用声码器将所述目标声学特征转换为语音波形信号输出,最终实现语音合成。

56.本发明实施例的模型训练过程如下:

57.训练阶段主要通过三个损失函数来引导模型参数的学习:声学特征的重建损失函数(用于解码器的训练),隐变量先验概率分布和后验概率分布之间的kl散度(隐变量先验概率分布编码器和隐变量后验概率分布编码器的同时训练),声学特征帧数的预测损失函数(总时长预测器的训练)。

58.设为文本编码器输出的语言学特征序列,r代表实数域。其中,n为文本中字符的个数,也即语言学特征序列的序列长度;d1为语言学特征的特征维度。设为解码器预测的声学特征序列,其中,m为声学特征的帧数,也即总时长;d2为声学特征的特征

维度。则声学特征的重建损失函数l1如下所示:

[0059][0060]

其中,t表示声学特征的帧编号,d表示声学特征的特征维度编号,y

td

表示预测得到的声学特征的第t帧中的第d维的数值,y

td

'表示实际声学特征的第t帧中的第d维的数值。

[0061]

令q(z

q

|x,y')和p(z

p

|x)分别表示隐变量的先验概率分布和后验概率分布,其中和分别为从后验概率分布和从先验概率分布中采样得到的隐变量序列,d

z

为隐变量序列的特征维度,即每一帧有d

z

维。训练时取s个<文本

‑

语音波形>数据对进行s个隐变量序列的采样,下式表达了后验概率分布和先验概率分布之间kl散度l2的计算方法:

[0062][0063]

其中,k表示采样的<文本

‑

语音波形>数据对的编号,x

k

、y

k

'表示从数据集中采样的第k组<文本

‑

语音波形>数据对,即x

k

表示文本、y

k

'表示对应的语音波形。设语音声学特征真实值有l'帧,而通过总时长预测器预测得到的总时长为l帧,则声学特征帧数的预测损失函数l3如下所示:

[0064]

l3=(logl

‑

logl')2ꢀꢀꢀꢀꢀꢀ

(3)

[0065]

训练过程中隐变量从后验概率分布中进行采样并输入到声学解码器中进行声学特征的重建,一方面训练解码器,另一方面重建损失函数的梯度回传到隐变量后验概率分布编码器可以引导后验概率分布编码器的学习;隐变量先验概率分布的采样长度由真实声学特征的帧数确定。

[0066]

训练时模型的参数设置简述如下:声学特征提取模块中时频分析设置窗长50毫秒,窗移12.5毫秒,快速傅里叶点数设置为2048,并将频率压缩至mel尺度80维。文本编码器将文本音素、拼音或字母序列嵌入到512维的向量空间中,先通过预处理网络(包括3层一维卷积神经网络,卷积核大小为5,输出维度为512,每层一维卷积后面是修正线性激活单元和层标准化操作),然后经过一个transformer编码器的结构(共包含4层多抽头自注意力机制),注意力机制的抽头数设置为4,输出维度设置为256,最后一层自注意力机制的输出即为文本编码器的输出。隐变量后验概率分布编码器包含依次连接的一个全连接预处理网络、2层transformer中的解码器单元结构和两层全连接网络。隐变量的维度设置为128。隐变量后验概率分布编码器的全连接预处理网络包含两层由修正线性单元激活的全连接网络,其输出单元数设置为256;隐变量后验概率分布解码器的2层transformer中的解码器单元结构,其中多抽头注意力机制的头数设置为4,输出维度设置为256;隐变量后验概率分布编码器的最后两层全连接网络进行隐变量均值向量和方差向量的预测,即输出维度为128。隐变量先验概率分布编码器包含一个glow结构,该glow结构包含6个glow块,每个块包含一层激活标准化层(actnorm layer)、一层可逆一维卷积层(invertible 1x1 convolution)和一层耦合转换层(coupling transform),其中耦合网络层中的转换网络为2层transformer解码器单元结构,其中多抽头注意力机制的输出维度为256,抽头数为4。解码器包含4层transformer解码器单元,与前面相同,多抽头注意力机制的输出维度为256,抽

头数为4,解码器最后是一层全连接层,输出预测的声学特征,输出维度为80。总时长预测器包含2层全连接层,每层由修正线性单元激活,输出维度为1,而句子级别总时长则由各个单元输出加和得到。

[0067]

模型的训练采用adam优化器,学习率固定为1

×

10

‑5,模型的训练可在rtx2080 gpu计算平台上进行,其中每个训练步采样32个<文本

‑

语音波形>数据对,训练过程读取整个数据集2000次进行梯度回传和参数更新后模型即可收敛。

[0068]

经过前述的训练过程,利用前述的并行语音合成装置执行基于变分自编码器的并行语音合成方法,只需要基于给定的文本得到语言学特征,基于语言学特征从先验概率分布采样隐变量,采样的长度由总时长预测器预测得到的声学特征帧数决定;进而将语言学特征和隐变量作为解码器的输入进行声学特征的恢复,最终通过声码器将声学特征转换成语音波形信号输出,即完成了由文本到语音的合成。

[0069]

以上内容是结合具体的优选实施方式对本发明所作的进一步详细说明,不能认定本发明的具体实施只局限于这些说明。对于本发明所属技术领域的技术人员来说,在不脱离本发明构思的前提下,还可以做出若干等同替代或明显变型,而且性能或用途相同,都应当视为属于本发明的保护范围。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。